Synthèse de parole expressive au delà du niveau de la phrase

Parties du Discours

Les parties du discours permettent de classer les mots rencontrés en neuf catégories principales : adjectif, adverbe, article, conjonction, interjection, nom, préposition, pronom et verbe. Selon la procédure d’analyse utilisée, des informations complémentaires sont utilisées pour décrire ces unités lexicales : mode, voix, personne, nombre et temps des verbes, le type de pronom (possessif, démonstratif, indéfini, personnel, relatif), etc. Ces parties du discours ont été obtenues grˆace à deux procédures distinctes. Le premier système d’extraction utilisé est un outil interne du LIMSI. Ce système est basé sur des modèles de Markov cachés (HMM)(Rabiner and Juang, 1986) entraˆınés sur le corpus MULTITAG (Allauzen and Bonneau-Maynard, 2008). Le format d’encodage des informations extraites à l’aide de cette procédure est détaillé dans Rajman et al. (1997). La seconde procédure d’extraction des parties du discours est basée sur des arbres de décision probabilistes (Schmid, 1994). L’outil TreeTagger 1 est utilisé, en se servant des modèles entraˆınés sur la langue française par Stein and Schmid (1995). La table 3.1 décrit l’accord observé entre les deux systèmes d’annotation des parties du discours, en se restreignant aux neuf catégories principales. Pour chaque catégorie morphosyntaxique, le nombre d’unités pour lesquelles les deux systèmes sont en accord est mentionné. Le nombre d’alarmes correspond aux unités d’une catégorie donnée détectées par un seul système. L’accord est estimé à l’aide de la F-Mesure, définie par l’équation 3.1. F = 2 ∗ nb accords 2 ∗ nb accords + AlarmesT ree−T agger + AlarmesHMM (3.1) L’accord estimé sur l’étiquetage varie en fonction des différentes catégories morphosyntaxiques observées. Pour la plupart des catégories, il est supérieur à 90%, à l’exception des interjections (.1%) et des adjectifs (81.3%). Ces différences soulignent la difficulté liée à l’obtention de parties du discours par le biais de procédures automatiques. Cette difficulté peut être partiellement expliquée par les spécificités du matériel utilisé, à savoir des contes pour enfants. La plupart des systèmes d’extraction d’information sont optimisés pour fonctionner sur des articles de journaux ou des textes médicaux (Maarouf and Villaneau, 2012; Goh et al., 2012) et non pas sur des textes de fiction. A défaut de pouvoir connaitre le système d’étiquetage le plus adapté au cas du conte ` pour enfants, les informations obtenues peuvent être combinées pour accroitre la robustesse des systèmes dont le fonctionnement nécessite l’utilisation de parties du discours.

Lemmatisation et Racinisation

La lemmatisation consiste à déterminer la forme canonique d’un mot (par exemple : chevaux → cheval). Pour les verbes il s’agit de l’infinitif, pour les noms et adjectifs il s’agit de la forme masculin singulier. La racinisation, également appelée désuffixation (en anglais stemming) consiste à obtenir la forme tronquée d’un mot, en supprimant ces suffixes et flexions (ex : chevaux → cheva). Bien que les buts de ces procédures soient proches, elles présentent différents avantages et inconvénients. Les procédures de lemmatisation très souvent basées sur des dictionnaires de formes fléchies, ont tendance à échouer à la moindre faute d’orthographe rencontrée. Elles nécessitent de désambig¨uiser le mot considéré, ce qui peut entrainer des erreurs de résolution. Les procédures de racinisation ne nécessitent pas de prendre en compte le contexte des mots rencontrés, et ont l’avantage d’être moins sensibles aux fautes d’orthographe. Elles gèrent relativement mal les différentes flexions pouvant être rencontrées sur les verbes irréguliers. Les lemmes ont été obtenus en utilisant l’algorithme TreeTagger (Schmid, 1994), utilisé avec le fichier de paramètres pour la langue française réalisé par Achim Stein (Stein and Schmid, 1995). Les racines des mots sont obtenues en utilisant les règles exprimées en langage Snowball (Porter, 2001) fournies dans NLTK (Loper and Bird, 2002). La table 3.2 recense quelques exemples illustrant les cas o`u l’usage de ces procédures peut être problématique.

Synsets et Hyperonymes

Les synsets (de l’anglais : synonym set, ensemble de synonymes) sont des ensembles de mots interchangeables dans un contexte donné (exemple : manger, déjeuner, se nourrir, grignoter, …). Les mots polysémiques (qui ont plusieurs sens) appartiennent à plusieurs synsets. Les hyperonymes sont des catégories dont le sens inclut celui d’un autre mot (fruit est un hyperonyme de kiwi, pomme, orange). L’annotation des synsets et hyperonymes a été réalisée en utilisant la base de données WOLF (Sagot et al., 2008), qui est une traduction en Français du projet anglophone Wordnet (Miller, 1995). Chaque mot de la base est associé à une liste de synsets correspondant à ses différentes significations. La probabilité d’appartenance d’un mot à un synset est également mentionné. Les synsets y sont organisés sous forme d’ontologie : c’est-à-dire sous forme d’arbre défini tel que le père d’un noeud soit son hyperonyme. L’étiquetage des synsets et des hyperonymes a consisté à faire correspondre les mots aux synsets pour lesquels ils ont la plus grande probabilité d’appartenance (sans prise en compte du contexte d’apparition). Chaque mot a été associé à l’identifiant numérique de son synset, ainsi qu’aux identifiants de ses hyperonymes pour des profondeurs fixées.

Structure Syntaxique

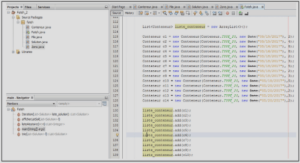

La structure syntaxique des textes est représentée sous forme d’arbre syntaxique abstrait, comme illustré par la figure 3.1. L’arbre est obtenu à partir de règles opérant sur les parties du discours obtenues à l’aide du système décrit précédemment (Allauzen and Bonneau-Maynard, 2008). Les règles de construction de l’arbre sont définies pour être utilisées avec le moteur d’expressions régulières WMATCH (Galibert, 2009; Rosset et al., 2009). Ce moteur permet de générer des structures arborescentes à partir d’expressions régulières définies sur des mots, ou d’autres structures arborescentes. La structure arborescente est ensuite convertie de manière à pouvoir être représentée à l’aide d’un attribut multidimensionnel par mot, comme illustré par la figure 3.2.

1 Introduction |