La distribution zipfienne des formes de paradigme

Les locuteurs d’une langue ne sont jamais exposés à l’ensemble des formes des lexèmes qu’ils connaissent. Dans cette section, nous discutons de quelques travaux qui ont établi l’existence de cette propriété distributionnelle des formes fléchies qui donne lieu au PCFP.

Nous présentons dans le tableau 3.1 quelques mesures proposées par Chan (2008, chap. 4). Chan définit la paradigmatique d’un corpus pour une catégorie morphosyntaxique donnée comme la proportion du paradigme réalisée en corpus pour le lexème qui maximise cette proportion. Cette mesure offre une borne haute du remplissage des paradigmes en corpus.

Le tableau 3.1 établit clairement que dans les langues ayant un paradigme de taille conséquente, aucun lexème n’est attesté dans toutes ses formes. Chan (2008) avance qu’en effet, les données morphologiques sont doublement éparses. D’une part les lexèmes ont une distribution qui suit la loi de Zipf, selon laquelle la fréquence d’un mot en corpus est inversement proportionelle à son rang, si bien que peu de lexèmes sont très fréquents, et de nombreux lexèmes sont très peu fréquents. D’autre part, la distribution des formes de chaque lexème est également déséquilibrée, avec quelques cases beaucoup plus fréquentes que d’autres.

Cette étude n’établit pas cependant la réalité du PCFP. Premièrement, les corpus de 0.6 à 2.8 millions de tokens sont plutôt petits. Une estimation récente de Gilkerson et Richards (2009) fondée sur des enregistrements montre que les enfants américains de moins de 4 ans entendent en moyenne environ 6000 (10e centile) à 20000 (90e centile) tokens par jour prononcés par des adultes. En conséquence, même les enfants les moins exposés auront entendu autour de 9 millions de tokens à quatre ans, ce qui est bien supérieur aux corpus de Chan (2008). L’expérience du système flexionnel d’un locuteur adulte est donc bien plus étendue que les corpus examinés par Chan (2008), et il est possible que la saturation soit plus élevée à de plus grandes tailles de corpus. Deuxièmement, la saturation mesure un maximum qui concerne uniquement le lexème le plus fréquent, et ne nous renseigne pas nécessairement sur la tendance majoritaire. Enfin, il ne suffit pas de montrer que les locuteurs ont une connaissance partielle des paradigmes pour justifier l’importance du PCFP : dans de nombreuses langues, il existe des cases de paradigme utilisées si rarement que leur prédiction n’est pas un problème fréquent pour les locuteurs.

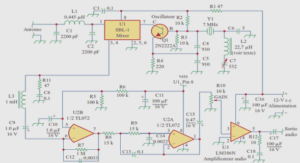

Afin d’établir la réalité du PCFP, nous avons observé la distribution des formes fléchies dans le corpus FrWaC (Baroni et al. 2009), un corpus web de 1.6 milliards de tokens, ce qui est supérieur à l’exposition cumulée d’un locuteur adulte 2 . Le corpus comprend énormément de bruit (erreurs de segmentation, erreurs d’étiquetage), nous restreignons donc notre attention aux verbes documentés dans le lexique Lefff (Sagot 2010). En conséquence, nous ne pouvons rendre compte des néologismes récents. La figure 3.1 montre l’évolution du nombre moyen de forme par lexème tandis que l’on progresse dans le corpus. Comme il n’existe pas d’étiqueteur morphosyntaxique du français capable de discriminer les formes orthographiques syncrétiques avec une exactitude satisfaisante, nous comptons les formes orthographiques distinctes, et non directement les cases de paradigme. Les verbes du français présentent 51 cases de paradigme, mais les syncrétismes ramènent cette valeur à environ 36 formes distinctes par verbe en moyenne documentés dans le lexique Lefff.

Deux observations se dégagent de la figure 3.1 : d’une part, tandis que la taille du corpus croît, le nombre de formes par lexème en moyenne croît également. En conséquence, un locuteur est continuellement amené à rencontrer des nouvelles formes. D’autre part, même face à de très grands corpus, le nombre de formes par lexème qui sont attestées en corpus reste nettement inférieur au nombre de formes existantes. En français, il existe 12 cases de paradigme qui sont presque entièrement sorties de l’usage (le passé simple de l’indicatif et le subjonctif passé). En les excluant, on trouve toujours au maximum environ 18 formes par lexème sur les 24 formes utiles aux locuteurs.

La structure implicative des paradigmes

Wurzel (1989) avance que les paradigmes flexionnels présentent ce qu’il nomme structure implicative :

Les paradigmes flexionnels sont, à proprement parler, maintenus ensemble par des implications. Il n’y a pas de paradigmes (si ce n’est des cas de supplétion extrêmes) qui ne soient pas fondés sur des implications valides au-delà d’un mot unique, si bien que nous pouvons dire à juste titre que les paradigmes flexionnels ont généralement une structure implicative, en ignorant les déviations de quelque cas particuliers 4 . Wurzel (1989, p. 114) On peut décrire ces implications sous la forme de déclarations conditionnelles dans lesquelles l’antécédent mentionne des caractéristiques phonologiques de cases de paradigme, et le conséquent mentionne des caractéristiques phonologiques d’une unique case de paradigme distincte. Nous donnons en (38) quelques exemples pour la conjugaison de l’anglais :

Entropie des paradigmes

Ackerman, Blevins et Malouf (2009) et Ackerman et Malouf (2013) proposent une mesure informationnelle pour quantifier, au sein des paradigmes entiers, la certitude avec laquelle il est possible de prédire une forme fléchie à partir d’une autre forme fléchie. Nous illustrons la façon dont ils calculent l’entropie paradigmatique sur un petit paradigme partiel des noms russes présenté dans le tableau 3.2. Les exemples sont choisis comme représentatifs de trois classes flexionnelles majeures du russe, ainsi que de la classe des indéclinables.

Limitations et améliorations

Le modèle de Ackerman, Blevins et Malouf (2009) et Ackerman et Malouf (2013) présente des limitations qui tiennent principalement au fait qu’il s’appuie sur des grammaires descriptives pour calculer l’entropie paradigmatique d’un système. Or ces grammaires fournissent généralement des descriptions simplifiées, dans lesquelles certaines opacités ainsi que certains patrons rares sont omis, ce qui mène à sous-estimer la difficulté du PCFP. Par ailleurs, l’absence d’information de fréquence sur chaque classe est également problématique. Ackerman et Malouf (2013) sont conscients de ces limitations : nos calculs d’entropie sont fondés sur des descriptions de systèmes flexionnels tirés de grammaires écrites. Ces descriptions omettent souvent des détails cruciaux, et, de façon plus importante pour déterminer les véritables complexités intégratives des systèmes flexionnels, elles ne reflètent pas les fréquences de type ou de token 5. [En anglais dans le texte] « inflectional paradigms appear to be organized in such a way that their average conditional entropies are relatively low ». associées avec les classes flexionnelles. 6 Ackerman et Malouf (2013, p. 17) De plus, Bonami (2014) et Bonami et Boyé (2014) montrent que les segmentations de ces grammaires sont informées par l’ensemble du système, et intègrent des informations qui ne sont pas disponibles aux locuteurs lorsqu’ils doivent résoudre le PCFP. Nous présentons dans le tableau 3.4 un petit sous-paradigme des verbes du français. Dans l’analyse affixale du français, les formes infinitives /finiʁ/ et /diʁ/ prennent un affixe /-ʁ/, tandis que /vəniʁ/ prend un affixe /-iʁ/. Cette segmentation est choisie précisément parce qu’elle permet de réduire l’incertitude dans les paradigmes.

Entropie implicative

Bonami et Boyé (2014) ont proposé un amendement à la méthodologie de Ackerman, Blevins et Malouf (2009) et Ackerman et Malouf (2013) permettant de mesurer l’entropie moyenne au sein des paradigmes en se fondant sur des patrons d’alternance plutôt que sur des descriptions affixales. Nous présentons ici leur méthodologie sur l’exemple du russe introduit dans le tableau 3.2, et en nous fondant sur la formulation améliorée de Bonami et Beniamine (2016). Tout d’abord, pour toute paire de cases de paradigme (A, B), définissons une variable aléatoire « A ⇌ B » qui classe chaque lexème selon le patron d’alternance qu’il instancie pour ces cases. Rappelons que puisque les patrons sont bidirectionnels, « A ⇌ B » et « B ⇌ A »

sont strictement équivalents. Étant donnée une forme de paradigme de la case A, seul un sousensemble des patrons de « A ⇌ B » lui est applicable. Nous rappelons ci-dessous la définition d’un patron à une forme (chapitre 2) :

Implications unaires : résultats empiriques

Nous appliquons la méthodologie décrite ci-dessus à l’ensemble des systèmes étudiés dans cette thèse, de façon à déterminer l’entropie implicative pour prédire chaque case de paradigme à partir de chacune des autres cases.

Le tableau 3.7 présente les entropies implicatives unaires au sein des paradigmes étudiés.

Les valeurs obtenues confirment la conjecture d’entropie faible. Sagot (2013) remarque que cette mesure tend à être plus haute dans les petits paradigmes, ce qu’il considère comme contreintuitif. Cette tendance se confirme dans nos données (la valeur la plus haute étant celle du chatino de Zenzontepec). Quoique peu intuitive, nous pensons qu’il s’agit bien d’une propriété du PCFP dans les petits systèmes. Il est possible que dans ces systèmes, le PCFP se pose plus rarement, soit que les paradigmes soient mieux remplis en moyenne 7 , soit que les locuteurs puissent en mémoriser une plus grande proportion. Il n’en est pas moins qu’en moyenne, lorsqu’il se pose, le PCFP peut être plus difficile que dans des paradigmes qui présentent de nom7. Cependant, ce n’est pas ce que trouvent Blevins, Milin et Ramscar (2017) pour l’allemand. breuses occasions de syncrétismes ou d’interprédictibilité 8.

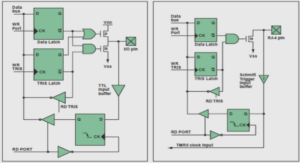

Zones d’interprédictibilité

Bonami (2014) s’appuie sur les entropies implicatives unaires afin de calculer des zones d’interprédictibilité totales entre cases de paradigme : il s’agit d’une partition des cases du paradigmes en zones. Une zone est un sous-ensemble de cases au sein de laquelle chaque paire de cases a une entropie implicative de 0 dans les deux sens. La figure 3.3 présente les zones que nous obtenons pour les verbes du français. Dans cette figure, chaque zone est identifiée par un entier et une couleur. Par exemple, la zone 7, en vert clair, réunit l’ensemble des personnes du conditionnel et du futur.

En français, nous trouvons quatorze zones, soient deux de moins que Bonami (2014). En effet, l’algorithme de Bonami (2014) inère des patrons ayant des contextes phonologiques d’application légèrement différents, ce qui a des conséquences sur la prédictibilité absolue. Les verbes , quoique formés similairement, dièrent par leur seconde personne pluriel de présent (et d’impératif qui lui est syncrétique), respectivemnt /dit/, /ʁədit/ et /dedize/. Bonami (2014) obtient des patrons Xzɔ̃⇌ Xt et Xɔ̃⇌ Xe concurrents, impossibles à départager. De même, il existe des verbes comme qui suivent le patron Xɔ̃⇌ Xe (/pøzɔ̃/, /pøze/), tandis que suit un patron Xøzɔ̃⇌ Xɛt (/føzɔ̃/, /fɛt/). Ces deux patrons sont à nouveau applicables aux deux verbes. Pour Bonami (2014), ces patrons sont également impossibles à prédire avec une certitude entière. Notre algorithme produit cependant des patrons dont le contexte est plus précis, présentés dans les exemples 41, 42 et 43).