Normalisation des tokens inconnus altérés

Système proposé

La majorité des altérations que nous voulons normaliser ici proviennent d’opérations simples. Elles sont dues à de la proximité clavier (ex. : znalise) ou phonétique (ex. : analize), à de la duplication de lettres (ex. : anallyse) ou encore à un mécanisme de réduction volontaire trop irrégulier pour avoir été stocké dans un lexique de substitution (ex. : pvoir). Comme expliqué précédemment, nous faisons ici l’hypothèse que la majorité des procédés d’altération correspondent à l’application d’au plus une opération lourde 3 qui peut éventuellement avoir été associée à des opérations légères d’accentuation.

Ces différents mécanismes d’altération partagent ainsi une certaine régularité. L’analogie peut nous permettre d’apprendre cette régularité. Par exemple, si nous avons déjà vu au préalable et extrait à l’aide d’une généralisation appropriée la règle de correction permettant de passer de engagemt à engagement, nous devrions être capable de prédire l’orthographe correcte de changemt (cf Figure 5.1).

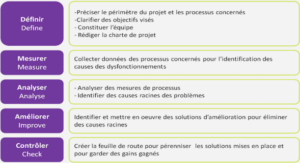

Le système proposé ici ainsi a pour objectif de normaliser chaque token inconnu du Lefff que nous considérons comme potentiellement altéré, dans la mesure où ce dernier n’a pas été traité ou identifié comme un emprunt non adapté ou un néologisme par les systèmes décrits précédemment (cf. chapitre 4). Pour ce faire, il suggère des candidats de normalisation pondérés à l’aide de règles de correction apprises sur un corpus d’erreurs lexicales annoté. Dans un premier temps, nous montrerons comment nous avons extrait automatiquement ces règles de correction (section 5.2.1), puis nous expliquerons comment nous combinons ces règles entre elles (section 5.2.2).

Enfin, nous verrons comment pondérer les candidats de normalisation proposés par notre système afin de ne conserver que le ou les candidats les plus probables (section 5.2.3). Ce travail permettra ainsi la création d’un nouveau module proposant plusieurs candidats de normalisation pour une altération donnée. Un système de filtrage permettant de conserver que les candidats les plus pertinents sera ensuite proposé dans le chapitre 6.

Apprentissage des règles de correction

L’apprentissage de nos règles de correction s’appuie sur un corpus de fautes lexicales annotées, le corpus WiCoPaCo (Max et Wisniewski, 2010) sur lequel nous reviendrons à la section 5.3.1. Nous verrons notamment comment nous en avons extrait un ensemble de couples de tokens (token altéré, token bien orthographié) correspondant à des fautes lexicales.

Un tel ensemble constitue l’entrée de notre système, et nous cherchons à en extraire automatiquement des règles pondérées de correction. Comme indiqué précédemment, nous faisons l’hypothèse que chaque altération est le résultat d’au plus une erreur « lourde ». Ainsi, pour concevoir nos règles de correction, il nous suffit d’extraire automatiquement de chaque couple de tokens les informations suivantes : le contexte gauche complet précédant une altération, l’altération et sa correction, le contexte droit complet suivant l’altération.

Précisons qu’afin de prendre en compte les 5.2. Système proposé 123 débuts et fins de tokens au sein du contexte, ces derniers seront marqués par les symboles ##. Ainsi les tokens exempel::exemple, par exemple, seront ici notés ##exempel##::##exemple##. L’altération ayant lieu en fin de token, son contexte droit pourra tout de même être pris en compte.

Les contextes gauche et droit étant identiques dans le token altéré et dans sa forme bien orthographiée, il est simple d’extraire les séquences de lettres constituant une chaîne de caractères altérée et représentant la correction de cette dernière. Pour le couple par exemple, l’alignement se fera comme suit : alignement nous permet d’extraire de cette paire de tokens les informations suivantes :

• la zone altérée et sa contrepartie corrigée, c’est-à-dire la chaîne de caractères concernée par la correction avant et après sa modification. Ce sont ces deux chaînes qui sont utilisées pour passer d’un token à un autre. Dans notre exemple, il s’agira de « ev → ve » ; • le contexte dans lequel s’applique cette substitution. Dans notre exemple, on obtiendra pour contexte gauche « sou » et pour contexte droit « nt ».