Formation neuroscience du consommateur, tutoriel & guide de travaux pratiques en pdf.

APPROCHE TAXONOMIQUE DU NEUROMARKETING

Définition

Le terme « neuromarketing » dans son sens étroit suppose habituellement l’utilisation systématique de techniques de neuro-imagerie pour identifier les substrats neuraux, associés à divers phénomènes psychologiques (pensées, cognitions, émotions et sentiments) que l’on pose dans ce paradigme comme exclusivement biologiques4. Nous pensons que le paradigme neuroscientifique peut être également une grille de lecture permettant d’étudier et de comprendre des comportements directement observables et/ou interprétables (comportements, tant langagiers que moteurs). Une définition du neuromarketing reposant uniquement sur l’idée d’une utilisation de ces techniques nous paraît trop réductrice. Nous proposons donc la définition suivante :

« Le neuromarketing (ou neuroscience du consommateur5) est l’étude des processus mentaux (explicites et implicites) et des comportements du consommateur – dans divers contextes marketing concernant aussi bien des activités d’évaluation, de prise de décision, de mémorisation ou de consommation – qui se fonde sur les paradigmes et les connaissances des neurosciences ». (Droulers & Roullet (2007)

Dans ce contexte élargi, d’autres techniques – psychophysiques ou comportementales – sont applicables dès lors qu’un corpus neuroscientifique sous-tend les hypothèses théoriques. Ainsi, les instruments permettant de mesurer les principales fonctions physiologiques (respiration, conductance électrodermale, pouls ou pression artérielle), la dilatation des pupilles, les déplacements du point de fixation oculaire (eye-tracking), ou les variations de micro-expressions faciales, pourraient prétendre à « l’arsenal » neuromarketing. Une revue des techniques neuroscientifiques applicables en marketing est synthétisée dans l’Annexe 1.

Cette focalisation du marketing (et de la RCC) sur l’individu consommateur dans toutes ses composantes cognitives et affectives est consubstantielle à la discipline : depuis le début du vingtième siècle, le marketing s’est toujours approprié les cadres théoriques de la psychologie (successivement behaviorisme, analyse motivationnelle et psychanalyse, gestalt, cognitivisme etc.). Il apparaît ainsi logique, voire légitime de voir aujourd’hui notre discipline faire sienne les paradigmes des neurosciences.

Cette prise en compte de la psyché du consommateur dans les processus de décision et d’achat s’est manifestée plus tardivement en économie. L’économie comportementale (behavioral economics) s’attache désormais autant à la psychologie individuelle (incluant l’affect) qu’aux agrégats ou aux agents rationnels. Certains économistes ont même entrepris « d’ouvrir la boite noire », en recourant à ces mêmes techniques de neuro-imagerie (McCabe, 2003). On évoque ainsi le champ émergent de « neuroéconomie » qui, de concert avec le neuromarketing, participe à l’élaboration des nouvelles (neuro)sciences de la décision (Shiv et alii, 2005). On peut cependant s’interroger sur le fait de savoir si les deux termes sont synonymes – ou s’il existe à la fois des différences et des zones de recouvrement entre ces deux disciplines « cousines ».

Neuromarketing et neuroéconomie

Devançant les gestionnaires de quelques années, les économistes ont été les premiers à avancer le terme de « neuroéconomie », dont la raison d’être était de mieux comprendre, à la suite des travaux de Kahneman et Tversky, les processus de décision des agents économiques à l’aide des approches de la psychologie cognitive et des neurosciences. D’emblée, les économistes se sont appropriés les approches neuroscientifiques portant sur des comportements individuels de préférence ou d’achat, peut-être parce qu’ils avaient ignoré la psychologie générale ou cognitive durant un siècle, contrairement au marketing qui s’en est toujours explicitement inspiré (Bartels, 1976). Avec le zèle des disciples fraîchement convertis, les économistes comportementaux exhortent désormais les mercaticiens à s’inspirer des modèles de l’économie comportementale qui intègrent des dimensions psychologiques non rationnelles (Johnson, 20066 ; Ho, Lim & Camerer, 2006). La pratique académique de la neuroéconomie ou du neuromarketing est encore clairsemée et sporadique : « dans le monde entier, à peine une cinquantaine de groupes de recherche revendique explicitement le terme de neuroéconomie » (Kenning & Plassman, 2005). Si l’on s’efforçait à vouloir trouver des différences entre les deux disciplines émergentes qui partagent de larges zones de recouvrement, on pourrait dire que la neuroéconomie s’attache davantage à la base théorique des comportements économiques et sociaux et à leurs substrats neuronaux (concept d’utilité attendue par exemple ; Berns, Capra & Noussair, 2007), pouvant expliquer des choix et des prises de décision sous contrainte (Hüsing, Jäncke & Tag, 2006 ; 152), tandis que le neuromarketing aborde des problématiques plus réalistes dans des contextes se voulant plus écologiquement valides.

CONDITIONS PREALABLES A LA REALISATION D’UNE ETUDE NEUROMARKETING

Il est évident qu’après avoir envisagé le bien-fondé d’une étude de neuro-imagerie dans un contexte marketing (d’autres techniques plus accessibles sont parfois plus pertinentes au préalable), des contraintes matérielles, financières, juridiques et éthiques passent au premier rang et doivent être considérées. Afin d’illustrer nos propos et de les ancrer dans des problématiques pertinentes pour le marketing, nous nous appuierons sur quelques études neuromarketing récentes parmi la vingtaine recensée (Lee, Broderick & Chamberlain, 2007).

Accès aux matériels d’imagerie en France

En avril 2004, le quotidien Les Echos déplorait le retard considérable de la France en matière d’équipement en scanners IRM et TEP. Des statistiques publiées par l’OCDE en 2007 et reprises par la Direction Générale « Santé et Protection des Consommateurs » de l’Union Européenne, indiquaient que la France disposait en 2005 de 4,7 IRM par million d’habitants contre 7,1 en Allemagne, 11 en Hollande, 15 en Italie, 27 aux USA et 40,1 au Japon. Une étude d’évaluation indique en outre que seul un quart des scanners IRM en Europe sont configurés pour de l’imagerie fonctionnelle (Hüsing, Jäncke & Tag, 2006). Naturellement, la totalité des appareils français est située en milieu hospitalier et leur fonctionnement est prioritairement affecté aux explorations cliniques ou à la recherche médicale stricte. Il n’existe pas de scanner « privé » dédié à la recherche appliquée, comme il en existe aux USA. Si l’on répartit par pays les 23 études de neuromarketing publiées à ce jour, on constate qu’aucune n’est française mais que 8 sont américaines, 7 allemandes et 5 britanniques. Ce sont les pays qui disposent le plus d’équipements d’IRM qui sont à même de produire le plus de travaux en neuroscience du consommateur. Sans évoquer d’emblée les interrogations éthiques éventuelles qui s’y rattachent, on peut déplorer le retard considérable que la recherche française est susceptible de prendre rapidement. Il convient d’espérer, qu’à l’instar de nos voisins allemands, britanniques ou hollandais, des partenariats puissent se nouer entre chercheurs neuroscientifiques et mercaticiens.

Coûts associés aux techniques d’imagerie

Il n’est pas surprenant de rappeler que l’accès à des technologies de pointe est onéreux et que le chercheur en neuroscience du consommateur doit budgéter de manière significative sa phase terrain. Les coûts associés à l’utilisation de ces techniques sont variables car liés à l’utilisation de matériels plus ou moins sophistiqués et de personnels compétents plus ou moins nombreux. Par exemple, une étude d’EEG ne nécessite qu’un biotechnicien pour la pose des électrodes, la présentation des stimuli et l’enregistrement des données pouvant être gérés par l’expérimentateur. En revanche, une expérimentation d’IRM fonctionnelle implique la présence à chaque session d’imagerie, d’un médecin, d’un préparateur, voire d’un physicien en charge des réglages de l’aimant. Des grandeurs de coûts sont indiquées dans le Tableau 1. Il convient d’y ajouter les frais de personnel, dans l’hypothèse d’une expérimentation dont la finalité n’est pas la recherche pure mais une démarche à visée commerciale ou publicitaire. Ainsi, dans un contexte purement commercial, le coût par sujet avoisinerait 800 €, sachant qu’une étude type requiert la participation de 15 à 25 personnes pour une durée moyenne de 45 à 60 minutes au total (Yoon et alii, 2006).

*** Insérer ici le Tableau 1 ***

Naturellement, les honoraires facturés par les cabinets spécialisés sont plus élevés. Selon le témoignage de l’un de ces cabinets, une étude portant sur 30 sujets peut atteindre 250.000 dollars US (Wells, 2003 ; 66). Dans un contexte plus hexagonal, le chercheur en neuroscience du consommateur devra soit rechercher une association avec une équipe de recherche médicale, soit rechercher un financement auprès d’investisseurs privés, afin d’opérer de manière autonome.

Conditions juridiques et éthiques liées à l’utilisation des techniques

Selon l©avis du Comité Consultatif National d©Ethique pour les sciences de la vie et de la santé (CCNE), la recherche biomédicale sur des sujets humains fut pratiquée de façon furtive, le plus souvent même, à l©insu des personnes concernées lorsqu©il s©agissait de malades, jusqu©à la loi Huriet-Sérusclat de 1988 qui « fit sortir la recherche de la clandestinité ». Cette loi du 20 décembre 1988, abondée par la loi n° 2004-800 du 6 août 2004 relative à la bioéthique, impose certaines procédures, dès lors qu’un sujet volontaire est soumis à des instrumentations biomédicales. Par exemple, les promoteurs d’une expérimentation financée par un établissement public doivent s’assurer au préalable de l’aval d’un comité d’éthique (un comité de protection des personnes [CPP]7 délivre une autorisation explicite d’expérimentation), du consentement libre et éclairé de chaque sujet et de la supervision des procédures par un médecin.

Le point le plus délicat de la loi – et qui est le plus susceptible de donner lieu à des contestations juridiques – concerne la notion de consentement libre et éclairé. Le consentement éclairé consiste à recueillir l’acceptation du sujet à participer à l’expérimentation après qu’il en ait été informé et qu’il ait compris la procédure expérimentale, incluant les avantages et les inconvénients d’un tel type d’examen. L’information donnée aux volontaires doit être « loyale, claire et appropriée » (code de déontologie médicale, Art. 35), ainsi que « simple, accessible intelligible et loyale » (Charte du patient hospitalisé). L’investigateur leur fait connaître (1) l’objectif de la recherche, sa méthodologie et sa durée, (2) les bénéfices attendus, les contraintes et les risques prévisibles, (3) l©avis du Comité de protection des personnes (CPP). Cette démarche doit être actée par une formulation écrite et signée par le sujet volontaire (par exemple dans Plassman et alii, 2007 ou Deppe et alii, 2007).

En plus des contraintes purement légales ou réglementaires, le chercheur doit généralement obtenir au sein de son établissement de tutelle un agrément émanant du comité éthique local (Deppe et alii, 2007 ; Schaeffer & Rotte, 2006 ; Yoon et alii, 2006). Il est également souhaitable d’indiquer si les sujets volontaires ont été rémunérés. Knutson et alii (2007) citent une rémunération de 20 dollars de l’heure tandis que Yoon et alii (2006) indiquent un forfait global de 50 dollars par session.

LES OUTILS A DISPOSITION DU CHERCHEUR MARKETING

L’objectif de cette partie n’est pas de présenter de façon détaillée les techniques utilisées en neuro-imagerie, ce qui a déjà été fait de façon approfondie dans divers ouvrages (par exemple Cabeza & Kingstone, 2006) ou condensée dans des revues récentes (Amaro & Barker, 2006). Une présentation synthétique est cependant utile afin de bien comprendre l’intérêt croissant, mais aussi appréhender les nombreuses questions voire les peurs, suscités par l’utilisation des ces techniques.

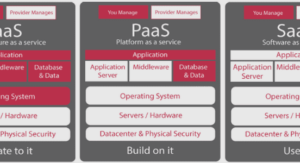

Deux groupes de méthodes co-existent. Les premières reposent sur une mesure directe de l’activité cérébrale, les secondes sur une mesure indirecte de cette activité.

• Les mesures indirectes de l©activité cérébrale

Nous ne ferons que citer pour mémoire la tomographie par émission de positons (TEP) qui requiert l’injection de traceurs radioactifs au sujet testé. L’imagerie fonctionnelle par résonance magnétique (IRMf) qui ne nécessite pas l’utilisation de tels traceurs, permet la répétition des observations chez un même individu. Elle repose sur une différence de signature magnétique de l©hémoglobine selon que cette dernière est saturée ou non d©oxygène. La méthode la plus employée vise à détecter les variations de concentration locale en désoxyhémoglobine (méthode BOLD ; Blood Oxygen-Level Dependant) afin d©observer et d’enregistrer les variations de consommation d©oxygène et donc les variations de débit sanguin cérébral dans les diverses zones cérébrales. La résolution temporelle de cette méthode est faible8 (environ 4 à 6 secondes) mais la résolution spatiale est relativement satisfaisante (quelques millimètres) pour les scanners courants (1,5 teslas), voire exceptionnelle (100 microns) pour les scanners à champ intense (7 teslas et plus). Cependant, certaines régions cérébrales sont plus difficilement visualisées, en particulier le cortex orbitofrontal et le cortex temporal inférieur, du fait de la présence de cavités (sinus nasal, conduit auditif).

Nous pouvons également citer la technique récente (Hoshi, Chen & Tamura, 2001), plus frustre mais plus accessible, de l’imagerie en proche infrarouge (NIR imaging). Elle consiste à émettre des rayonnements infrarouges dans un casque au travers de la voûte crânienne. Le rayonnement électromagnétique, peu énergétique, ne pénètre le cerveau que sur quelques millimètres ; les photons incidents sont différentiellement réfléchis par l’oxyhémoglobine et la désoxyhémoglobine du sang et permettent donc de localiser des régions cérébrales activées. Une société japonaise propose désormais une version portable de son système comportant un bandeau de 400g et un boîtier enregistreur à la ceinture de 630g (Tabuchi, 2007). Le logiciel associé peut gérer simultanément jusqu’à 24 sujets porteurs (application potentielle en focus groupes). Ses principaux défauts sont la faible résolution spatiale (2 cm, soit plus de 10 fois la limite actuelle des IRMf) et l’impossibilité de scruter les zones subcorticales profondes. Néanmoins, pour des études d’activation dans des régions d’intérêt préétablies (pariétal et familiarité, préfrontal et décisions, par exemple), la technique peut s’avérer très efficace et d’un bon rapport efficacité / prix.

• Les mesures directes de l©activité cérébrale

La plus ancienne méthode d’étude de l’activité cérébrale : l’électroencéphalographie (EEG) (Berger, 1929), vise à mesurer les variations de champ électrique présentes au niveau du scalp. Le développement de l’informatique a conduit à une amélioration de cette méthode en permettant de traiter les données issues d’un nombre beaucoup plus grand de capteurs (124 voire 264 capteurs sur un seul scalp). On parle alors de cartographie EEG et de potentiels évoqués. Cette méthode possède une excellente résolution temporelle (0,5 à 1 milliseconde) mais une très mauvaise précision spatiale (quelques millimètres à plusieurs centimètres). Par ailleurs, les régions les plus profondes du cerveau (noyaux gris centraux, amygdales, thalamus) ainsi que le cervelet, ne peuvent être étudiés pleinement avec les techniques électromagnétiques. Une seconde méthode, la magnétoencéphalographie (MEG) détecte les minuscules champs magnétiques générés par l’activité électrique des neurones synchronisés. Cette technique permet de suivre des processus cérébraux milliseconde par milliseconde, mais avec une résolution spatiale moyenne, de l’ordre de plusieurs millimètres. Ces techniques ne sont pas mutuellement exclusives et leur conjugaison permet de gagner des points de résolution appréciables (EEG + IRMf ou MEG + EEG, par exemple). Une synthèse des avantages et inconvénients de ces méthodes est portée dans le Tableau 2.

*** Insérer ici le Tableau 2 ***

• Limites et réserves quant aux techniques de neuro-imagerie

L’utilisation de ces techniques impose en outre quelques contraintes au sujet testé. Lors de l’utilisation de la l©IRMf et de la MEG, le sujet ne doit absolument pas bouger la tête qui est souvent bloquée à l’aide de divers dispositifs. Par exemple, Knutson et alii (2007), dans leur étude relative aux décisions d’achat liées au niveau de prix, ont été contraints d’écarter 8 sujets de l’échantillon final « du fait de mouvements excessifs de la tête » (plus de 2 mm de variation). Plus encore, lors de l’utilisation de l’IRMf, le patient est étendu dans un tunnel très étroit et doit porter des bouchons acoustiques afin de diminuer le bruit généré par l’appareil en action. Ces désagréments sont néanmoins à nuancer au vu de certaines analyses qualitatives menées auprès de sujets volontaires (Senior et alii, 2007). Au regard de ces précédentes techniques, l’EEG paraît être une technique particulièrement souple, totalement indolore, non stressante, permettant au sujet de bouger. Des constructeurs ont ainsi récemment proposé des appareils permettant au sujet une grande liberté de mouvements ; il peut par exemple déambuler dans une grande surface commerciale (Mucha, 2005 ; Neuroco, 20079). Enfin, les techniques de neuro-imagerie exigent pour des raisons de non perturbation du champ magnétique, l’utilisation des matériels périphériques (présentation de stimuli visuels ou acoustiques, enregistrement de réponses comportementales etc.) à fibre optique qui ne génèrent pas de champ magnétique parasite.

D’ores et déjà, certaines améliorations voire innovations sont susceptibles de lever plusieurs limites abordées ici. Pour illustration, qu’il suffise de citer l’imagerie en infrarouge proche évoquée supra, la tractographie (IRM de diffusion; Le Bihan, 2007) qui permet d’observer les connexions structurales et fonctionnelles entre modules cérébraux, ou encore la stimulation magnétique transcranienne (TMS) qui permet une neuropsychologie clinique (étude de lésions et de déficits associés) ponctuelle et réversible. Le progrès neuroscientifique passe également par l’emploi de nouvelles techniques de traitement de l’information recueillie par l’imagerie : l’analyse en composantes indépendantes (ICA), les analyses discriminantes multiples (MDA) et l’analyse des schémas multivoxels (MVPA) viennent renforcer les analyses de variances et les modèles de régression linéaire, plus classiques.

Interrogations soulevées par ces techniques

La sécurité matérielle liée aux champs magnétiques intenses

La sécurité des individus participant aux expérimentations est cruciale. Alors que dans un contexte médical un risque peut parfois être accepté au regard du bénéfice apporté par l©obtention d©images dans un cadre diagnostique, l©utilisation de telles techniques dans le cadre marchand (marketing, économie) doit évidemment tendre vers une absence totale de risque.

Risques liés au champ magnétique statique

Réputée relativement sans danger, l’IRM a parfois provoqué des accidents graves voire des décès (Kulynych, 2002). En fait, il s’agit de la seule technique d’imagerie médicale qui ait conduit au décès subit de plusieurs patients. Trois types d©accidents sont recensés : (1) « l’effet missile » (objets ferromagnétiques brutalement attirés jusqu’à l’aimant où se tient le sujet), (2) les mouvements des objets métalliques intracorporels (stimulateur cardiaque, clip anévrysmal) et (3) les effets de couple (torsion d’un objet conducteur). Les articles neuromarketing les plus récents (Yoon et alii, 2006) citent nommément les facteurs d’exclusion principaux lors du recrutement des sujets (objets métalliques, grossesse, claustrophobie, dépendance aux drogues, certains médicaments etc.).