Quantification expérimentale des sensibilités

Contrairement aux mesures de DSC, très reproductibles, la plupart des protocoles expérimentaux reposent sur la réalisation d’un grand nombre de mesures à l’issue probabiliste. En effet, chaque échantillon est unique (microstructurellement parlant) et son comportement peut alors différer d’un autre. Ainsi, afin d’évaluer leur comportement « moyen », sont soumis à des contraintes de diverses intensités une multitude d’échantillons. La sensibilité est alors identifiée comme l’intensité de la contrainte entraînant une activité pyrotechnique (avec une probabilité de 50% dans la plupart des tests). L’activité pyrotechnique désigne alors une réaction de l’échantillon détectable par un opérateur (comme ce fut historiquement le cas) ou une série de capteurs composant le montage expérimental de l’échantillon. Cette réaction peut alors être sonore (explosion), chimique (traces de décomposition) ou visuelle (fumée, flash lumineux). Les issues de ces expériences étant probabilistes, les protocoles expérimentaux reposent sur une série de mesures portant sur un ensemble d’échantillons. Cet aspect ne semble pas limitant lors de l’étude d’espèces connues et dont les routes de synthèses sont bien étudiées. Or, lors de screening in sillico ou d’études de nouveaux composés pour lesquels une faible (de l’ordre du milligramme), voire aucune quantité de matière n’est disponible, ces protocoles ne sont pas applicables.

Protocoles expérimentaux des mesures

Dans l’ensemble des protocoles, chaque mesure est effectuée sur un unique échantillon. Chaque échantillon est calibré et possède ainsi une taille ou de masse fixée.

Après chaque mesure, l’échantillon est jeté, qu’il y ait eu activité pyrotechnique ou non. Comme mentionné dans l’introduction, l’ensemble de ces protocoles expérimentaux sont normalisés, permettant d’accroître la reproductibilité des mesures effectuées. Malgré l’existence de normes, il n’existe pas de méthodes permettant de définir un échantillon de référence : chacun d’entre-eux est unique. Ainsi, des matériaux supposés équivalents peuvent posséder une densité de défauts ou un arranQuantification expérimentale des sensibilités 6 segement cristallin différents. Ce point permet notamment de rendre compte de certaines disparités constatées lors d’inter-comparaison de mesures, effectuées en des lieux et conditions différents.

Sensibilité à l’onde de choc

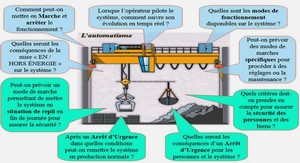

Si de nos jours, il existe une nette distinction entre les termes « impact » et « choc », ce n’était pas le cas à l’époque. Particulièrement, nous retrouvons des mentions de « sensibilité au choc » dès 1933 dans les notes d’artillerie de Muraour (FR) [16], afin de qualifier des impacts sur des munitions. Il faut attendre 1953 pour que Pape et Whitbread (UK) [17] puis Edwards et Rice (USA) [18] mettent au point les premiers montages expérimentaux permettant la mesure de la sensibilité au choc des matériaux énergétiques, en phase solide et liquide. A ce jour, les montages utilisés sont proches du SSGT (Small Scale Gap-Test ), qui est similaire à celui proposé par Cachia et Whitbread en 1958 [19]. La Figure 2.2 illustre les deux montages expérimentaux permettant de mesurer la sensibilité à l’onde de choc. Dans le cadre du dispositif SSGT, le montage comporte cinq niveaux. Un détonateur (1) initie le matériau dit « donneur » (2) qui lors de sa décomposition va permettre la formation d’une onde de choc. Celle-ci se propage jusqu’à une barrière (en laiton) d’épaisseur plus ou moins importante (3), qui va atténuer l’onde de choc incidente. Une fois atténuée, elle se propage dans le matériau dit « receveur » (4) dont on cherche à mesurer la sensibilité au choc. L’onde de choc atteint finalement le « bloc témoin » qui atteste de la réaction (« go » ou « no go ») du receveur (5). La variabilité de l’épaisseur de la barrière entre le donneur et le receveur permet de moduler l’intensité de l’onde de choc incidente.

Sensibilité à la friction

Enfin, le tableau des mesures des sensibilités mécaniques ne serait pas complet sans évoquer la sensibilité à la friction. Le développement de montages expérimentaux commence autour de l’année 1955 avec le lancement du montage BAM et en 1960, le montage ABL (Allegany Ballistics Laboratory ) voit le jour [20]. La Figure 2.3 illustre le fonctionnement des différents dispositifs permettant de mesurer la sensibilité à la friction. Pour le montage ABL, une roue en acier d’épaisseur 2.4 cm glisse sur un échantillon d’une masse comprise entre 35 et 45 mg disposé sur une plaque en acier.Une vriation de pression (en 13 étapes) allant de 0.31 MPa à 7.0 MPa entre la roue et la plaque est appliquée. La vitesse translationnelle de la plaque peut alors varier entre 31 cm/s et 244 cm/s et reste constante. Pour le montage BAM, un stylet en porcelaine est apposée sur un échantillon d’une masse comprise entre 35 et 45 mg, qui lui est disposé sur une plaque en porcelaine. Une variation de force allant de 6 N à 360 N entre le stylet et la plaque est appliquée, la vitesse de la plaque n’est pas modulable et ne reste pas constante (profil sinusoïdal). La Figure 2.3 schématise le fonctionnement de ces protocoles expérimentaux.

Sensibilité à la décharge électrostatique

En complément de la sensibilité thermique, qui caractérise l’échauffement critique suite à l’irradiation continue par un flux de photons, l’étude du comportement des matériaux énergétiques soumis à des flux d’électrons fut nécessaire afin d’éviter tous risques liés à la triboélectricité (électricité statique), phénomène extrêmement courant. Et pourtant, bien que l’existence de la triboélectricité fut constatée très tôt par Thalès, au Vème siècle avant notre ère, il fallut attendre les travaux de Coulomb et ses publications sur la force électrostatique de 1785 [33] pour comprendre ce phénomène. Le développement d’un grand nombre de machines électriques pendant la révolution industrielle conduisit à la nécessité du développement d’un réseau électrique de grande ampleur. Durant cette période, il fut découvert que les décharges électrostatiques pouvaient occasionner de sévères dégâts matériels et humains. Cependant, il fallut attendre la tragédie de Hindenburg en 1937 – où le dirigeable LZ 129 Hindenburg a pris feu puis s’est crashé suite à une décharge électrostatique – pour qu’il y ait une réelle prise de conscience des risques liés à la triboélectricité. En particulier, il fut constaté que certains composés, notamment des (nano-)thermites – qui sont des mélanges d’aluminium métallique et d’oxyde d’autres métaux – pouvaient réagir très violemment simplement avec l’application d’une tension équivalente à une énergie de quelques millijoules – inférieure à l’énergie produite lors d’une décharge par le corps humain (de l’ordre de 100mJ).

C’est durant les années 1940 que la Division des Explosifs du Bureau des Mines des États-Unis s’intéresse aux dangers associés à la décharge électrostatique et sa possible conséquence sur l’initiation des matériaux énergétiques. L’appareil de test ESD à aiguille mobile fut développé par Kirshenbaum et al. (Explosives Division of the U.S. Bureau of Mines) dans les années 1970 [34] puis amélioré par Larson et al. (Los Alamos National Laboratory ) dans les années 1980, permettant un meilleur confinement des échantillons notamment visqueux [35]. Enfin, l’appareil fut une nouvelle fois amélioré à la fin des années 1980 par Fisher (Sandia National Laboratories ) afin d’étudier le cas « critique » où la décharge proviendrait d’une personne suite à une accumulation de charge [36]. Expérimentalement, l’échantillon est placé dans un support fixé sur une électrode de base reliée à la terre. L’aiguille est alors placée juste au-dessus du support, à 0.02cm. L’énergie libérée lors de la décharge est déterminée à partir de la capacité du condensateur et de la tension. Lors de la procédure, l’aiguille vient percer l’échantillon puis libère l’énergie emmagasinée, le tout en moins de 15ms. La Figure 2.5 illustre le fonctionnement du protocole expérimental.

Grandeurs et phénomènes corrélés à la sensibilité

La modélisation des sensibilités des matériaux énergétiques débute dans les années 1980, notamment avec les travaux de Kamlet et al. (1979) qui présentent une corrélation entre la sensibilité à l’impact et la balance en oxygène [50]. La balance en oxygène, notée OB%, quantifie la proportion d’oxygène nécessaire à la conversion de l’ensemble du carbone en dioxyde de carbone et d’hydrogène en eau. Ainsi, cette grandeur est simplement calculée à partir du nombre d’atomes d’oxygène par rapport aux atomes de carbone et d’azote. Particulièrement, il est noté que la sensibilité à l’impact augmente à mesure que la balance d’oxygène augmente et que le degré de combustion et de performances sont directement liés à cette grandeur. Ainsi, il s’agit d’une première relation explicite entre les performances et la sensibilité des matériaux énergétiques.

Notion de sensibilité moléculaire (GIPF)

Contrairement à l’hypothèse d’une liaison « gâchette », d’autres descriptions proposent d’assimiler la sensibilité à un comportement moléculaire plus global. Dans ce but, des relations interactions-propriétés (GIPF) furent proposées. La sensibilité n’est alors plus décrite comme un phénomène « statique » mais dépend explicitement de phénomènes dynamiques.

Mullay (1987) proposa une relation explicite entre la sensibilité à l’impact et l’électronégativité moléculaire, notée M [59]. L’électronégativé moléculaire caractérise alors les pôles attracteurs et cédant des électrons. En particulier, il est noté que des zones dépourvues en électrons sont associées à l’existence de liaisons fragiles, susceptibles de se dissocier aisément. Particulièrement, la sensibilité à l’impact augmenterait avec l’accroissement de l’électronégativité moléculaire. Ceci peut être interprété comme un affaiblissement de certaines liaisons dont la dissociation permet la formation de radicaux.

Puis, les travaux de Kunz (1996) montrèrent que l’énergie moyenne de liaison pouvait être estimée à partir de la densité électronique [60]. Cette approche fut notamment appliquée au RDX possédant une énergie de 1.45 eV / atome et au TATB avec 2.48 eV / atome. Les calculs furent effectués dans la phase cristalline solide, avec des conditions périodiques aux limites. Implicitement, les interactions intermoléculaires ont été prises en compte. Particulièrement, une tendance entre l’énergie de liaison moyenne et l’insensibilité à l’onde de choc est notée. Or, les travaux menés par Kunz reposant sur la structure cristalline expérimentale, il était difficile d’effectuer cette étude systématiquement.

Par analogie avec la description de Mullay, Zhang et al. (2005, 2008), Murray et al. (2009) puis Stephen et al. (2010) présentent des corrélations entre les charges portées par les groupements NO 2 , notées QNO2 , et la sensibilité. En particulier, Zhang et al. remarquent qu’une accumulation d’électrons (charge négative) sur les groupements NO 2 renforce considérablement la liaison R¡NO2 et entraîne l’insensibilité de la molécule. De manière analogue, Murray et al. constatent que l’accumulation d’électrons par effet inductif sur certains groupements permet d’expliquer des zones anormalement positives de la surface du potentiel électrostatique. Ces zones positives étant associées à un défaut d’électrons et à une réactivité accrue, elles permettent d’étudier la sensibilité des molécules dont la décomposition ne dépend pas de la rupture d’une liaisons R¡NO2 . Enfin, les observations faîtes par Zhang et al. puis Murray et al. ont été confirmées par Stephen et al. Ces derniers ont étudié la répartition de la charge sur la molécule à partir de la densité électronique, puis ont abouti à une description de la déplétion des charges [63]. En particulier, la fragilité des liaisons était associée à une forte déplétion de charge, en accord avec les nombreux travaux précédents.

Une description multi-échelle de la sensibilité

Lorsque nous nous intéressons de plus près aux phénomènes mécaniques et physicochimiques sous-jacents, nous remarquons que quelle que soit la contrainte initiale appliquée à un échantillon, il existe systématiquement un grand nombre de mécanismes pouvant expliquer son initiation [81][82]. Des arguments d’ordre mécanique, thermodynamique, chimique ou cinétique peuvent alors être avancés et de nombreuses grandeurs se corrèlent à la sensibilité. Très tôt, de nombreuses tentatives expérimentales ont tenté d’apporter des réponses claires à ces interrogations. Cependant, malgré des efforts conséquents, des progrès sur les instruments de mesure et leur résolution [83], l’origine de la sensibilité des matériaux énergétiques reste assez controversée.

En effet, pour divers types de sollicitation, il existe généralement un temps d’induction significatif (1 s) entre l’application de la contrainte et la réponse chimique du matériau étudié. Ceci laisse penser que les mécanismes réactionnels entraînant la décomposition ne sont pas une conséquence directe de la contrainte, dont le rôle semble être réduit à un simple apport d’énergie thermique nécessaire à l’établissement d’un régime auto-entretenu de décomposition.

La décomposition du système semble être décrite comme une succession de trois grandes étapes : l’étape physique, l’étape chimique et l’étape propagation. Dans le cadre de l’étape physique, un ensemble de mécanismes mécano-physiques décrit des phénomènes dits « préréactifs ». Ceux-ci caractérisent une sollicitation de la structure du système, entraînant in fine la localisation de l’énergie. Cette localisation est principalement décrite par la formation de points chauds, zones intensément échauffées par des phénomènes de compression, de cisaillement, de frictions solides, de déformations plastiques et d’effondrements de cavités. Des mécanismes permettent ensuite de décrire le transfert de cette énergie à des modes moléculaires, entraînant des mécanismes réactionnels. L’étape chimique décrit justement l’initiation de ces mécanismes réactionnels jusqu’à la formation des produits finaux de décomposition.

Finalement, l’étape propagation décrit l’évolution des intermédiaires (radicaux) et des produits chauffés, les effets auto-catalytiques, l’accélération de la décomposition et l’établissement d’un régime auto-entretenu de décomposition conduisant à l’emballement thermique généralisé du système. La Figure 2.9 résume l’ensemble des étapes précédemment mentionnées.

Table des matières

Remerciements

Liste de notations

Liste de figures

Liste de tableaux

Introduction générale

Les matériaux énergétiques, une histoire de sensibilité

Introduction

Quantification expérimentale des sensibilités

2.2.1. Protocoles expérimentaux des mesures

2.2.1.1. Sensibilité à l’impact

2.2.1.2. Sensibilité à l’onde de choc

2.2.1.3. Sensibilité à la friction

2.2.1.4. Stabilité thermique

2.2.1.5. Sensibilité à la décharge électrostatique

2.2.2. Analyse statistique et reproductibilité des mesures

2.2.2.1. Analyse statistique des mesures

2.2.2.2. Reproductibilité des mesures expérimentales

Modélisation de la réponse des matériaux énergétiques

2.3.1. Approches de la littérature

2.3.2. Grandeurs et phénomènes corrélés à la sensibilité

2.3.2.1. Notion de liaison « gâchette » (trigger bond )

2.3.2.2. Notion de sensibilité moléculaire (GIPF)

2.3.2.3. Mécanismes décrivant la sensibilité

2.3.2.4. Réactivité et sensibilité

2.3.2.5. Bilan

2.3.3. Une description multi-échelle de la sensibilité

2.3.3.1. Modification de la structure électronique

2.3.3.2. Modification de la structure

2.3.3.3. Points chauds

2.3.3.4. Mécanismes de transfert

2.3.3.5. Cinétique et sensibilité

Conclusion

Vers une exploration efficace et automatisée de l’espace réactionnel

Introduction

Modèles de structure électronique

Génération des espèces intermédiaires

3.3.1. Première couche de sélectivité

3.3.2. Deuxième couche de sélectivité

3.3.3. Bilan

Raffinement du graphe réactionnel

3.4.1. Recherche des états de transition

3.4.2. Raffinement du graphe réactionnel

3.4.3. Bilan

Recherche des chemins de décomposition

Conclusion

Sensibilité à l’impact des matériaux énergétiques

Introduction

État de l’art

4.2.1. Synthèse des différentes approches

4.2.2. Relation initiale du modèle étudié

4.2.3. Déroulement du travail

Mécanismes cinétiques supplémentaires

4.3.1. Recherche des mécanismes

4.3.2. Formation de diazote et de cyanure d’hydrogène

4.3.3. Formation de carbonyle, de cyanide et de nitroso

4.3.4. Mod-5P : application des améliorations à Mod-7P

Élimination des paramètres superflus

4.4.1. Préfacteurs

4.4.2. Paramètre

4.4.3. Mod-2P : application des améliorations à Mod-5P

Résultats et discussions

Conclusion

Perspectives

4.7.1. Interprétations statistiques

4.7.2. Interprétations phénoménologiques

Modélisation de la décomposition d’un matériau énergétique

Introduction

État de l’art

5.2.1. Modélisation mathématique de l’emballement

5.2.2. Emballement thermique au sein d’un point chaud

5.2.3. Implication des défauts dans la formation de points chauds

5.2.4. Aspects cinétiques

5.2.5. Bilan

5.2.6. Perspectives pour d’autres travaux

Description stochastique de la dynamique de décomposition

5.3.1. Équation d’évolution d’un système modèle

5.3.2. Considérations statistiques

5.3.3. Établissement de la statistique de transformation

5.3.4. Statistique moyenne de transformation

5.3.5. Cinétique de décomposition

5.3.6. Description des transitions de phase

5.3.6.1. A partir de la cinétique de transition

5.3.6.2. A partir de la température de transition

5.3.7. Description de l’activation des défauts .

5.3.8. Équation d’évolution microscopique

Modélisation de l’emballement thermique

5.4.1. Considérations déterministes

5.4.2. Changement de régime

5.4.3. Régimes de contrainte

Identification des phénomènes prépondérants

5.5.1. Méthode numérique

5.5.2. Paramètres

5.5.3. Influence des transitions de phase

5.5.3.1. Stabilité numérique et distribution

5.5.3.2. Effet de la fusion sur la cinétique

5.5.3.3. Influence de la vaporisation sur la cinétique

5.5.3.4. Bilan de l’influence des transitions de phase

5.5.4. Influence de la cinétique

5.5.4.1. Influence des préfacteurs

5.5.4.2. Influence des énergies d’activation

5.5.5. Influence de la porosité sur la vitesse d’initiation

5.5.5.1. Influence de la proportion de porosité .

5.5.5.2. Influence de l’énergie de sublimation

5.5.5.3. Influence de la fréquence de sollicitation des pores

Discussion

Conclusion

Dérivation d’expressions analytiques des critères de sensibilité

Introduction

Solutions analytiques

6.2.1. Equation d’évolution simplifiée

6.2.2. Temps caractéristiques

6.2.3. Emballement thermique

6.2.4. Définition d’une température critique

6.2.4.1. Activation trop précoce des défauts

6.2.4.2. Activation optimale des défauts

6.2.4.3. Activation trop tardive des défauts

6.2.5. Définition d’une pression critique

6.2.6. Bilan

Expressions théoriques des critères de sensibilité

6.3.1. Sensibilité à l’impact

6.3.2. Sensibilité à l’onde de choc

6.3.3. Sensibilité à la friction

6.3.4. Sensibilité à la décharge électrostatique

Relations empiriques entre les sensibilités

Applications numériques

6.5.1. Données et protocoles expérimentaux

6.5.1.1. Données expérimentales

6.5.1.2. Protocoles expérimentaux

6.5.2. Prévision des sensibilités

6.5.2.1. Sensibilité à la chaleur

6.5.2.2. Sensibilité à l’onde de choc

6.5.2.3. Sensibilité à la friction

6.5.2.4. Sensibilité à la décharge électrostatique

6.5.2.5. Sensibilité à l’impact

6.5.2.6. Bilan

6.5.3. Score de sensibilité générique

Discussions

6.6.1. Influence de la microstructure

6.6.2. Influence de la cinétique

6.6.3. Influence des grandeurs

6.6.4. Bilan

Conclusion

Conclusion générale

Annexe A. Graphe réactionnel calculé du Nitrométhane

Bibliographie