Modèle probabiliste hérarchique de la locomotion bipède

Introduction

Les robots humanoïdes ont toujours fasciné, car leur potentiel d’application est considérable. En effet, si un robot avait les mêmes caractéristiques sensori-motrices et morphologiques qu’un homme, il pourrait théoriquement réaliser les mêmes tâches. Cet intérêt a donné lieu à de nombreux films et romans de science-fiction, imaginant un futur allant du monde parfait, à la catastrophe conduisant l’humanité à sa perte. L’attente du public est donc grande et beaucoup rêvent d’avoir enfin leur serviteur obéissant et motorisé. Mais bien que le marché de la robotique de service soit en pleine expansion, les humanoïdes peinent encore à sortir des laboratoires. Une des raisons qui empêche le développement de ces robots est la complexité de la marche bipède. La marche bipède est par nature instable, et demande d’avoir des mouvements très dynamiques pour garder l’équilibre. De plus, une chute peut être fort coûteuse puisqu’elle risque d’endommager, non seulement le robot lui-même, mais aussi son environnement et les personnes pouvant s’y trouver. Il est donc essentiel pour un robot humanoïde de maitriser son équilibre avant de pouvoir être mis en application. La marche humaine est quant à elle particulièrement robuste et versatile. En effet l’homme peut garder l’équilibre malgré d’importantes perturbations imprévues, et arrive à marcher dans une vaste gamme de conditions et contraintes. Reproduire ce niveau de performance en robotique est un objectif qui est aujourd’hui encore loin d’être achevé. La manière la plus simple de marcher pour un robot consiste à exécuter un contrôle cyclique. Une fois que les bons paramètres sont trouvés, le robot peut marcher en répétant systématiquement le même pas. Cette méthode est efficace quand l’environnement est bien connu et sans perturbation extérieure. De nouvelles méthodes de contrôle permettent d’adapter chaque pas à la situation actuelle du robot, pour réagir en cas de perturbation ou d’obstacle imprévu. Certains robots commencent même à sortir marcher en extérieur, comme l’ont montré de récentes vidéos impressionnantes du robot ATLAS de Boston Dynamics ou du robot MARLO de Michigan Robotics. Mais il est difficile de voir en vidéo la répétabilité des différentes démonstrations. La finale du DARPA Robotics Challenge en 2015 a permis d’observer l’avancée réelle de la marche humanoïde. Soumis à une exigence de stabilité, sans fils pour retenir une éventuelle chute, la plupart des robots ont choisi une marche lente et très peu 7 dynamique. Les autres ont opté pour un système hybride où le robot peut se mettre sur roues. Sur les quatre meilleurs équipes, trois avaient choisi ce type de locomotion hybride, plus stable et plus rapide que la marche sur terrain plat. Le risque de tomber est encore trop grand pour pouvoir appliquer une marche dynamique dans un cas pratique. Ce risque est la conséquence d’une accumulation d’incertitudes provenant de différentes sources : les retours des capteurs ont toujours un degré d’imprécision, les commandes ne sont jamais parfaitement exécutées par le robot, et le modèle du monde, servant à contrôler le robot, est une version simplifiée de la réalité. Dans cette thèse, nous allons développer un modèle probabiliste permettant d’intégrer ces incertitudes dans le contrôle de la marche.

Intégrer les incertitudes

La stratégie usuelle face aux incertitudes est d’essayer de les minimiser, en améliorant les capteurs, le robot ou le modèle par exemple, afin de pouvoir les ignorer sans que cela ne cause trop de problèmes. Mais en ignorant ces incertitudes, on perd la connaissance que l’on a sur celles-ci, qui aurait pu être utile pour améliorer notre contrôle. Prenons l’exemple d’un robot qui doit choisir la position de son prochain point d’appui. Il sait que la position exacte de son prochain point d’appui ne sera pas précisément celle qu’il a choisi. Sachant cela, il vaut mieux qu’il évite de choisir une position très proche d’un ravin, même si celle-ci l’amène plus vite vers son objectif global. Comme il sait que son mouvement a de l’incertitude, le robot prend la décision raisonnable d’être plus prudent et de marcher un peu plus loin du ravin. Dans un cas plus compliqué où le robot doit choisir entre passer proche d’un ravin, ou faire un long détour pour l’éviter, il est amené à se poser les questions suivantes : 1.Quel risque ai-je de tomber si je marche proche du ravin ? 2. Que me coûte le détour qui évite le ravin ? 3. Quelle est la meilleure décision à prendre ? L’idée est de définir mathématiquement ces questions à l’aide de distributions de probabilité, et d’y répondre en utilisant l’inférence bayésienne. En ignorant les incertitudes, on perd l’information qui nous permet de répondre à la première question, et il devient plus compliqué de faire le bon choix. 8 Dans le cas général, le modèle juge une action en regardant les conséquences possibles de cette action, pondérées par leurs probabilités. Le modèle peut finalement choisir l’action jugée la meilleure.

Objectif probabiliste

Un objectif probabiliste est en réalité une distribution de probabilité sur une variable. Cette distribution représente nos préférences sur les valeurs possibles que peut prendre cette variable. Considérons dans l’exemple précédent que l’objectif du robot est une distribution sur la direction de sa vitesse. La différence entre la probabilité associée à la direction qui passe proche du ravin et celle qui fait le détour permet de répondre à la question « Que me coûte le détour qui évite le ravin ? ». En réalité, calculer le coût du détour est plus compliqué que cela, car il faut d’abord pouvoir planifier le chemin qui permet au robot d’éviter le ravin. Dans ce travail, on suppose que la planification est faite par un modèle hiérarchique d’un niveau supérieur que l’on explique ci-après. Un autre avantage d’un objectif probabiliste par rapport à un objectif déterministe, est qu’il est facile à combiner avec un deuxième objectif. Il est en effet immédiat de fusionner deux distributions à l’aide d’une inférence bayésienne, alors qu’il peut être compliqué de trouver soi-même le compromis entre deux objectifs déterministes.

Hiérarchie

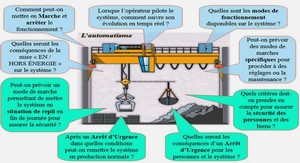

Le dernier thème abordé dans ce travail sera celui de la hiérarchie. On ne parle pas ici de hiérarchie entre plusieurs tâches, mais plutôt d’un échelonnage des niveaux de décision. Les niveaux plus hauts dans la hiérarchie donnent leurs objectifs aux niveaux du dessous, et ainsi de suite. Il peut être très utile de séparer les problèmes de décision, afin de se concentrer pleinement sur chacun d’eux. La structure du modèle probabiliste développé dans ce travail permet à ces différents niveaux d’interagir, sans perdre de l’information durant les transitions. Un exemple de hiérarchie pour la locomotion d’un robot bipède peut être le suivant : 1. Choisir la salle où l’on souhaite se rendre en tenant compte des avantages et inconvénients de chaque salle. 2. Choisir la vitesse pour se rendre à la salle souhaitée, en tenant compte de la carte du lieu et des obstacles présents sur le chemin. 9 3. Choisir la position du prochain point d’appui pour atteindre la vitesse souhaitée, en tenant compte des obstacles au sol et des possibilités mécaniques du robot. 4. Choisir les commandes des moteurs pour atteindre la position du point d’appui souhaitée, en tenant compte des synchronisations entre les moteurs, de leur puissance et de leur précision. Dans ce travail, on se concentre sur le niveau 3 de cette hiérarchie. On s’intéressera aussi au niveau 2 pour observer les interactions entre ces deux niveaux, et on évoquera rapidement le niveau 4.

Apport scientifique

De nombreuses méthodes de contrôle de la marche bipède existent aujourd’hui. Le type de modèle probabiliste utilisé dans ce travail peut en réalité être développé autour de la majorité d’entre elles. L’objectif de cette thèse est donc de montrer l’intérêt de l’approche probabiliste dans le cadre du contrôle de la marche. Le développement du modèle probabiliste, et la démonstration de son intérêt dans le cadre de l’intégration d’incertitudes et de la fusion d’objectifs, a été l’objet d’une publication dans les proceedings de la conférence CLARWAR 2016 (ROSE-ANDRIEUX et al., 2016).

Plan de lecture

Dans le Chapitre 2 : Récupérer son équilibre, nous commencerons par présenter les méthodes existantes pour garder l’équilibre. Ces méthodes se basent sur des modèles simplifiés de la dynamique d’un humanoïde que nous présenterons, avant de nous concentrer sur le modèle que nous avons utilisé. À partir de ce modèle, on déduit une stratégie de rééquilibrage. Enfin, nous confronterons les prédictions de notre stratégie aux résultats d’une expérience préliminaire sur l’homme. Ceci va nous permettre de tester la validité des hypothèses de notre modèle et la pertinence de la stratégie de rééquilibrage choisie. Dans le Chapitre 3 : Marche bipède, nous ferons en premier lieu une revue des différents contrôles de la marche existants en robotique. Nous choisirons la méthode qui nous parait la plus prometteuse, et la plus à même d’être adaptée à un contrôle probabiliste. Dans la fin de ce chapitre, nous présenterons l’environnement de simulation qui sera réutilisé tout au long de ce travail, avant de montrer quelques trajectoires obtenues en suivant la stratégie développée dans le chapitre. 10 Le Chapitre 4 : Modèle probabiliste décrit en détails la manière dont on construit notre modèle probabiliste. Nous verrons l’utilité des différentes distributions qui composent ce modèle : pour intégrer les incertitudes des capteurs et du modèle, et pour combiner plusieurs objectifs. À la fin du chapitre, nous présenterons quelques simplifications mathématiques permettant de réduire la complexité du calcul de l’inférence. C’est le modèle probabiliste développé dans ce chapitre qui sera ensuite testé dans les chapitres 5, 6, 7 et 8. Le Chapitre 5 : Incertitudes sur les variables mesurées et le Chapitre 6 : Incertitude sur la dynamique testent les capacités du modèle probabiliste à prendre en compte les incertitudes des capteurs et de la dynamique respectivement. Nous verrons dans un premier temps comment ces incertitudes sont intégrées dans notre modèle. Ensuite nous comparerons en simulation les performances de modèles ayant une estimation plus ou moins précise de l’incertitude réelle. Le Chapitre 7 : Fusion d’objectifs explore les interactions entre deux objectifs dans le modèle probabiliste. De nouveaux éléments seront ajoutés à la simulation pour pouvoir tester efficacement ces interactions. Pour réaliser la tâche demandée, le modèle va devoir faire des compromis et changer rapidement d’objectif au cours de l’expérience. Dans le Chapitre 8 : Hiérarchie, nous construisons un modèle à un niveau supérieur de la hiérarchie. Nous verrons comment ce modèle s’imbrique avec le précédent, et l’utilité de ce nouveau modèle dans une tâche qui demande de la planification. Le Chapitre 9 : Expériences robotiques résume le travail fait pour implémenter le contrôle sur un robot réel, et dans le simulateur Gazebo. Nous analyserons les problèmes rencontrés dans chaque cas afin d’en tirer des leçons constructives. Enfin le Chapitre 10 : Conclusion fait le bilan des résultats de cette thèse, avant d’évoquer des pistes de recherche intéressantes qui pourraient suivre celle-ci.

1 Introduction |