Interaction

Le projet d’une socialisation de la technique ne doit pas se limiter au niveau le plus élevé dit « de la société » ; si il veut jouer un rôle plus important que celui d’un manteau humaniste fait de bonne volonté, il doit nécessairement viser vers le bas, vers les méthodes et stratégies employées dans la pratique de la construction technique. Pour qu’un design orienté-société puisse devenir effectif, il est nécessaire de le transposer sur le terrain où la technique se fait. Le deuxième niveau de discussion est donc celui de l’interaction, c’est-à-dire du champ de la rencontre entre l’être humain et la machine. Ce niveau représente le territoire de préférence du design orienté-usager ; nous n’allons pas essayer de remplacer les stratégies et méthodes qui ont prouvé leur valeur, mais de montrer comment on peut y prendre en compte, de façon supplémentaire, les trois vecteurs d’une éthique pragmatique que nous avons dégagé plus haut.

Transparence

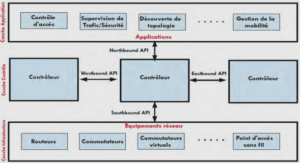

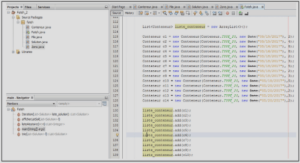

Concernant notre demande en faveur d’une transparence et d’une lisibilité plus franches et généralisées des outils et logiciels, nous pensons que l’interface graphique, lieu de confrontation entre la logique de la machine et celle des êtres humains, est d’une importance majeure. Les représentations d’un processus technique influencent directement sur l’image que l’usager peut s’en faire et les métaphores visuelles et mécanismes d’interaction employés dirigent l’imaginaire et orientent l’activité dans une direction plutôt qu’une autre [cf. Manovich 2001, p. 16]. C’est à travers l’écran que le logiciel produit une matérialité accessible à l’appareil perceptif des usagers. Selon Bardini [2001, p. 104] l’interface constitue le terrain de représentation où le designer construit l’usager, réalise le modèle qu’il s’en est fait. L’espace de possibilités d’action dont nous avons parlé plus haut se bâtît à travers l’interface. Par conséquent, cette surface ne peut plus être comprise seulement comme une belle façade collée sur le « véritable » produit, le programme ; car pour l’usager, elle est le produit [Crampton Smith / Tabor 1996, p. 39]. Pour reprendre la séparation de Manovich [2001], l’interface est l’endroit où la couche culturelle rencontre la couche informatique et les représentations graphiques et symboliques choisies ouvrent le passage de l’une à l’autre.

La distance qui existe entre les opérations techniques et les images et symboles utilisés pour les représenter est difficilement mesurable de façon quantitative, ce qui ne veut pas dire qu’il n’y ait pas de degrés d’équivalence et de véracité. L’orientation du design orienté-usager vers le néophyte et le souci de simplicité qui accompagne ce choix ont parfois pour effet la production d’interfaces ou d’éléments d’interface qui cherchent à cacher la technicité des processus derrière une métaphore élaborée, censée rendre l’utilisation plus « intuitive » ou plus proche du monde non-technique hors de la machine. Particulièrement dans le contexte des agents d’interface [cf. Lieberman 1996 ; Caglayan / Harrison 1997], un grand nombre de programmes font appel à des représentations iconiques anthropomorphiques ou zoomorphiques.

Métatechnologies et délégation

La fonction de recherche sous Windows XP, l’agent d’interface du site agentland et l’avenir des possibilités graphiques, Alyx du jeu Half-Life 2

Dans le prolongement de nos préoccupations, nous sommes persuadés qu’une grande partie de ces tentatives – très souvent des échecs complets comme Microsoft Bob ou les « assistants » de Microsoft Office208 – ne sont pas seulement peu efficaces, mais qu’ils contiennent un vecteur de dissimulation et de détournement du fonctionnement de la machine. Et même si on est prêt à concéder que des agents prenant la forme d’un petit chien ou d’une jeune fille209 pourraient éventuellement faciliter, pour une certaine partie de la population, l’usage des ordinateurs, l’infantilisation et la dissimulation qu’une telle démarche implique nous semblent bien difficiles à mettre en accord avec le principe de transparence tel que nous l’avons identifié. L’ambiguïté de l’anthropomorphisme s’accentue encore plus lorsqu’on prend en compte une remarque de Lucy Suchman : « Dès que les artefacts informatiques manifestent le moindre signe de capacités humaines reconnaissables, nous sommes enclins à leur attribuer le reste. » [Suchman 1987, p. 14]

Selon l’auteur, l’utilisation d’une représentation anthropomorphique change la grille d’interprétation des usagers envers l’outil ce qui introduit un mélange de registres qui rend tout apport prétendu de facilité d’usage au mieux ambigu.

Cela ne veut pas dire que le désir de simplicité serait mauvais en soi, bien au contraire – ce que nous critiquons dans l’anthropomorphisme est la ruse qui consiste à profiter d’une dimension symbolique et émotionnelle qui ne sert que trop souvent à cacher des incongruités dans le design de l’outil en question. L’anthropomorphisme est une façon courante de cacher le manque de finition et de logique d’un logiciel derrière la façade d’une « personnalité » à laquelle l’usager est plus disposé à pardonner lacunes et inconsistances [Winograd / Flores, p. 164 ; Lanier 1995]. Une authentique simplicité se trouve par contre beaucoup plus du côté d’une véritable transparence : dès lors que le fonctionnement de base d’un programme est compris par l’usager, toute l’utilisation devient plus facile parce qu’elle peut s’insérer dans un contexte de compréhension plus large. La peur de demander à l’usager de penser [cf. Krug 2006] est donc doublement problématique : en excluant l’idée d’un apprentissage de la part du consommateur elle devient une force de conservatisme, et ceci sans nécessairement réussir son pari de rendre l’application plus facile à utiliser. L’arrière-plan du problème concerne évidemment des questions plus anciennes – dans son fameux texte « Beantwortung der Frage: was ist Aufklärung? » (Qu’est-ce que les Lumières ?) Kant le formulait dans un soupir : « Il est si aisé d’être mineur ! Si j’ai un livre qui me tient lieu d’entendement, un directeur qui me tient lieu de conscience, un médecin qui décide pour moi de mon régime, etc., je n’ai vraiment pas besoin de me donner de peine moi-même. » [Kant 1784, p. 481]

Le projet de la « sortie de l’homme de sa minorité dont il est lui-même responsable » [ibid.] est au centre même de la fondation philosophique de la démocratie occidentale et bien évidemment, « se donner de [la] peine » en fait partie intégrale parce que l’effort est la seule façon de grandir. Une citation plus récente nous aide à mettre le doigt sur le dilemme de la délégation en tant que principe de design :

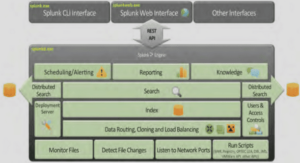

« Les agents offrent la possibilité de fournir une assistance amicale, d’une manière si lisse que les usagers n’ont même pas besoin d’en être conscients ; de la même façon que l’automobile moderne contrôle des partie du moteur qui nécessitait auparavant une intervention humaine – p.ex. le correcteur d’avance, starter, changement de vitesse – la plupart d’entre nous est ravi d’oublier ces choses. Les agents promettent de cacher la complexité et d’effectuer des actions que nous ne pourrions pas ou ne souhaiterions pas faire nous-mêmes. » [Norman 1997, p. 56] « Cacher », « oublier », « ne pas être conscient » sont certainement des mots qui marquent une opposition autant au projet des Lumières qu’au principe de transparence. Norman ajoute donc sur la même page : « Mais la promesse est accompagnée d’un danger potentiel. » (But along with the promise comes potential danger.)

Nous ne pouvons pas entrer véritablement dans le vaste domaine de la construction d’interfaces, mais nous souhaitons insister sur un point qui nous semble central : nous avons lié la notion de lisibilité à la pratique du contrôle par les citoyens dans le cadre d’une délégation. Dans ce contexte, il ne suffit pas de se demander comment on pourrait rendre les outils plus « utilisables » ou « conviviaux » ; se limiter à l’élimination des difficultés fait oublier que les NTIC peuvent participer activement à l’émergence d’une véritable « cyberculture » [Baltz 2005] chez les usagers, c’est-à-dire l’émergence d’un sens critique basé sur l’acquisition des « outils conceptuels permettant de penser les fondements de la société d’information » [ibid., p. 6].210 Nous devrions voir que d’autres « effets » peuvent être produits à travers des objets techniques que l’accomplissement d’une tâche. Le projet Projected Realities de William Gaver et Anthony Dunne [1999] peut compter au nombre des efforts pionniers d’un design ciblé sur des « effets culturels » parce que les différents dispositifs techniques installés par ces auteurs dans une vaste cité d’habitation aux Pays-Bas avaient pour but de favoriser chez les habitants la prise de conscience de leur communauté en tant que communauté. La « tâche » de la technique consistait effectivement à produire un changement de regard et d’attitude chez ses usagers.

En parlant du clavier à cinq touches que Douglas Engelbart avait inventé quasiment en même temps que la souris, mais qui rencontra finalement un destin bien moins brillant, Bardini nous rappelle que pour ce pionnier, le but ne consistait pas simplement à produire des outils « agréables » pour les usagers, mais à trouver des éléments techniques qui permettraient de les « augmenter ».

« Engelbart ne voulait pas adapter sa technologie à la façon dont les gens travaillent – il voulait utiliser cette technologie pour changer la façon dont les gens travaillent, et pour lui, le clavier à cinq touches offrait le meilleur moyen d’y parvenir. » [Bardini 2000, p. 80]

Nous ne pensons pas que tout dispositif technique doive prendre une posture pédagogique (et l’échec du clavier à cinq touches montre les risques d’un tel effort), mais il est intéressant de voir que cette aspiration à créer des outils capables de changer consciemment les pratiques ou connaissances des usagers a quasiment disparu de certains courants du design orienté-usager.211 Pourtant même de façon très simple, il reste possible de produire une « transparence informatrice » ; on pourrait par exemple imaginer l’affichage d’un bouton « comment ça marche » à certains endroits de l’interface d’un outil, qui donnerait sur un texte expliquant les bases du fonctionnement du programme. Le paradigme du design qui dit qu’un outil devrait être auto-explicatif ne nous ferme-t-il pas parfois la porte vers des stratégies plus « traditionnelles », telles que la pédagogie et l’explication ? Est-ce que la certitude que l’usager ne peut pas comprendre les complexités de la technique, ne devient pas une « prophétie auto-réalisatrice » (self-fulfilling prophecy)212 ?

Pour revenir brièvement au débat entre manipulation directe (l’initiative et l’expertise viennent de l’utilisateur) et délégation (la machine prend l’initiative et possède de l’expertise) dans le domaine du design d’interfaces dont nous avons parlé plus haut, nous ne pensons pas que les agents conduisent automatiquement à une absence de transparence et les interfaces WIMP à la lisibilité, à l’émancipation et au contrôle. La ligne qui sépare la tutelle qui fait de l’usager un enfant de la simplicité, dont le but est de faciliter et de stimuler un apprentissage, ne passe pas uniquement par la question de savoir comment l’expertise et l’initiative doivent être distribuées entre l’être humain et la machine ; idem pour la transparence. Le fait qu’un logiciel soit doté d’une certaine expertise localisée et d’une capacité de prendre l’initiative sans consulter l’usager, ne veut pas automatiquement dire qu’il ne puisse pas expliquer et faire comprendre à celui-ci ce qu’il fait et sur quelles bases. L’agent SpamBayes n’est pas moins transparent que Google avec son interface de manipulation directe, et l’existence de paramètres avancés de recherche ne garantit absolument pas que les gens les utilisent. Un moteur de recherche qui s’approche de la métaphore d’agent pourrait activement suggérer à l’usager des stratégies de recherche plus complexes, et par conséquent provoquer un apprentissage. Dire que les agents intelligents sont automatiquement des « agents d’aliénation » [Lanier 1995] nous semble aussi simpliste que l’idée selon laquelle la manipulation directe serait une garantie de transparence. La vraie question consiste à savoir comment on peut profiter de l’automatisation impliquée par la stratégie « agent » de façon responsable et la réponse ne peut être donnée qu’en étudiant les applications et leurs contextes au cas par cas. De manière générale, nous pensons pourtant que délégation et transparence doivent aller ensemble pour ne pas produire des effets négatifs.