L’évaluation de la politique étrangère

L’institutionnalisation de l’évaluation

Elle se marque par la mise en place de structures spécialisées, par un essai de rationalisation des méthodes par une tentative de typologies des actions évaluables. La politique institutionnelle On peut discerner trois vagues successives de mise en place d’une évaluation institutionnelle correspondant à ces causes et motivations qui interfèrent. La première étape, intervenue très rapidement, est liée à un discours international et résulte d’un besoin interne des autorités politico-administratives d’avoir des éléments de réflexion sur leur propre action. La deuxième étape est une mise en concordance du dispositif d’évaluation de l’APD (aide publique au développement) avec les tentatives plus générales d’institutionnalisation de l’évaluation faites par Michel Rocard dans une perspective d’amélioration du management public et de la démocratie. Dans un troisième temps, il s’est moins agi de rendre l’évaluation ponctuellement opérationnelle que de rationaliser l’ensemble du dispositif d’aide au développement en tentant d’échafauder un système qui corresponde à un vœu de coordination interministérielle plus qu’à une volonté d’intensifier les réalisations de terrain . • L’évaluation a commencé à s’instituer en France dans les années 1980, tant pour des raisons techniques que politiques que sous la pression des exemples internationaux. A la base du souci d’évaluation, on trouve une préoccupation d’économies et de rationa- . lité relevant d’un désir de renouveau managérial du service public d’inspiration anglo-saxonne; mais on rencontre aussi un souci de démocratie: il faut donner aux citoyens des informations sur la marche et le coût des services publics. L’efficacité des politiques de coopération au développement est une préoccupation des gouvernements et des organisations donateurs qui souhaitent donner de la crédibilité à leurs interventions. A l’origine, l’évaluation de l’aide au développement a plutôt été une idée de gauche en France: au ministère de la Coopération, lors de l’entreprise de rénovation politique lancée au moment de l’arrivée de la gauche au pouvoir, le ministre Jean-Pierre Cot se préoccupa de créer un système d’évaluation. Cette tâche fut donnée à la sous-direction des études et du développement mais disparut lors de l’arrivée de la droite au pouvoir en 1986 avec le gouvernement de Jacques Chirac. En 1988, le gouvernement Rocard confia à un service rattaché au cabinet du ministre une mission d’évaluation permanente. Avec le ministre de la Coopération de l’époque, M. Pelletier, l’évaluation s’institutionnalise réellement. Mais la préoccupation était en fait assez générale et liée à un besoin administratif de guider des actions que leur éloignement et leur coût rendent hasardeuses. On la retrouve dans d’autres lieux où se pratiquait l’aide au développement: la direction du Trésor du ministère de l’Économie et des Finances et la Caisse centrale de développement.

Rationalisation des méthodes

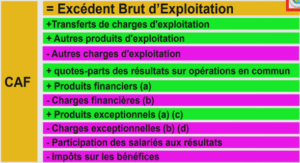

Parallèlement, les méthodes mises au point pour formaliser l’évaluation lui ont donné un caractère procédural tout en voulant garantir une certaine souplesse spécifique des principes de l’évaluation à la française. On y trouve également un écho des préoccupations internationales. • Les principes d’évaluation retenus sont consignés dans des fascicules méthodologiques (Ministère des Affaires Etrangères, Ministère de la Coopération, OCDE). Chaque institution a le sien, mais il existe également un guide général réalisé par le Conseil scientifique de l’évaluation. Les principes clés y sont à peu près les mêmes et sont largement inspirés des règles énoncées par les organisations internationales, notamment la Banque mondiale et, surtout, le Comité d’aide au développement de l’OCDE, qui joue le rôle de mentor international en la matière par un texte édité en 1991 et remanié par la suite. Un cadrage prévoyant le déroulement progressif des opérations est dessiné. Il vise à définir les conditions de la commande de l’évaluation, le champ qu’elle doit couvrir, la chronologie à respecter. La déontologie de base est la suivante: il faut assurer l’impartialité, l’indépendance, la crédibilité, la légitimité des rapports d’évaluation. • Des structures à peu près analogues se superposent les unes aux autres, tentant de concilier le principe de l’autonomie de l’évaluateur tout en laissant leurs zones de pouvoir aux politiques et aux administrations qui risqueraient de ne point prêter leurs concours aux évaluateurs si ceux-ci se montraient des juges impitoyables. Les responsables politico-administratifs se réunissent une à deux fois par an, arrêtent le programme des années à venir, décident de la suite à donner aux conclusions faites lors des évaluations. Le travail d’organisation et le suivi des évaluations est fait par des services spécialisés permanents peu étoffés qui réunissent de deux à . six personnes et font appel à des évaluateurs extérieurs. Ici des nuances existent: l’appel à des cabinets privés et à des universitaires, à des fonctionnaires des grands corps est le plus classique et est préconisé par les organisations internationales. La Caisse, devenue « agence », est la seule à faire effectuer elle-même, par ses propres agents, les évaluations. En principe, l’appel à des opérateurs extérieurs aux services opérationnels doit garantir l’objectivité de l’évaluation. Une méthodologie se met au point et se généralise. Les évaluations sont des évaluations « ex-post ». Elles ont comme caractéristiques de se situer dans le cadre d’objectifs prédéterminés. Ces objectifs sont censés être suffisamment précis pour être confrontés rigoureusement à l’examen à travers le filtre des résultats obtenus. L’idée de base est que ces objectifs doivent avoir un aspect opérationnel marqué et se situer hors du domaine des valeurs subjectives et de l’idéologie. Les interrogations posées se réfèrent à la causalité et concernent l’adéquation entre les moyens et les résultats et le niveau de réalisation des objectifs. Les mots « efficacité» et « efficience» sont au cœur de ces opérations. L’efficacité se mesure à l’aune d’une comparaison des effets réels aux objectifs fixés. L’efficience est plus difficile à aborder que l’efficacité car elle suppose un bilan « coût-avantage », Elle est utilisée dans son sens le plus restreint, celui de l’approche «coût-efficacité », qui consiste à comparer les coûts nécessaires à la réalisation d’un certain niveau de résultats pour différentes politiques: les ressources mobilisées ont-elles été bien utilisées dans tel ou tel cas précis? Les moyens utilisés peuvent être variés: à défaut du 31 quantitatif et des statistiques, on peut se référer aux entretiens et à l’observation. L’expérience française a été marquée de façon indirecte par les réflexions élaborées dans le périmètre du Conseil scientifique de l’évaluation, création du gouvernement Rocard. Elle est «participative ». Elle s’impose d’impliquer dans les opérations, à divers stades de l’évaluation, les acteurs qui ont œuvré dans la réalisation des projets examinés. Elle insiste sur la prise de conscience des modes de réalisation et de déroulement de l’action publique par ceux qui la font. C’est une évaluation « pluraliste »,qui permet aux différents points de vue de se confronter. Elle s’inscrit dans une perspective éducative.

Typologie des évaluations

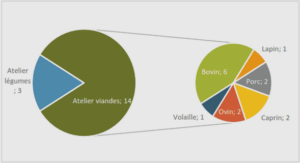

La typologie des évaluations donne une illustration de la variété des techniques. De nombreux rapports d’évaluation ont été réalisés par les quatre institutions clefs responsables de la coopération: ministères des Finances, de la Coopération, des Affaires étrangères, des Finances, Caisse centrale. Une liste officielle permet de dénombrer 101 rapports entre 1989 et 1999. Chaque organisme avait traditionnellement sa spécificité: évaluation de projets pour la direction du Trésor et la Caisse; évaluation de « quatre types» pour la Coopération: par pays sur une longue durée, par secteur, par moyens, par projet. Les Affaires étrangères se concentraient sur des politiques de coopération géographiques sectorielles, sur des instruments et des moyens. Pour résumer ce tableau, on peut dire que les ministères les plus généralistes comme les Affaires étrangères et la Coopération faisaient se côtoyer les très vastes évaluations concernant une politique à large spectre examinée sur une période pouvant être assez longue et les évaluations de projets à portée réduite et bien circonscrite. Les financiers et techniciens du Trésor et de la Caisse préféraient les objets bien identifiés, les opérations à portée étroite. Une évolution générale se fait – notamment à la direction du Trésor – vers l’évaluation de programmes sectoriels plus que de projets. On trouve ici l’influence de la Banque mondiale, au sein de laquelle existe une réflexion tendant à élargir le champ des évaluations. Des examens trop ponctuels amèneraient à négliger des éléments contextuels essentiels pour la réussite de la coopération au développement: «Programs and projects are now measured against multiple goals, including economie governance, private sector development and the promotion of participatory, equitable and environmentally sustainable developmenr’ ». Par ailleurs, des progrès suffisants auraient été faits dans les méthodologies de l’évaluation et permettraient de s’attaquer à des ambitions plus larges, donc à des politiques: «We can take on more complex, ambitious policy questions than in the past », écrit Eleonor Chelimski dans ce même volume. Ces perfectionnements des normes évaluatives n’empêchent pas une certaine stagnation des pratiques. On observe un désinvestissement politique administratif se marquant au niveau des réalisations. L’évaluation est certes devenue un instrument officiellement reconnu du management public. Il est impossible d’y renoncer en raison du contexte ‘international. L’évaluation est donc officialisée dans les organigrammes. Elle semble se transférer vers le niveau interministériel, en étant en partie confiée à des comités ou groupes de travail transversaux communs à plusieurs ministères ou également rassemblant plusieurs acteurs au sein d’un même ministère. Sur le terrain, elle semble sinon dépérir, du moins être en panne. Il demeure une évaluation opérationnelle traditionnelle faite par les services eux mêmes.

Spécificité de l’évaluation de la politique étrangère

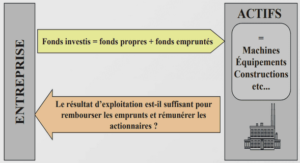

L’évaluation de la politique étrangère peut se faire au sein d’un système d’objectifs dont on juge la réussite. Mais on peut imaginer d’aller plus loin et de s’attaquer à une analyse de la valeur même des buts recherchés. Dans un chapitre consacré à l’évaluation de la politique étrangère, Gregory A. Raymond pose clairement le problème à la lumière d’une citation tirée de Don Quichotte: « ln his epie novel, Don Quixote, Ccrvantcs dcscribes a conversation bctwccn his protagonist and the owncrs of a large estate. One of the topics they discuss is the ability of Don Quixote’s squire, Sancho Panza, to govern Barataria… Don Quixote predicts Sanche will be a good governor, for the main thing « is to mean weil and desire to do right. .. », Embodicd in this prediction is a distinction betwcen judging government actions good or bad on the basis oftheir INTENTIONS, versus judging them according to their effectiveness in achieving intended result. ». Les deux alternatives vont être successivement prises en compte et, à leur lumière, une certaine spécificité de la politique étrangère va apparaître. L’évaluation par rapport aux buts Elle prend les buts des politiques et programmes comme des données de base, et recherche si et comment ils ont été atteints. Les buts sont la source des standards et des critères mis au point par les évaluateurs. Les systèmes d’évaluation mis en place en France et utilisés essentiellement dans le cadre de l’aide publique au développement entrent globalement dans ce schéma. A la base se trouve l’idée d’une certaine rationalité de la décision qui s’effectue en fonction de buts déterminés. L’idée de la rationalité de la décision a subi beaucoup d’interprétations et d’avatars. Sous son incarnation la plus radicale peut s’inscrire la tentative de rationalisation des choix budgétaires qui, sous sa forme américaine, le PPBS – planning programming and budgeting system -, a donné lieu dans les années 1970 à des expériences extensives au département de la Défense des États-Unis, sous la direction de William Gorham. Les expériences actuelles se réclament plutôt d’une rationalité limitée telle qu’elle découle des travaux de Herbert Simon, approfondis par la suite (Meny Y. et Thoening J.-c.). La meilleure décision est celle « qui satisfait et qui suffit». On se situe donc à un niveau moins général- celui de l’utilité maximum ou efficience. Le meilleur choix ou le plus efficient est celui qui apporte une satisfaction suffisante. La comparaison des différents guides d’évaluation français et internationaux effectuée par le Conseil scientifique de l’évaluation dans son rapport officiel de l’année 1997 montre que c’est généralement dans ce cadre de l’analyse de l’efficience que se sont construits les modèles actuels d’évaluation.