Mémo technique LE DATAMINING

Les technologies du datamining

Le processus du datamining

Quel que soit le domaine d’applications, une opération de datamining suit globalement un processus en huit étapes : 1. poser le problème 2. rechercher des données 3. sélectionner les données pertinentes 4. nettoyer des données 5. transformer les variables 6. rechercher le modèle 7. évaluer le résultat 8. intégrer la connaissance

Les principaux algorithmes de datamining

On dénombre sept techniques principales dans le domaine du datamining :

1. Apprentissage fondé sur l’explication (EBL pour Explanation Based Learning) : Apprentissage formé sur des explications dérivées d’une théorie (généralement incomplète) fournie en entrée. Cette forme d’apprentissage repose sur des déductions pour expliquer les données à partir de la théorie et sur des arbres de décision pour générer de la nouvelle connaissance.

2. Apprentissage statistique (STL pour Statistical Learning) : Cet apprentissage repose sur des opérations statistiques telles que la classification bayésienne ou la régression pour apprendre à partir de données.

3. Apprentissage par réseaux neuronaux (NNL pour Neural Network Learning):Un réseau de neurones est défini par un ensemble d’unités de traitement qui peuvent être des unités soit d’entrée, soit de sortie, soit cachées. L’apprentissage s’effectue par l’injection de cas en entrée et par la mesure des conclusions en sortie.

4. Apprentissage par algorithme génétique (GAL pour Genetic Algorithm Learning) : Les algorithmes génétiques sont des procédures de recherche fondées sur la dynamique de la génétique biologique. Ils comportent trois opérateurs, la sélection, la combinaison et la mutation, qui sont appliqués à des générations successives d’ensemble de données. Les meilleures combinaisons survivent et produisent, par exemple, des plannings, des règles…

5. Apprentissage par similarité (SBL pour Similarity Based Learning) : Ces techniques utilisent des indicateurs de similarité pour regrouper des données ou des observations et pour définir des règles.

6. Apprentissage symbolique empirique (SEL pour Symbolic Empirical Learning) : Cette forme d’apprentissage extrait des règles symboliques compréhensibles par l’utilisateur à partir de données. On retrouve dans cette catégorie les algorithmes ID3/C4.5 et CN2 notamment.

7. Apprentissage par analogie (ANL pour Analogy Learning) : L’apprentissage s’appuie sur l’analogie entre un nouveau cas et des cas ressemblants soumis préalablement.

Les principales natures de problèmes qui sont résolues par ces techniques sont au nombre de sept :1. Classification : La capacité de classer des objets ou des événements comme membres de classes prédéfinies.

2. Prédiction : Liée à la classification, cette tâche vise à prédire une ou plusieurs caractéristiques inconnues à partir d’un ensemble de caractéristiques connues.

3. Optimisation : Il s’agit d’optimiser un ou plusieurs paramètres d’un système, compte tenu d’un ensemble de contraintes.

4. Planning : Cette tâche consiste à déterminer un ensemble d’actions ordonnées qui satisfont un ensemble donné de buts.

5. Ordonnancement : L’ordonnancement suit le planning et consiste à positionner des actions dans le temps et à leur affecter des ressources.

6. Acquisition de connaissance : L’acquisition de connaissances consiste à créer une représentation efficace et fidèle de la connaissance d’experts.

7. Résolution de conflits : La résolution de conflits peut, par exemple, aider à départager des experts qui sont en désaccord ou s’appliquer dans le cadre de processus de négociation.

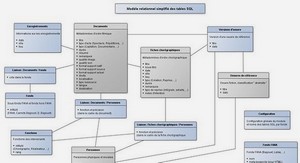

La segmentation des éditeurs et des prestataires de Data Mining

Les fournisseurs de logiciels peuvent être segmentés selon leurs capacités à couvrir plus ou moins le triangle formé par l’acquisition de connaissance, la planification et la classification. Certains fournisseurs ont une stratégie de niche. Ils optimisent leur outil pour prendre le leadership sur un des sommets du triangle. Cette stratégie est notamment celle suivie par les fournisseurs de réseaux de neurones. D’autres développent une stratégie généraliste. Ils partent d’un des sommets du triangle et font évoluer leur offre pour couvrir l’ensemble de la surface, tout en développant des liens étroits entre leurs différentes offres. Cette stratégie est notamment mise en œuvre par les fournisseurs d’outils statistiques. Puisque la demande s’oriente vers l’utilisation conjointe de différentes techniques, la stratégie généraliste semble gagnante à terme. Les approches sont différentes selon la taille et la notoriété des fournisseurs. Les plus importants mettent en place d’importantes équipes de chercheurs. Ceux-ci travaillent pour optimiser et intégrer les technologies dans une gamme logicielle. Certains choisissent de s’allier et s’occupent des passerelles de communication entre les produits. Les derniers venus sur le marché pratiquent une politique de rachat de technologies ou d’acquisition de sociétés. L’offre d’outils de datamining est aujourd’hui atomisée. Aucun fournisseur d’outils ne peut se targuer d’être le standard du marché, ni même d’en détenir une part réellement significative mais une typologie des éditeurs se dégage néanmoins.

Les fournisseurs de logiciels statistiques

SAS Institute et SPSS, pour ne citer qu’eux, vendent depuis bien longtemps des outils de datamining… à l’image de Monsieur Jourdain qui faisait de la prose : sans le savoir. Ils restent aujourd’hui des intervenants majeurs du marché. La qualité et les capacités d’évolution de leurs offres sont démontrées. La connaissance des statisticiens, lesquels se positionnent, à tort ou à raison, comme les futurs « dataminers » dans leurs entreprises, leur assure un accès plus facile au marché. Ces éditeurs disposent de ressources conséquentes et de revenus récurrents (la plupart des logiciels statistiques font l’objet d’une location et non d’une vente) qui leur permettent de suivre une stratégie généraliste. Citons pour exemple la société SAS : elle propose son offre traditionnelle SAS System, ensemble de modules statistiques, et a su construire une offre intégrée de datamining connue sous le nom de SAS Enterprise Miner.

Les vendeurs de matériels

Il est naturel que les vendeurs de machines développent ou acquièrent des technologies de datamining afin de justifier la débauche de puissance qu’ils proposent à leurs clients. A ce titre, IBM, NCR, Siemens ou Silicon Graphic, pour ne nommer qu’eux, développent des offres d’outils de datamining. Ils s’appuient pour cela, soit sur leurs propres laboratoires de développement soit sur des accords de distribution avec des sociétés qui proposent des technologies de datamining. A l’heure actuelle, seuls IBM, avec Intelligent Miner, et Silicon Graphic, avec Mineset ont choisi une stratégie globale et fondée sur des développements internes.

Les startups

La plupart des algorithmes de base du datamining sont du domaine public. On peut en trouver tous les détails de fabrication dans les thèses de doctorat ou dans les comptes rendus des congrès spécialisés. Il est donc naturel que des individus développent à moindre coût des produits qui peuvent tout à fait rivaliser en performance et en qualité avec des solutions « poids lourd », tout au moins sur une ou deux des techniques de modélisation du datamining. La pérennité de ces entreprises mono produits se jouera, comme c’est toujours le cas sur les marchés des technologies, avant tout sur leur capacité commerciale et marketing. Les meilleures auront dès lors deux solutions : se vendre à une entreprise avec laquelle elles présentent une complémentarité ou racheter des startups concurrentes pour enrichir leur gamme ou prendre des parts de marché.

Les intégrateurs

Ce panorama ne serait pas complet sans parler des sociétés de services, telles que Soft Computing en France. Elles proposent des prestations d’application ou de transfert de technologies autour du datamining. Elles n’ont pas d’offres d’outils à proprement parler, mais disposent de nombreux logiciels. Elles apportent des conseils pour choisir les outils, former les équipes internes et apporter une aide méthodologique dans la résolution de problèmes concrets. Elles présentent une alternative viable aux entreprises qui ne justifient pas de la taille critique, qui ne disposent pas des compétences internes requises, ou qui, tout simplement, souhaitent que l’intégration de ces technologies soit progressive et guidée par des professionnels expérimentés.