Première étude : Google

Nous avons déjà parlé à plusieurs reprises des moteurs de recherche ; non pas parce que ce sont les métatechnologies les plus élaborées qui existent, mais parce que leur visibilité est si grande et leur position de pouvoir si évidente qu’il devient difficile de nier l’importance et l’urgence de se poser certaines questions d’ordre politique et culturel à leur sujet. En Europe par exemple, la recherche d’informations reste l’activité la plus répandue sur Internet84. Le moteur de recherche qui a rencontré le plus de succès ces dernières années, Google85, a suscité une vague d’études et d’articles [Introna / Nissenbaum 2000 ; Gerhart 2004 ; Shaker 2005 ; Rieder 2005 ; etc.] qui portent à juste titre sur les dimensions politiques et éthiques de cette « machine de mise en relation » omniprésente et apparemment incontournable. Une étude récente de l’institut américain Pew Internet & American Life Project [Fallows 2005] montre à quel point les moteurs de recherche sont devenus des nœuds centraux du Web et de l’activité des internautes. 86 On peut affirmer sans détour que ces hybrides composés d’organisation commerciale et de logiciel sont devenus des institutions87. En tant que métatechnologies, ils se penchent sur les flux d’informations, traduisent le paysage plat de la toile en listes hiérarchiques, et certains d’entre eux se chargent même d’en tirer des cartes (interactives) en deux ou trois dimensions. Sur l’hypertexte géant qui embrasse le globe, les moteurs de recherche projettent des métatextes88 censés redonner un sens de l’orientation aux internautes dans un environnement devenu hors de la portée de la cognition de l’être humain, du fait de la quantité des documents et d’informations qu’il contient. Avec les moteurs de recherche, nous entrons donc pleinement dans la problématique-clé de la science de l’information : comment comprendre et soutenir l’être social en quête d’information » [LeCoadic 2004, p. 22] ? Comment lui fournir les informations qu’il cherche ? Comment trouver une réponse pertinente à sa requête, sa question ? Les développeurs de Google se posent cette même question au quotidien sous la forme : Comment déterminer l’importance d’un document ?

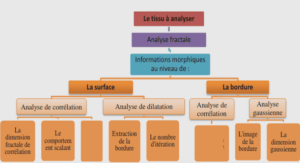

Pour mieux comprendre la réponse des créateurs de Google, Larry Page et Sergey Brin, il faut commencer par schématiser la structure basique de tout moteur de recherche. On peut distinguer au moins quatre niveaux qui comportent chacun une série de choix pratiques et techniques :

Tout moteur de recherche implique de répondre à la question de quoi et où chercher, c’est-à-dire du terrain qui sera traité. Le Web est un vaste environnement d’information hétérogène et dynamique et, pratiquement, il n’est pas possible d’en produire une représentation complète. Comme tous ses concurrents sur le marché de la recherche, devenu très lucratif, Google prétend tout de même proposer ses utilisateurs d’accéder à l’intégralité du Web. Lorsqu’on conçoit un moteur de recherche, on est cependant forcé de faire des choix et des délimitations, par exemple de cibler un champ thématique et linguistique, de restreindre la profondeur de l’arborescence hypertextuelle à « crawler »89 (explorer ou fouiller) ou de limiter la fréquence des mises à jour. Comme ils sont protégés par le secret commercial, nous ne connaissons pas les limitations pratiques des crawlers de Google, mais les analyses empiriques et les spéculations dans la communauté des chercheurs pointent une étroite relation entre le PageRank d’une page, i.e. sont degré de centralité topographique, et l’importance que Google lui accordera dans sa politique d’exploration. Une page considérée comme centrale est traitée de manière plus complète, les crawlers la pénètrent plus profondément et les mises à jour sont plus fréquentes. Le terrain de recherche est donc délimité de façon dynamique, en prenant en compte la structure de ses contenus. Il faut pourtant préciser qu’en aucun cas, les moteurs de recherche ne peuvent explorer les documents qui ne sont pas accessibles par des hyperliens. De plus, les informations qui se trouvent dans le « Web caché » (hidden Web), c’est-à-dire les sites protégés par mot de passe, les bases de données consultables uniquement par requête manuelle et les applets (Flash, Java ou autres), restent hors de portée des moteurs.

Le deuxième niveau consiste à choisir comment indexer les données recueillies lors du processus d’exploration. Cette question est centrale : l’index forme la base sur laquelle s’exercera le traitement algorithmique qui suit, ses caractéristiques déterminent la capacité et la facilité qu’auront les algorithmes à trouver des résultats intéressants. Cependant, la richesse de l’index est proportionnelle à son « poids » et un index qui fournit beaucoup d’informations pour chaque page qu’il référence prend non seulement plus d’espace de stockage, mais devient aussi plus lourd à traiter par la suite. Google se vante [Brin / Page 1998] d’établir un index très complet. Il contient le document entier pour les pages importantes ; une matrice recueillant les traits qui seront pris en compte par les algorithmes de recherche : par exemple une liste des mots uniques ; une table des hyperliens sortant de la page ou encore des indications sur la structure du document. En ce sens, les choix de la méthode d’indexation déterminent la représentation interne du terrain de recherche. Elle est nécessairement sélective.

Une fois l’index mis en place, les développeurs sont confrontés à une autre question : comment chercher dedans. Les différentes informations et caractéristiques représentées dans l’index constituent la matière première que va traiter l’algorithme de recherche. Un niveau de décision supplémentaire s’impose : quels traits prendre en compte et comment les traiter ? Question difficile car l’algorithme résultant de la réponse à cette question est censé fournir des résultats structurés, dans la plupart des cas hiérarchisés, dont on puisse dire qu’ils sont « pertinents » sur le plan de la « qualité » de l’information qu’ils véhiculent. De manière abstraite, on pourrait dire que la problématique consiste à savoir comment réduire le plus possible la « distance » entre la requête formulée par un usager et le document qui répondra le mieux à ses attentes.90 La réponse technique doit venir du traitement algorithmique de l’index élaboré à partir du terrain d’information visé. Google doit en très grande partie son succès à son moteur de classement dont les résultats se distinguaient à un moment assez fortement par leur qualité – telle qu’elle était perçue par l’ensemble des internautes – de ceux de ses concurrents. Nous allons regarder la méthode employée, PageRank, plus en détail dans un instant.

Le dernier niveau consiste à choisir la représentation visuelle des résultats. Pour l’instant, cette question peut paraître assez banale mais la présentation sous forme de liste ne constitue certainement pas le dernier mot en matière d’affichage et de structuration. On voit émerger des moteurs de recherche qui génèrent des cartes91 ou essayent de briser la linéarité de la liste en regroupant les résultats en grappes (clusters)92. Il nous semble probable que les recherches académiques et industrielles les plus pointues, qui se font actuellement dans le domaine de la visualisation des informations, vont aussi avoir des conséquences pour les interfaces des moteurs de recherche grand public. Pour l’instant, Google reste dans le très classique mais nous remarquons tout de même que sa liste traditionnelle est aujourd’hui dopée par une série de liens qui pointent vers différents services supplémentaires.

L’interface du moteur de recherche de Google

A côte des liens payés (visuellement séparés des résultats de la recherche), il existe des liens vers le cache de Google (une fonction « mémoire » qui fournit une copie des documents sur les machines de Google), vers des pages similaires (trouvées par le biais d’un traitement statistico-sémantique) ou vers d’autres services comme les newsgroups, les actualités, la recherche dans les livres ou dans un dictionnaire de langue. En fin de compte, il s’agit toujours d’une liste de résultats, mais l’interface de Google est en même temps devenue un riche carrefour qui pointe vers une multiplicité de chemins proposés à l’usager.

Dans ce chapitre nous défendons l’idée que chacun des quatre niveaux que nous venons d’identifier concerne un travail spécifique qui est délégué à la machine. Explorer l’information, la représenter sous forme d’index, produire un regard structuré par rapport à une demande (requête) et finalement l’afficher pour le communiquer à l’usager, sont des tâches séparées qui constituent pourtant l’unité d’un service rendu par la machine. Nous souhaitons aussi souligner que tout acte de transfert d’une tâche implique de souscrire à l’« art de faire » [de Certeau 1990] proposé par la machine. Elle impose une réponse à la question de savoir comment réaliser techniquement, à chacun des quatre niveaux, une méthode, une théorie, un modèle. Ces décisions techniques et pratiques sont prises par les créateurs du dispositif et non pas par les usagers. Pris ensemble, les quatre niveaux qui constituent un moteur de recherche produisent un regard particulier sur le grand réseau hypertextuel qu’est le Web. Le dispositif de recherche génère, comme représentation des résultats de son travail, un métatexte éphémère assemblé dynamiquement à chaque rencontre entre le moteur et la requête d’un utilisateur. Quelles sont les bases de la perspective proposée par le système ? Quel est le modèle qui la produit et la justifie en même temps ? Comment Google détermine-t-il ce qui est important et ce qui l’est moins ?

La grande innovation de Google à ses débuts, consistait en l’emploi d’un algorithme performant et efficace, inventé par deux jeunes doctorants en informatique, Larry Page et Sergey Brin, et nommé PageRank est un champion de la démocratie : il profite des innombrables liens du Web pour évaluer le contenu des pages Web — et leur pertinence vis-à-vis des requêtes exprimées. Le principe de PageRank est simple : tout lien pointant de la page A à la page B est considéré comme un vote de la page A en faveur de la page B. Toutefois, Google ne limite pas son évaluation au nombre de ‘votes’ (liens) reçus par la page ; il procède également à une analyse de la page qui contient le lien. Les liens présents dans des pages jugées importantes par Google ont plus de ‘poids’, et contribuent ainsi à ‘élire’ d’autres pages. »

On remarque d’abord que le vocabulaire choisi par les auteurs de ce texte à vocation commerciale va dans le sens de notre argument : derrière chaque métatechnologie gît une théorie de la signification et / ou du social qui donne forme à la modélisation technique d’une tâche pour qu’elle puisse être déléguée à un programme informatique. Au départ, le modèle choisi pour le développement de PageRank n’était pourtant pas celui de la démocratie au sens vague mais l’analogie avec le monde scientifique. L’inspiration [Brin / Page 1998 ; Page et al. 1999] en venait de l’analyse de la fréquence d’apparition des citations telle qu’elle se pratique dans l’évaluation de l’importance des publications scientifiques, méthode couramment appelé mesure du « facteur d’impact »94. Cette approche part de l’idée que chaque citation d’un article donné dans une publication de recherche peut être interprétée comme une confirmation des résultats de l’article d’origine et comme une façon de lui attribuer de la valeur. Un article massivement cité peut donc être considéré comme un nœud important. Dans un domaine comme la science, qui obéit largement aux règles de l’économie de l’attention [cf. Goldhaber 1997], le temps et la capacité d’assimilation des chercheurs représentent l’élément rare, et constituent par conséquent la ressource sur laquelle repose la production de valeur. En ce sens, une publication qui reçoit beaucoup d’attention « vaut » plus que les autres.