La navigation spatiale

Une information d’orientation relative durant un déplacement nécessite d’avoir à disposition un certain nombre d’éléments fixes ou mobiles, si leur position peut être estimée). En d’autres termes cela revient à être en mesure d’évaluer la position à un moment donné, par rapport à ces points de repères. Ainsi il devient possible d’estimer le déplacement dans un système de référence (absolu). Le relevé périodique (dt) de ces estimations permet de reconstruire la trajectoire discrète (dS), c’est à dire le cap en deux dimensions, ou encore l’attitude en navigation spatiale. Entre deux pas, nous obtenons la vitesse moyenne : v(t) = dS/dt (accélération étant dV/dt).

Les navigateurs (marins) pratiquent la navigation à l’estime quand la terre n’est pas en vue. Cette méthode consiste à établir sa position supposée à partir de la dernière position connue. La correction des erreurs (recalage) se fait souvent par l’observation des étoiles et des planètes (ou le Soleil en journée). De par leur éloignement, une immobilité apparente est donnée aux objets célestes qui ont été rapidement remarqués et utilisés pour se repérer. Ces points de repères «fixes» nous amènent dans le vif du sujet : la navigation céleste. Au fil du temps, à l’aide d’observations méticuleuses des objets mobiles ont été repérés, leur mouvement s’est vu modélisé. La mécanique céleste à permis de prédire la position de ces astres ou de certains événements remarquables (éclipses, occultation, etc.). Ces prédictions définies dans le temps permettent de faire « le point », c’est à dire d’observer une orientation. La navigation spatiale repose sur différents principes qui permettent d’obtenir une très bonne appréciation des paramètres courants que sont l’attitude, la vitesse et la position.

Depuis les années quarante, l’évolution permanente des systèmes embarqués, principalement radio à cette époque, et des algorithmes associés, ont abouti à l’intégration de fonctions essentielles aux systèmes de navigation terrestres, maritimes ou aériens. Initialement, l’espace s’est ouvert à l’exploration de par les progrès souvent engendrés par des besoins militaires. Dans le cas le plus simple pour des cibles fixes, la trajectoire est de type balistique, graduellement les progrès de la physique ont permis un contrôle plus fin.

L’extraction de données de navigation repose sur l’observation de l’environnement immédiat (accessible), ou sur des informations différentielles liées à l’usage d’instruments. La plupart des systèmes doivent être capables de compenser des erreurs systématiques. Historiquement, la navigation stellaire se base sur la mesure azimutale d’un corps céleste (étoiles, planètes, astéroïdes) afin d’en déduire la latitude et la longitude de l’observateur à une période d’observation. De nombreuses méthodes sont employées, mais les années soixante-dix marquent le développement des systèmes de vision pour la navigation céleste Celestial Navigation System, ou système de navigation stellaire (CNS) . L’approche est basée sur la reconnaissance d’un champ de vue à la condition que celui-ci contienne suffisamment d’étoiles préalablement cataloguées.

Le guidage et le suivi des missions d’exploration spatiale

Le suivi des missions se fait exclusivement par les moyens terrestres, comme décrit précédemment, les réseaux d’antennes du DSN, mais aussi d’autres infrastructures similaires tel que le European Space Tracking (ESTRACK) reposent sur la technologie RADAR. Dans la pratique, il s’agit d’architectures complexes de radiotélescopes aux objectifs multiples [56]. La principale difficulté pour garder un contact avec les sondes d’exploration, est la distance qui les séparent de la Terre. Les stations du DSN sont donc construites de façon à obtenir la meilleure couverture de l’espace vu de la Terre, d’où un positionnement suivant approximativement un angle de 120° visant à compenser la rotation du globe, ce qui permet d’avoir un contact quasi-permanent. La contrainte majeure est de conserver un contact ininterrompu avec un maximum d’engins spatiaux. Pour le DSN, les sites initiaux ont été choisis à Goldstone aux États-Unis, près de Madrid en Espagne et à Camberra en Australie . Que nous prenions le cas des satellites en orbite, ou des sondes d’exploration du système solaire, le problème du suivi est crucial car c’est la clef de voûte de l’exploration, mais aussi de l’utilisation de l’espace par l’Humanité.

L’exploitation de ces réseaux repose sur des capacités diverses. L’une des caractéristiques essentielles pour l’envoi d’un signal modulé repose sur la performance d’une composante de base : l’onde porteuse. Ce signal porteur de l’information est de fréquence beaucoup plus élevée que la partie utile, ceci dans le but de limiter les phénomènes d’atténuation (bruits, distance, etc.). Ces installations utilisent donc des horloges ultra-stables (MASER 6) afin d’obtenir une précision suffisante (< 1 ns), indispensable aux mesures, mais aussi utiles à la synchronisation temporelle inter-sites.

La télémétrie englobe le codage de l’ensemble des données numériques de la mission. Cela concerne les signaux vitaux à bord, mais aussi les données scientifiques, même si ces dernières peuvent être transmises des sondes vers la Terre de façon directe, ou en utilisant des relais orbitaux. Ainsi reçues, les données expérimentales sont traitées avant d’êtres redistribuées aux différents utilisateurs en vue de leur exploitation.

La navigation autonome

La notion de navigation étant désormais présentée, je vais détailler le domaine d’application de mon travail de thèse. Tout d’abord, je vais définir ce qui sous-tend à un système autonome de la façon suivante:

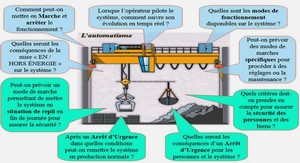

Un système spatial autonome se doit d’être un système décisionnel dont les critères fonctionnels sont basés sur ses propres données et/ou analyses provenant de capteurs embarqués. Un système autonome permet de répondre aux situations prévues ou non, via une analyse, en pondérant les divers scénarios possibles. A contrario, un système automatique effectue des opérations mécaniques en réponse à un ensemble de situations prévues par des lois de commandes, et permet à la sonde de se situer avec peu d’informations extérieures.

Dans le cas de la robotique mobile, nous greffons un certain nombre de senseurs environnementaux afin de concevoir un système de navigation automatique. Les opérations d’ingénierie permettent alors à cet ensemble complexe de prendre des décisions structurées en réponse à l’analyse de scénarios (définir un trajet, éviter des obstacles, etc.). Lorsque l’environnement perceptible est connu, la modélisation se montre efficace et de-facto les boucles de contrôle en découlent implicitement. Le challenge réside dans la possibilité de donner aux systèmes de commandes certains « degrés de liberté » de par l’élimination déterministe des cas inappropriés, ou de l’utilisation d’un auto-apprentissage, afin de converger plus rapidement vers le but à atteindre.

Une fois dépassée la phase de préparation de la mission, puisque l’autonomie que l’on cherche à apporter aux sondes n’y a pas sa place (c’est un moyen, pas un objectif), je vais décrire les possibilités permettant de garder le contact entre la Terre et son explorateur. C’est donc davantage la description de ce que l’on nomme le segment-sol qui va être présenté. Quel bénéfice tirer d’une mission autonome dans la surveillance de cette dernière d’un point de vue terrestre ? L’exploration du système solaire implique des voyages de longue durée, cela apporte des contraintes liées aux besoins énergétiques importants, mais surtout des temps de communications grandissants au fur et à mesure de la mission, et des débits de données diminuant de par l’affaiblissement des puissances électromagnétiques, pour les échanges avec le segment-sol. D’un point de vue des systèmes à bord, un satellite dispose d’un dispositif de contrôle d’attitude et d’orbite (SCAO), ou dans les documents anglophones Attitude Determination and Control Subsystem (ADCS), complet

ou partiel (à minima pour la restitution d’attitude). Ce système central est généralement composé de détecteurs optiques (visée stellaire, terrestre, solaire,…), auxquels s’ajoutent des détecteurs inertiels (gyromètres, magnétomètres, accéléromètres,…). Le contrôle d’attitude permet le maintien de l’orientation du mobile ainsi contrôlé. Le rôle tenu par la composante « navigation » est de connaître la position et la vitesse dans le système de référence équivalent aux données restituées par la détermination d’attitude, sans accès à d’autres composantes que celles embarquées. La détermination de la position et de la vitesse requiert une correction du temps local (à bord de la sonde), et relatif (Terre, Soleil), souvent à l’aide d’une horloge atomique, elle aussi embarquée. Le repère général suit les spécifications standard du système de coordonnées, tel que l’Inertial Celestial Reference System (ICRF) par exemple.

La caméra de navigation

Il est fréquent de trouver le terme de navcam (navigation camera) utilisé pour désigner le groupe système, ou parfois opnav (optical navigation) pour décrire la méthode de navigation par vision. Dans le cadre des travaux sur la robotique mobile à l’IRSEEM, ou la réduction astrométrique d’images à l’IMCCE, la connaissance de la chaîne d’acquisition est capitale. Dans tous les cas nous projetons une scène réelle sur un plan caméra. Les paramètres de la caméra doivent donc être connus afin de rendre possible un étalonnage correct.

Un système d’imagerie complet permet l’utilisation des planètes et des astéroïdes, non seulement pour l’observation, mais aussi, et c’est le but, pour la navigation. L’acquisition d’une succession d’images sur un intervalle de temps donné permet d’obtenir un modèle dynamique des mouvements relatifs.

En connaissant l’attitude et le temps, le facteur d’échelle de l’image permet, grâce aux données des éphémérides, de calculer les coordonnées observées des objets dans l’image. La problématique de mesure directe repose sur les fondamentaux de géométrie analytique de l’optique . De plus, pour arriver à cette mesure il est nécessaire d’effectuer quelques traitements sur l’image numérique acquise.

Simulation de la chaîne d’acquisition

Une approche numérique permet de conceptualiser les images qui seront acquises à bord d’une sonde d’exploration . Ces images sont importantes puisqu’elles servent à la fois pour la détermination de l’attitude, mais dans mon cas également pour la localisation. Ce sont là deux parties distinctes, la première concerne les algorithmes des viseurs stellaires, que je ne vais pas détailler ici car je considère que la sonde a toujours connaissance de ce paramètre, la technologie existant depuis plusieurs décennies. Généralement, les viseurs stellaires retournent l’attitude sous la forme de quaternions, ou d’angles d’Euler . La seconde, bien que commune, concerne l’ensemble du processus de restitution d’attitude et de positionnement. Ceci n’est possible qu’à la condition d’avoir les paramètres de la caméra . Bien entendu, la sensibilité spectrale permet de calculer la magnitude limite des objets spécifiques, et de quantifier leur niveau de détection. Cette capacité dépend du champ de vue, lui même soumis aux paramètres optiques que sont la distance focale et le diamètre de la pupille d’entrée. Nous voyons que de nombreuses données sont imbriquées et changent fondamentalement les données de sortie. Quelques missions passées ont montré que si les données sortantes sont trop éloignées des prévisions, le résultat pour la mission peut être catastrophique. Les algorithmes de navigation autonome doivent absolument pouvoir fonctionner avec le signal obtenu in-situ, au risque de ne plus correspondre à la réalité terrain. C’est pourquoi un modèle basique de la chaîne d’acquisition, prenant en compte la taille des pixels, le champ de vue, la réponse du CCD, etc. , a dû être développé. La problématique liée aux astéroïdes est un peu différente du fait de leur changement de magnitude au cours des observations.

Table des matières

1 L’exploration spatiale

1.1 Rappels historiques

1.2 La navigation spatiale

1.2.1 Les systèmes inertiels

1.2.2 Les systèmes de coordonnées

1.2.3 Les échelles de temps

1.2.4 Le positionnement absolu

1.2.5 Le positionnement relatif

1.2.6 Le problème de la trajectographie

1.3 Le guidage et le suivi des missions d’exploration spatiale

1.3.1 Les agences et le processus de gestion des missions

1.3.2 Les problématiques au sol

1.4 La navigation autonome

1.4.1 Un demi-siècle d’exploration cybernétique

1.4.2 Les méthodes de navigation autonome

1.4.3 Approche système

1.4.4 Approche fonctionnelle

2 Les outils de navigation

2.1 Localisation spatiale

2.1.1 La navigation céleste

2.1.2 Les catalogues d’étoiles

2.1.3 Les catalogues d’astéroïdes

2.2 La caméra de navigation

2.2.1 Modélisation de la caméra

2.3 Traitement d’image

2.3.1 Modèle astrométrique

2.3.2 Corrections géométriques des images

2.4 Modèle cinématique de la sonde

2.4.1 Équations aux dérivées partielles

3 Les méthodes de positionnement

3.1 Simulation de la chaîne d’acquisition

3.2 La cartographie stellaire

3.3 La localisation avec des objets mobiles

3.3.1 Les astéroïdes

3.3.2 La cartographie d’astéroïdes

3.4 Modélisation de la phase voyage

3.4.1 Une trajectoire interplanétaire

3.4.2 Construction du modèle simplifié

3.4.3 Ajustement aux observations

3.4.4 Trilatération

3.5 Approche probabiliste

3.5.1 Les filtres bayésiens

3.5.2 Le filtrage particulaire

3.6 Mise en œuvre du filtre

4 La confrontation théorie & vérité terrain

4.1 Les images de la NAVCAM Rosetta

4.2 Détection sur images réelles

4.2.1 Utilisation de l’Observatoire Virtuel (OV)

4.3 Estimation de la position de la sonde

4.3.1 Calcul avec les données images

4.3.2 Interprétation des mesures

4.4 Résultats

4.4.1 Mise en œuvre du logiciel astronomique de positionnement

4.4.2 Liens avec les applications terrestres

4.4.3 Bilan de l’application à Rosetta

Conclusion et perspectives

A Annexes

A.1 Les missions de références

A.1.1 La mission Gaia

A.1.2 La mission Rosetta

A.2 Éléments orbitaux

B Documents divers

B.1 Photos d’illustrations personnelles

B.2 Références en ligne

Acronymes & abréviations

Bibliographie