INDEXATION SEMI-AUTOMATIQUE, UNE APPROCHE SYMBOLIQUE DE CLASSIFICATION DE TEXTES

Introduction

Face aux défis rencontrés en recherche d’informations pour apparier au mieux les requêtes des utilisateurs aux documents d’une collection, l’utilisation d’un ensemble fermé de clés constitue une solution permettant de faire un pas de plus, par rapport aux simples mots-clés, sur la route de la recherche sémantique. Par ce terme, nous entendons qu’il y a un passage d’un mode de recherche basé sur des éléments lexicaux, mots simples ou expressions composées, à une recherche qui s’effectue dans l’espace des concepts, c’est-à-dire en tenant compte du sens de ces mots et expressions. Les clés définies dans un cadre particulier comportent en effet l’avantage de faire référence à des sens bien précis pour les mots ou expressions qui seraient ambigus autrement1 . La désambiguïsation du lexique est assurée à la fois par le contexte d’utilisation (par exemple une entreprise minière) et par la définition même de la ressource terminologique2 . L’organisation des clés peut être réalisée sous différentes formes (Section 1.4.1). Celles-ci font souvent intervenir un lien hiérarchique apte à caractériser et désambiguïser le sens de deux formes homographes. L’indexation des documents est souvent réalisée par des documentalistes experts du domaine, ce qui garantit un traitement de bonne qualité, mais n’est pas sans poser certains problèmes relatifs au coût et à la cohérence à long terme. Le traitement de volumes de données importants est aussi un point critique pour cette méthode dont le passage à une grande échelle (scalability) représente un obstacle. Nous proposons une méthode dont la vocation est d’être utilisée de manière semi-automatique, c’est-à-dire comme une aide au codage. Son but est d’améliorer l’efficacité et l’homogénéité de l’indexation manuelle en suggérant au documentaliste une liste de catégories, ou de mots-clés potentiels, automatiquement construite. La méthode que nous décrivons adopte une approche dite symbolique, par opposition aux méthodes statistiques. Ces dernières, basées sur un apprentissage artificiel, nécessitent de grandes quantités de 1 Citons à nouveau l’exemple du mot « carotte », qui a deux sens différents selon que l’on se situe dans un contexte géologique ou végétal. 2 Le sens donné au mot terminologie est ici celui qui désigne une ressource, telle que celles exposées à la section 1.4.1, qui reprennent un ensemble de termes relatifs à un ou plusieurs domaines, activités, etc.

Indexation semi-automatique, une approche symbolique de classification de textes données annotées

Cela peut représenter un effort important et poser des problèmes lorsque peu de données d’entraînement sont disponibles, par exemple pour certains codes spécifiques et rares. De son côté, si l’approche symbolique donne souvent de bons résultats et est appréciée pour la précision qu’elle apporte, elle présente aussi l’inconvénient de la quantité de travail nécessaire à l’élaboration de ressources ad-hoc. La méthode utilisée ici vise à réduire autant que faire se peut cette quantité de travail en automatisant une partie de la construction des ressources. En ce qui concerne les approches symboliques, il en existe une grande variété, qui font intervenir différents types d’analyses linguistiques. Une méthode peut se contenter d’exploiter de larges ressources (dictionnaires, thésaurus, ontologies, etc.) ou au contraire tenter de plonger plus profondément dans la structure du texte, en mettant par exemple en œuvre une analyse syntaxique. Notre système repose à la fois sur l’exploitation d’une ressource de base, en l’occurrence un thésaurus, et sur une analyse locale qui fait intervenir différentes techniques de traitement automatique du langage.

Principes et hypothèses

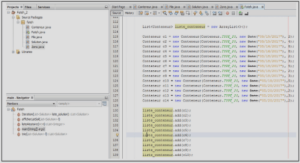

L’approche adoptée est centrée sur l’utilisation d’une ressource de base qui définit les catégories, par exemple une terminologie telle que celles présentées à la section 1.4.1. Cette ressource constitue le point de départ de la génération automatique d’automates de reconnaissance, ou plus précisément de transducteurs. Ceux-ci permettent d’exprimer des motifs lexicaux qui peuvent faire appel à des dictionnaires électroniques, poser des contraintes sur les catégories grammaticales ou sur la morphologie des mots, et ainsi atteindre une assez grande complexité. L’application des transducteurs à un texte a pour résultat d’extraire un nombre limité d’expressions pertinentes. La reconnaissance de chacune de celles-ci provoque la génération d’un code de catégorie associé. L’analyse des termes extraits et de leurs codes permet finalement la classification du document. Nous avons appelé cette méthode motifs lexicaux étendus (MLE). L’intervention humaine dans le processus d’indexation se résume alors à la consultation sommaire du document – le titre, le résumé, éventuellement le premier paragraphe, ou encore tout autre partie du document jugée importante – et à la sélection d’une ou plusieurs catégories dans la liste proposée, et non plus dans la terminologie complète. Afin de préserver le gain de temps obtenu par cette analyse automatique, il est évidemment très important que le documentaliste n’ait à consulter ni le texte en entier, ni la terminologie pour confirmer le choix des catégories. Par conséquent, la liste doit contenir un maximum de mots clés plausibles, quitte à y inclure certaines propositions qui ne seront finalement pas sélectionnées. En ce sens, nous essayons de maximiser le rappel, et ce, dans une certaine mesure, au détriment de la précision. L’appartenance d’un texte à une catégorie thématique se matérialise souvent, au niveau du document, par l’utilisation d’un certain nombre de mots et d’expressions spécifiques. Cette idée, que l’on retrouve par exemple dans le cas d’un sous-langage, avec l’utilisation spécifique de la langue dans un certain contexte (Kittredge et Lehrberger [1982]), est ici transposée aux catégories thématiques, c’est-à-dire à l’échelle des concepts. Dès lors, une ressource terminologique adéquate – c’est-à-dire 2.2 État de l’art 55 qui couvre réellement le champ thématique du type de corpus destiné à être indexé, en tenant compte un maximum de la richesse lexicale3 – s’apparente à un ensemble de définitions relatives à chaque concept. Il est alors possible de trouver une intersection suffisante entre le vocabulaire du document et cette ressource pour décider automatiquement de l’attribution des catégories. La prise en compte des expressions composées est également un principe important. En effet, on peut constater que celles-ci véhiculent généralement un sens très précis et constituent dès lors de bons candidats en tant que concept descripteur d’un document. Par exemple, en français, le terme « allocations » est parfois utilisé seul, mais il est aussi très souvent rencontré dans des formes composées telles que « allocations de chômage » ou « allocations familiale », qui proposent des sens bien plus précis. Le corollaire de cette constatation est que les expressions composées sont souvent moins polysémiques, comme l’a montré Yarowsky [1993]. L’intégration de ces unités polylexicales permet de dépasser une première limitation induite par l’utilisation de mots-clés simples. La méthode s’applique sur l’ensemble du texte, mais certaines parties peuvent être privilégiées. C’est le cas du titre qui, pour de nombreux documents, se révèle particulièrement informatif. Ce principe est également souligné par la norme AFNOR Z 47-102 (AFNOR [1993]) et est bien connue dans le milieu du journalisme au travers de la notion de chapeau. Après un état de l’art (Section 2.2), les parties suivantes (Sections 2.3 et 2.4) présentent en détail la méthode semi-automatique développée. Celle-ci propose d’améliorer la rapidité et la cohérence par rapport à l’indexation strictement manuelle grâce à l’analyse automatique. Ce gain est obtenu tout en conservant une précision élevée, garantie par la validation humaine. L’approche, sans apprentissage, ne nécessite pas de données annotées manuellement4 et est donc fonctionnelle dès le premier document. L’analyse des textes est basée sur des principes simples et performants qui font usage d’une ressource lexicale et sémantique telle qu’un thésaurus.

État de l’art

L’attribution à un document de clés d’indexation issues d’un vocabulaire contrôlé est comparable au processus de classification de textes. Ce domaine est largement couvert par les techniques d’apprentissage artificiel. Bien que notre méthode n’en fasse pas partie, nous allons brièvement les présenter afin de pouvoir nous situer par rapport à ces travaux. 2.2.1 Apprentissage artificiel La classification de textes peut être divisée en deux activités distinctes : le clustering et la catégorisation. Le clustering regroupe les documents en ensembles de textes similaires sur la seule base des documents. La catégorisation s’appuie par contre sur la définition a priori des catégories à attribuer. 3 Pour un thésaurus, il serait par exemple souhaitable d’avoir, en plus d’un terme descripteur principal, autant de nondescripteurs qu’il existe de synonymes. Il s’agit évidemment là de la situation idéale espérée, et non d’une condition nécessaire à l’application de la méthode. 4 C’est-à-dire pas de corpus d’apprentissage. Le clustering et la catégorisation sont aussi qualifiés respectivement de classification non supervisée et supervisée. Notre système s’apparente à la classification supervisée que nous appellerons désormais indifféremment classification ou catégorisation5 . Dans notre cas, le résultat attendu est une liste de catégories accompagnées de poids, ce qui est généralement qualifié de classification soft6 et multi labels7 . Comme nous l’avons déjà mentionné, la recherche d’informations, et plus particulièrement la classification automatique, est un domaine dans lequel les techniques d’apprentissage artificiel sont souvent appliquées. Les documents traités sont représentés au moyen d’un ensemble de caractéristiques définies au préalable. Par exemple, celles-ci peuvent être constituées de l’ensemble des termes simples du texte. Le document est alors caractérisé au travers de son lexique. Les techniques d’apprentissage artificiel visent à acquérir automatiquement pour chaque classe, sur la base d’une collection de documents annotés, des valeurs pour ces caractéristiques. Différents modèles de représentation des caractéristiques existent, dont les principaux sont les modèles booléens, probabilistes ou encore vectoriels. Ceux-ci sont abordés de manière très brève ci-dessous8 9 . Les modèles booléens prennent simplement en compte la présence ou l’absence des caractéristiques. Il s’agit de comparer, pour chaque classe, les valeurs prototypiques de l’ensemble des caractéristiques avec celles obtenues pour tout nouveau document. Pour qu’une classe soit attribuée à un document, la correspondance de leurs représentations doit être exacte.