Générateur de formes fléchies pour la langue Malgache

Traitement Automatique du langage naturel

”On regroupe sous le vocable de traitement automatique du langage naturel (TALN), l’ensemble des recherches et développements visant à modéliser et reproduire, à l’aide des machines, la capacité humaine à produire et à comprendre des énoncés linguistiques dans des buts de communication.”[25] propose Fran¸cois Yvon, un chercheur au Limsi/CNRS. Marcel Cori, professeur de traitement automatique des langues à l’Université Paris X. définit ce domaine comme : ”Le TAL est l’ensemble des méthodes et des programmes qui permettent un traitement par l’ordinateur des données langagi`eres, mais quand ce traitement tient compte des spécificités du langage humain. Il y a des traitements de données langagi`eres (écritures sur fichiers, sauvegardes ou autres) qui ne font pas partie du traitement automatique des langues.”[5] Ainsi, le traitement automatique des langages naturels regroupe les méthodes visant le traitement automatique des énoncés sous forme de langue naturelle, par opposition aux langages formels de la logique Mathématiques. Ces énoncés peuvent ˆetre sous différents supports, que ce soit écrits ou orals. Une des motivations du TAL, est de pouvoir offrir une interface plus aisée entre homme et machine. Des chercheurs comme Piet Mertens ont eu recours à ce domaine pour la transcription de la prosodie, mais certains l’utilisent aussi pour les recherches et les corrections automatiques des langues, l’extraction des mots clefs ou mˆeme la sémantique d’un texte.

Langues flexionnelles et agglutinantes

Wikipédia se propose de donner ses définitions de la langue flexionnelle et agglutinante. ”Une langue flexionnelle est, en typologie morphologique, une langue dans laquelle les mots (lemmes) changent de forme selon leur rapport grammatical aux autres mots, dans une phrase”[22]. ”Une langue agglutinante est, en typologie morphologique, une langue dont les traits grammaticaux sont marqués par l’assemblage d’éléments basiques ou morph`emes, chaque 9 morph`eme correspondant à un trait et chaque trait étant noté par un morph`eme (dont la forme est quasiment invariable)”. [21] La langue Malgache est considérée comme une langue agglutinante, car en effet les dérivations d’un radical est fait à partir de l’ajout d’éléments basiques tels que les ”tovana”, ”tovona”, ”tsofoka”, et à partir de cela on a toutes les dérivations d’un mot.

Quelques autres logiciels de traitement de texte

INTEX Intex est un outil de traitement de texte se basant sur des transducteurs à état fini. Intex a été disponible depuis 1992 mais a commencé à avoir une interface graphique à partir de 1996. Elle a déjà été utilisée dans plusieurs travaux. Citons ici quelques exemples. • Dans son article ”de l’analyse traditionnelle à l’analyse Informatique”[26], Katia Zellangui décrit l’élaboration et l’amélioration du syst`eme d’étiquetage automatique, nécessaires aux traitements informatiques de bases textuelles. • En terminologie, Ibekwe-Sanjuan Fidelia, dans son article ”Extraction terminologique avec Intex”[8], montre un travail dans le but d’automatiser l’extraction terminologique avec Intex. • En analyse morphosyntaxique, Anne Dister, dans son article ”Réflexions sur l’homographie et la désambigu¨ısion des formes les plus fréquentes”[7], montre un travail qui enl`eve les ambigu¨ıtés morphologiques lors de l’étiquetage morphosyntaxique d’un texte. Intex fonctionne en appliquant des transducteurs à état fini aux textes, et en rempla¸cant les mots simples ou composés par des tags, c’est à dire le résultat du mot apr`es avoir été l’entrée d’un transducteur à état fini. M Silberztein, dans ”Analyse automatique de corpus avec Intex” mentionne que : ”Les transducteurs à état fini sont représentés dans Unitex par des graphes, en général construits et édités avec l’éditeur de graphe d’Intex. Fondamentalement, la partie entrée dans un transducteur est utilisée pour identifier des séquences, la partie production, pour effectuer des substitutions dans le texte”

FLEMM

Flemm est un lemmatiseur, un lemme est ici la forme que peut prendre un mot, selon le genre, le nombre, leur mode ou autre. Pour un verbe, par exemple, sa lemmatisation consiste à trouver son infinitif, et pour les autres mots, cela revient à trouver le mot au masculin singulier, on appelle cela les formes canoniques des mots. 10 Ammetta NAMER a utilisé cet analyseur pour la recherche d’informations. Dans son article ” un analyseur flexionnel du fran¸cais à base de r`egles ”, elle a montré l’efficacité de l’utilisation de FLEMM, la lemmatisation, dans le but d’améliorer les résultats des recherches lors d’une RI pour le fran¸cais. Elle y décrit les étapes principales d’une lemmatisation, qui sont : • décomposition du mot selon la terminaison la plus vraisemblable • mise en relation de la base obtenue avec sa forme citationnelle par une r`egle de réduction d’allomorphes • le cas échéant, calcul de la désinence de l’infinitif

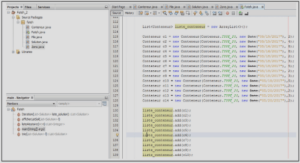

NOOJ

Contrairement à Unitex, NOOJ n’est pas un logiciel libre, elle fait partie de la classe des gratuiciels. Ce sont des logiciels qui sont distribués gratuitement, mais qui sont propriétaires. Il a été construit par Max Silberztein pendant des recherches avec Maurice Gross, un linguiste fran¸cais. Nooj peut reconnaˆıtre plusieurs types d’unité linguistique ; • les mots simples • les mots composés • les préfixes et suffixes • les expressions discontinues Il poss`ede différents niveaux de parseurs : • les parseurs orthographiques • les parseurs lexicales • les parseurs morphologiques • les parseurs syntaxiques et sémantiques Le mode de fonctionnement de Nooj pour reconnaˆıtre les unités lexicales est d’associer à ses unités lexicales des annotations à chaque niveau de parseur. Ces annotations sont stockées dans le TAS ou Text’s Annotation Structure.

Travaux réalisés

Nous pouvons dire que le domaine du NLP exploite pleinement les études dans le domaine de l’Informatique et il a déjà eu plusieurs applications.

Transcription automatique de la prosodie

Dans ”Un outil pour la transcription de la prosodie dans les corpus oraux”[15], Piet Mertens remarque que : ”Toute recherche linguistique sur l’intonation repose sur un travail descriptif qui passe inévitablement par la transcription prosodique d’énoncés ou, de préférence, d’un corpus de parole de taille appréciable.”. Cependant, la transcription de l’intonation coˆute ch`ere en temps et nécessite des compétences spécialisées, et de plus devient parfois subjective par rapport aux spécialistes. De la vient l’idée de créer un outil pour la transcription automatique de la prosodie. Le programme prend en entrée un fichier son et en sortie une transcription de celui-ci. L’outil a d’abord été testé pour transcrire un corpus parlé, faisant intervenir dix locuteurs, et donne des résultats robustes avec des similarités avec la transcription manuelle.

NLP et Médecine

Dans le monde de la médecine, on a aussi parfois recours au NLP, d’o`u l’existence du consortium comme l’OHNLP ou Open Health Natural Language Processing. Elle intervient notamment pour l’analyse de corpus médicaux dans le but d’améliorer les standards à adopter. Le site officiel de OHNLP mentionne certaines applications de la NLP dans la médecine, telles que : • la bio-surveillance : pour prévenir les nouvelles infections ou le bioterrorisme, Wendy W. Chapman dans ”Natural Language Processing for Biosurveillance”[2] explique justement que la plupart des documents utilisés pour la bio-surveillance sont sous forme de texte, d’o`u la nécessité de traitement. • le traitement personnalisé : ceci peut se faire grˆace à l’historique médical d’un patient.

Interface homme machine

Le clavier est encore actuellement tr`es utilisé en ce qui concerne les interfaces hommemachine. Cependant, grˆace à la TAL, et aux évolutions technologiques, une nouvelle fa¸con de communiquer avec la machine a été étudiée, par l’intermédiaire de la reconnaissance vocale. • Dans l’article ”Aide à la communication pour personnes handicapées et prédiction de texte”[11] Jean-Yves Antoine et Denis Maurel parlent, comme le titre l’indique, des études dans l’Informatique linguistique pour l’aide à la communication des personnes handicapées. De mˆeme, ils énoncent aussi des études dans le but d’aider les personnes souffrant de handicap des membres antérieurs langages formels à la saisie de texte, mais aussi sur la compensation d’une modalité défaillante pour la synth`ese vocale à partir de texte.

1 Contexte du stage |