Etude et évaluation de la qualité de service d’un streaming vidéo dans un réseau ad hoc (égale à égale)

Vidéo numérique

La vidéo numérique est une représentation d’une scène visuelle, naturelle ou réelle, échantillonnée spatialement et temporellement. Une scène est typiquement échantillonnée à un moment donné pour produire une image, qui représente la scène visuelle complète à ce moment précis, ou un champ, qui consiste typiquement en des lignes d’échantillons spatiaux impaires ou pairs. L’échantillonnage est répété à intervalles réguliers (intervalles de 1/25 ou 1/30 seconde, par exemple) pour produire un signal vidéo en mouvement. Trois composants ou ensembles d’échantillons sont généralement requis pour représenter une scène en couleur. Les formats les plus répandus pour représenter la vidéo sous forme numérique comprennent la norme ITU-R

Scènes vidéo naturelles

Une scène vidéo est généralement composée de plusieurs objets ayant chacun leur propre forme, profondeur, texture et illumination. La couleur et la luminosité d’une scène vidéo naturelle changent avec des degrés variables de douceur tout au long de la scène, c’est-à-dire qu’elle a un ton continu. Les caractéristiques d’une scène vidéo typique (Figure I.5) qui sont pertinentes pour le traitement et la compression vidéo incluent des caractéristiques spatiales telles que la variation de texture dans la scène, le nombre et la forme des objets, la couleur et autres caractéristiques temporelles et le mouvement de la caméra ou du point de vue [31] ][33]. Figure I.5 Image fixe d’une scène vidéo.

Capture

Une scène visuelle est continue dans l’espace et le temps. La représentation d’une scène visuelle sous forme numérique consiste à échantillonner la scène réelle spatialement, habituellement sur une grille rectangulaire dans le plan image/vidéo, et temporellement, sous la forme d’une série d’images fixes ou composantes d’images échantillonnées à intervalles réguliers (Figure I.6). La vidéo numérique est la représentation d’une scène vidéo échantillonnée sous forme numérique. Chaque échantillon spatio-temporel, un élément d’image ou un pixel, est représenté par un ou plusieurs nombres qui décrivent la luminosité ou la luminance et la couleur de l’échantillon. Pour obtenir une image échantillonnée en 2D, une caméra focalise une projection en 2-D de la scène vidéo sur un capteur, tel qu’une matrice de dispositifs à couplage de charge (CCD). Dans le cas de la capture d’images couleur, chaque composant de couleur est filtré séparément et projeté sur une matrice CCD [30]. Figure I.6 Échantillonnage spatial et temporel d’une séquence vidéo.

Échantillonnage spatial

La sortie d’une matrice CCD est un signal vidéo analogique, un signal électrique variable qui représente une image vidéo. L’échantillonnage du signal à un moment donné produit une image échantillonnée ou une image qui a des valeurs définies à un ensemble de points d’échantillonnage. Le format le plus courant pour une image échantillonnée est un rectangle avec les points d’échantillonnage positionnés sur une grille carrée ou rectangulaire. L’échantillonnage a lieu à chacun des points d’intersection sur la grille et l’image échantillonnée peut être reconstruit en représentant chaque échantillon comme un élément d’image carré ou un pixel. Le nombre de points d’échantillonnage influence la qualité visuelle de l’image.

Échantillonnage temporel

Une image vidéo en mouvement est formée en prenant un « instantané » rectangulaire du signal à des intervalles de temps périodiques. La lecture de la série d’instantanés ou d’images produit l’apparence d’un mouvement. Un taux d’échantillonnage temporel supérieur ou un taux de trame donne un mouvement apparemment plus fluide dans la scène vidéo, mais nécessite plus d’échantillons à capturer et à stocker. Des fréquences de la vidéo inférieures à 10 images par seconde peuvent être utilisées pour des communications vidéo à très faible débit binaire, car la quantité de données est relativement faible, mais le mouvement est clairement saccadé et non naturel à ce débit. Entre 10 et 20 images par seconde est plus typique pour les communications vidéo à faible débit binaire; l’image est plus lisse mais un mouvement saccadé peut être visible dans les parties de la séquence qui se déplacent rapidement. L’échantillonnage temporel à 25 ou 30 images complètes par seconde est la norme pour les images de télévision en définitions standard (Standard Definition SD), avec entrelacement pour améliorer l’apparence du mouvement, En outre; 50 ou 60 images par seconde produit un mouvement apparent très lisse au détriment d’un débit de données très élevé. Un signal vidéo peut être échantillonné sous la forme d’une série de trames complètes, d’un échantillonnage progressif ou d’une séquence de trames, d’un échantillonnage entrelacé. I.5 Vidéo entrelacée Lorsque vous regardez votre télévision, votre oeil regarde en réalité des demi-images que l’on appelle des trames. L’écran affiche par exemple 50 trames par seconde dont l’une est composée de lignes paires et la suivante de lignes impaires. Lorsque ces trames s’entrelacent elles créent une image pleine. Ce système appelé « entrelacement », chacun représentant la moitié des informations dans une trame vidéo complète (destinée à doubler le nombre d’images perçues par seconde sans augmenter le débit). Par exemple l’abréviation 50i désigne un balayage entrelacé de 50 trames par seconde (i pour interlaced en anglais) [37]. Figure I.7 Séquence vidéo entrelacée. Chapitre I La compression de la vidéo – 16 – I.6 Vidéo progressif Le mode progressif ajoute la précision de la vidéo puisque chaque image s’affiche d’un coup avec toutes ses lignes. En progressif, l’image est alors moins fluide. Pour mentionner le mode progressif, les spécialistes ajoutent la lettre « p » après le nombre de lignes ou d’images par seconde L’avantage de la méthode d’échantillonnage entrelacée est qu’il est possible d’envoyer deux fois plus de champs par seconde que le nombre de trames dans une séquence vidéo progressif équivalente avec le même débit. Ceci donne l’impression d’un mouvement plus fluide. De plus en plus, le contenu vidéo peut être capturé et / ou affiché dans un format progressif. Lorsque la vidéo est capturée dans un format (par exemple entrelacé) et affichée dans une autre (par exemple progressive), il est nécessaire de convertir entre les formats [33]. (a) (b) (c) Figure I.8 (a) Lignes paires, (b) Lignes impaire, (c)Une image pleine I.7 Les formats vidéo [39] [40] Il y a plusieurs types de résolutions vidéo: CIF (Common Intermediate Format) : également connu sous le nom FCIF (Full Common Intermediate Format), est un format utilisé pour normaliser les résolutions horizontales et verticales en pixels de séquences Y Cr Cb dans les signaux vidéo, couramment utilisés dans les systèmes de téléconférence vidéo et les services audiovisuels. Il est le format de base du codage des normes H.261 et H.263. CIF définit une séquence vidéo avec une résolution de 352 × 288, un frame rate de 30000/1001 (environ 29,97) comme NTSC, avec une couleur encodée en utilisant Y Cr Cb 4: 2: 0. SIF (Source Intermediate Format) : SIF est pratiquement identique à CIF, mais pris de MPEG-1 plutôt que des normes ITU. SIF sur les systèmes à base de 525 lignes (NTSC) est de 352 × 240 et sur les systèmes à 625 lignes (PAL), il est identique à CIF (352 × 288). QCIF (Quarter CIF) : Pour avoir un quart de la superficie, comme l’indique le «quart», la hauteur et la largeur de la trame sont divisées par deux. Les termes également utilisés sont SQCIF (Sub Quarter CIF, parfois subQCIF), 4CIF (4 × CIF) et 16CIF (16 × CIF). Les résolutions de la luminance et la chrominance pour tous ces formats sont résumées dans le tableau ci-dessous. Format de l’image Résolution de la luminance (horiz x vert) Résolution de la chrominance (horiz x vert) Sub-QCIF 128 × 96 64 × 48 QCIF 176 × 144 88 × 72 CIF 352 × 288 176 × 144 4CIF 704 × 576 352 × 288 16CIF 1408 × 1152 704 × 576 Tableau I.2 Les formats vidéo L’image en télévision est formée par un certain nombre de pixels, de forme carrée. La définition correspond au nombre de pixels horizontaux et verticaux qui forment l’image : SD: la définition standard de 720 × 576 pixels, c’est celle que proposent les DVD 720p : un format intermédiaire faisant partie intégrante de la HD (Haute Définition), avec ses 1280 × 720 pixels. Il reste toujours employé par les prestations de vidéo à la demande (Video on Demand VoD) du fait de ses besoins en bandes passantes moins importants. Full HD : avec ses 1920 × 1080 pixels, c’est l’autre définition de la HD. La vrai, la pleine la totale, celle que propose tout les téléviseurs actuels. C’est également la définition employée par le Blu-ray, successeur du DVD qui remplacé l’autre format HD : le HD-DVD [40]. Quad HD – Ultra HD : 3840 × 2160 pixels, souvent faussement appelé 4K parce que celui-ci est un format cinéma de 1 920 × 1 080 pixels. Le terme Quad HD est le plus juste puisque cette définition fournit effectivement quatre fois plus de pixels que le Full HD. Mais actuellement il faut employer le terme Ultra HD. 8K : cette définition offre en tout cas 16 fois plus de points que Full HD, et quatre fois plus que l’Ultra HD. Le 8K, deux fois plus de lignes verticales et horizontales que l’Ultra HD, et donc quatre fois plus de lignes que Full HD. C’est quatre fois plus de pixels que l’Ultra HD, et 16 fois plus que Full HD [40]. Chapitre I La compression de la vidéo – 18 – Figure I.9 Représentation proportionnelle de toutes les définitions

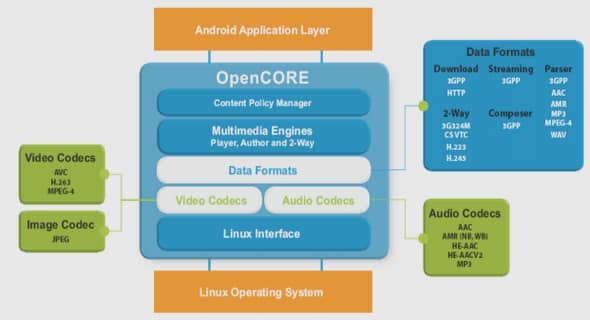

La compression vidéo

Le codage vidéo (codage source) est le processus de compression et de décompression d’un signal vidéo numérique. Le codeur (un compresseur) convertit les données source en une forme comprimée occupant un nombre réduit de bits, avant la transmission ou le stockage, et le décodeur (un décompresseur) convertit la forme compressée en une représentation des données vidéo originales. Le pair encodeur / décodeur est souvent décrite comme un CODEC (enCOder / DECoder) Figure I.10 Encodeur / Décodeur Standards de compression vidéo : fournis par : ISO International Organization for Standardization. ITU International Telecommunication Union. JVT Joint Video Team (H.264/MPEG-4-AVC en 2003). JCT-VC Joint Collaborative Team on Video Coding : pour développement de HEVC codec.

Chapitre I: La compression de la Vidéo |