ETAT DE L’ART

Introduction sur les Big Data

L’explosion quantitative des données numériques a obligé les chercheurs à trouver de nouvelles manières de voir et d’analyser le monde. Il s’agit de découvrir de nouveaux ordres de grandeur concernant la capture, la recherche, le partage, le stockage, l’analyse et la présentation des données.

Littéralement, ces termes signifient Big Data, méga données, grosses données ou encore données massives.

Big Data est maintenant présentée par de nombreux articles comme une nouvelle révolution industrielle semblable à la découverte de la vapeur (début du 19e siècle), de l’électricité (fin du 19e siècle) et de l’informatique (fin du 20e siècle). D’autres, un peu plus mesurés, qualifient ce phénomène comme étant la dernière étape de la troisième révolution industrielle, laquelle est en fait celle de « l’information ».

Dans un système Big Data, il n’y a pas de schéma explicite de la donnée, la donnée n’est pas structurée. L’objectif est de stocker l’intégralité de la donnée brute, sans transformation et sans choix car on ne sait pas à l’avance ce que l’on va en faire.

Dans tous les cas, le Big Data est considéré comme une source de bouleversement profond de la société. Le but de chapitre est d’appréhender la notion Big Data.

Concept Big Data

L’expression « Big Data » date de 1997 selon l’Association for Computing Machinery. En 2001, l’analyste du cabinet Meta Group (devenu Gartner) Doug Laney décrivait les Big Data d’après le principe des « trois V » à savoir [1.01]:

● le Volume de données de plus en plus massif ;

● la Variété de ces données qui peuvent être brutes, non structurées ou semi structurées ;

● la Vélocité qui désigne le fait que ces données sont produites, récoltées et analysées en temps réel.

Tous les experts sont d’accord que la lettre V caractérise le Big Data. Cependant, certains n’est pas d’accord sur le « trois V » de base mais ajoute d’autres V selon le type d’entreprises.

Les 3 V de base

Volume

Le volume décrit la quantité de données générées par des entreprises ou des personnes. Dans les systèmes d’information en place dans les entreprises, les volumes de données traités se mesurent en téraoctets, voire en pétaoctets (1 pétaoctet = 1000 téraoctets = 1 million de gigaoctets =10¹⁵ octets).

Les entreprises sont submergées de volumes de données croissants de tous types. 90% des données dans le monde ont été créées au cours des deux dernières années. Et 2,5 trillions d’octets de données sont générés chaque jour. Ces données proviennent de partout : de capteurs utilisés pour collecter les informations climatiques, de messages sur les sites de médias sociaux, d’images numériques et de vidéos publiées en ligne, d’enregistrements transactionnels d’achats en ligne et de signaux GPS de téléphones mobiles, etc.

Les données numériques créées dans le monde seraient passées de 1,2 zettaoctets (1 zetaoctet =10²¹ octets) par an en 2010 à 1,8 zettaoctets en 2011, puis 2,8 zettaoctets en 2012 et s’élèveront à 40 zettaoctets en 2020.

En janvier 2013, Facebook générait 10 téraoctets de données chaque jour et twitter 7 teraoctets [1.02].

Le volume de données traité est considéré comme le premier critère pour qu’un ensemble de données relève du Big Data. Pourtant, ce premier V est le moins opérant et le plus variable en fonction du secteur et de l’organisation concernés.

Variété

Texte, images, photos, vidéos, quel que soit le format de l’information, les données, structurées ou non structurées, requièrent un nouveau savoir-faire pour être assimilées puis analysées. La prolifération de types de données provenant de sources comme les médias sociaux, les interactions Machine to Machine et les terminaux mobiles, crée une très grande diversité au-delà des données transactionnelles traditionnelles. Les données ne s’inscrivent plus dans des structures nettes, faciles à consommer. Les nouveaux types de données incluent contenus, données géo spatiales, points de données matériels, données de géo localisation, données de connexion, données générées par des machines, données de mesures, données mobiles, points de données physiques, processus, données RFID, données issues de recherches, données de confiance, données de flux, données issues des médias sociaux, données texte et données issues du Web.

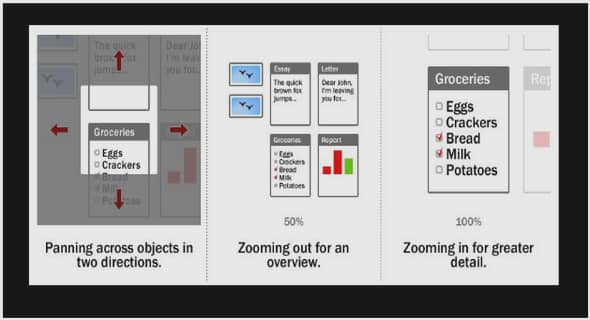

Agréger ces données pour les traiter ensemble est la première difficulté que rencontrent entreprises et organisations et souligne l’enjeu primordial de l’interopérabilité des données. En conséquence, une approche d’indexation, de recherche sémantique et de navigation intra- et inter- applications s’impose pour l’exploitation de ces nouveaux médias, sans oublier la nécessité de modélisation de phénomènes complexes.

Vélocité

La vitesse décrit la fréquence à laquelle les données sont générées, capturées et partagées. Du fait des évolutions technologiques récentes, les consommateurs mais aussi les entreprises génèrent plus de données dans des temps beaucoup plus courts. L’importance de l’immédiateté et de l’instantanéité pour recevoir ou émettre des informations par chacun d’entre nous et pour toutes les activités, professionnelles ou personnelles, du quotidien contraigne les organisations à améliorer leurs vitesses de réaction et d’anticipation. À ce niveau de vitesse, les entreprises ne peuvent capitaliser sur ces données que si elles sont collectées et partagées en temps réel.

INTRODUCTION |