Coopération et évaluation cognitive d’agents artificiels pour la supervision

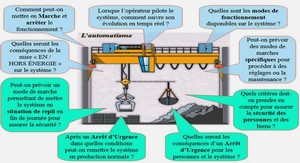

POINT DE VUE DE L’OPERATEUR ARTIFICIEL

Un système d’aide à la décision doit fournir une expertise à l’opérateur humain, mais laisser la décision finale à ce dernier. Le but est d’améliorer la qualité de la décision humaine et de réduire la charge mentale, car il a été largement prouvé qu’une charge excessive induit des erreurs de la part de l’opérateur humain . Il s’agit donc pour nous d’étudier de nouvelles façons d’utiliser les concepts existants en Intelligence Artificielle (IA) afin d’améliorer l’aide à un opérateur humain, et la conception d’IHM plus pertinentes. L’idée est de développer des opérateurs artificiels issus de l’IA et capables de résoudre des problèmes de supervision dans un “style cognitif” spécifique. Le but est de s’approcher au mieux du raisonnement humain mis en œuvre lors d’une opération de supervision de procédé afin d’améliorer l’aide et l’interaction avec l’opérateur, ainsi que l’intelligibilité et la capacité explicative du système. Ainsi, l’agent artificiel peut être vu comme une référence. Trois approches seront testées et détaillées au cours des chapitres 3 à 6. Les raisons qui ont motivé leur choix sont les suivantes : ● la modélisation qualitative causale. Etant donné qu’un humain a très souvent tendance à raisonner de manière qualitative, par opposition à un raisonnement numérique, c’est-à-dire à simplifier une réalité physique complexe en appliquant des règles de sens commun, il paraît utile de modéliser ce type de raisonnement. Il s’agit de formalismes permettant de représenter des systèmes physiques et de raisonner sur ces derniers. L’idée de base est que plus les concepts sont intuitifs, naturels et qualitatifs, et plus ils révèlent la pertinence de l’information et plus ils permettent d’approcher la causalité sous-jacente du système à modéliser. Ainsi, plutôt que de résoudre les équations du système physique représenté, ce qui peut être extrêmement complexe, mieux vaut parfois ne considérer que les influences entre variables. Par exemple, un humain face au problème du micro-monde lié à l’hydraulique (voir 2.4. et [Ponsa et Catala 99 (a)]) ne résout pas les équations de la mécanique des fluides, mais raisonne en utilisant des concepts qualitatifs, de sens commun qui s’y rattachent. Ainsi, un agent qualitatif a été mis au point dans le cadre de notre étude (chapitre 3). ● la catégorisation et la reconnaissance des formes. Etant donné que l’humain a une forte propension à catégoriser, qu’il s’agisse de reconnaître un objet (une forme visuelle, un type de problème, un concept, un événement) ou d’attribuer une propriété à un objet, lui permettant de raisonner efficacement et rapidement, il paraît intéressant d’utiliser une approche basée sur la classification (numérique ou symbolique) et la reconnaissance des situations typiques mises en jeu lors d’une opération de supervision de processus. Ainsi, nous avons tenté dans le cadre de notre étude de mettre au point un agent basé sur la classification à partir d’exemples (chapitre 6). ● le raisonnement à base de cas. Cette approche se base sur le fait qu’un humain utilise très souvent ses expériences passées, qu’il s’agisse de réussites ou bien d’échecs, afin de résoudre un problème courant. La méthode consiste généralement à rechercher en mémoire une expérience jugée similaire, à adapter cette expérience au contexte présent, à la valider, la réutiliser, puis enfin à la stocker. Ainsi, un agent à base de cas a été mis au point dans le cadre de notre étude (chapitres 4 et 5). Certaines des caractéristiques des modèles cognitifs de l’opérateur humain de supervision précédents (chapitre 2.2) sont présentes au sein des agents artificiels : ces derniers utilisent un modèle de décision similaire à celui proposé par Rasmussen (observation de la situation courante, détection d’une alarme, prédiction de l’évolution, définition d’un but, choix d’une action, exécution de l’action). En outre, les agents artificiels effectuent une action en se basant uniquement sur l’état courant du système, et introduisent donc une similarité avec le modèle COCOM qui préconise que le choix de la prochaine action est basé sur le contexte courant. Enfin l’agent à base de cas utilise le même principe de base que le modèle COSIMO (utilisation d’expériences passées et mise en correspondance). Chacune des approches possède une caractéristique essentielle du raisonnement humain. Les qualités et défauts mis en évidence lors des tests informatiques des agents artificiels permettront d’analyser dans quelles situations une approche est plus appropriée qu’une autre, afin de développer une coopération entre les agents. Cette coopération a pour but d’approcher le raisonnement d’un opérateur humain en situation de supervision de procédé, et donc d’approcher la complémentarité qui existe entre ces modes de raisonnements.

COMPATIBILITE ENTRE LES DEUX POINTS DE VUE

Comparaison des raisonnements d’un opérateur humain et d’un agent artificiel

Des tests seront effectués sur des sujets humains normaux afin de comparer leurs raisonnements avec ceux des agents artificiels. Les objectifs sont : ● de trouver pour chaque sujet humain l’opérateur artificiel le plus proche, ● d’exhiber les situations dans lesquelles tel opérateur artificiel est plus adéquat qu’un autre, et de faire ressortir les éléments permettant de définir une architecture pour la coopération entre les trois agents, de façon à être le plus proche possible du raisonnement humain. Il s’agit alors de construire une distance issue de la comparaison entre le raisonnement mené par un agent artificiel et celui d’un opérateur humain. Cette mesure peut être quantitative ou bien qualitative. Par exemple, pour le problème des Tours de Hanoï, un agent artificiel pourrait effectuer une recherche optimale dans un arbre d’états, et le critère de comparaison serait le nombre de pas utilisés par le sujet pour trouver la solution diminué de la longueur du plus court chemin dans l’arbre d’états élaboré par l’agent artificiel. Le problème de ce type de critère numérique est qu’il ne tient pas compte des stratégies et des buts. Il semble important que le critère de comparaison accède aux stratégies des opérateurs. Dans le cadre de notre étude, nous avons développé plusieurs critères de comparaison. Tout d’abord un critère numérique simple permet de juger globalement de la qualité de la supervision menée par un opérateur grâce à une fonction linéaire pondérée des deux buts à optimiser, le temps et le volume total qui a débordé des réservoirs. Nous avons également mis au point une méthode permettant de juger de la compatibilité globale entre un opérateur artificiel et un opérateur humain par la reconnaissance de l’intention associée à chaque action de l’opérateur humain. Il s’agit dans un premier temps d’étudier le comportement de l’agent artificiel afin de dégager des associations situation générique → intention. Une situation générique correspond à un petit ensemble de réservoirs reliés et associés à des conditions générales portant par exemple sur les volumes ou les hauteurs d’eau des réservoirs. Chacune de ces situations est associée à une intention, par – 24 – exemple éliminer une alarme, ou accélérer le processus, Il est à noter qu’une situation est définie volontairement de manière imprécise afin d’une part d’être applicable dans des conditions variées et d’autre part de pouvoir s’adapter aux notions floues chez un humain que sont la perception d’une hauteur d’eau, ou l’état d’alarme d’un réservoir, atteint lorsque le niveau d’eau est supérieur à un seuil et croît au cours du temps (voir 2.1.2. et 3.2.1.). La comparaison consiste alors à voir dans quelle mesure une action d’un opérateur humain s’inscrit dans le comportement de l’agent artificiel, ce qui nécessite d’une part une mise en adéquation floue entre la situation concrète qui a amené l’opérateur humain à agir de telle façon et des situations génériques définies lors de l’étude du comportement de l’agent artificiel, et d’autre part de vérifier si certaines conditions sont remplies, notamment l’appartenance de l’action de l’opérateur humain à l’ensemble des actions admissibles correspondant à l’intention associée à la situation générique. La modélisation floue permet alors le calcul des “degrés d’intention” associés à l’action de l’opérateur humain, et ceci pour chacune des intentions possibles de l’agent artificiel.

Coopération entre opérateurs

Il a été largement prouvé que la communication et la coopération jouent un rôle central entre les membres d’une équipe de travail . Il paraît donc naturel d’étudier ces concepts afin d’améliorer la coopération d’une part entre un opérateur humain et un agent artificiel [Vanderhaegen 99] et d’autre part entre plusieurs agents artificiels. Selon Vanderhaegen, Millot et Chalmé [Vanderhaegen et al. 04], la coopération a pour but d’optimiser la performance des systèmes ou l’intérêt collectif en interagissant avec les autres et de diminuer les erreurs de contrôle. Il s’agit donc d’un comportement orienté vers le succès. Deux opérateurs humains coopèrent si chacun tente d’atteindre des buts qui interfèrent avec ceux de l’autre opérateur et si chacun peut contrôler ces interférences de sorte à faciliter les activités de l’autre opérateur. Par opposition, la compétition a pour but d’optimiser la performance individuel ou l’intérêt personnel en interagissant avec les autres, ou de faire faire des erreurs aux autres opérateurs ou de les tromper. Deux opérateurs humains sont en compétition si leurs buts interfèrent et chacun tente de contrôler ces interférences de sorte à faciliter sa propre activité ou induire l’autre opérateur en erreur. L’approche des systèmes multi-agents est très intéressante à ce sujet. Détaillons le point de vue de Ferber . Tout d’abord, la coopération a lieu dans une situation d’interactions. Une interaction est une mise en relation dynamique de deux ou plusieurs agents par le biais d’un ensemble d’actions réciproques. Les interactions s’expriment à partir d’une série d’actions dont les conséquences exercent en retour une influence sur le comportement futur des agents. La coopération dépend de trois paramètres : – les buts des agents. Des agents sont dans une situation de coopération si leurs buts sont compatibles. Deux buts caractérisés par l’atteinte des deux états p et q sont incompatibles si p ⇒ ¬ q – les ressources des agents. Il s’agit de tous les éléments environnementaux et matériels utiles à la réalisation d’une action : outil, énergie, temps, espace, – le rapport entre les capacités des agents et les tâches à accomplir. Un agent peut-il réaliser seul une tâche, ou a-t-il besoin des autres ?

1. INTRODUCTION |