Quantification vectorielle (QV)

La quantification vectorielle est plus complexe à mettre en œuvre car il faut préalablement engendrer un ensemble de vecteurs de référence appelé dictionnaire (code book), ce qui se fait à l’aide d’un algorithme d’apprentissage que l’on applique à un ensemble d’images. La quantification consiste alors à décomposer l’image en vecteurs de taille identique à ceux du dictionnaire, à rechercher pour chaque vecteur de l’image le plus proche dans le dictionnaire et à le remplacer par l’indice dans le dictionnaire du vecteur associé. Il faut remarquer que la quantification vectorielle donne souvent de meilleurs résultats que la quantification scalaire. Récemment, des méthodes de quantification donnant de meilleurs résultats que les deux techniques citées précédemment ont été introduites. En effet ces méthodes sont avantageuses grâce au contenu spatial de la transformée en ondelettes de l’image, ceci en quantifiant les coefficients par approximations successives à travers les sous bandes de même orientation.

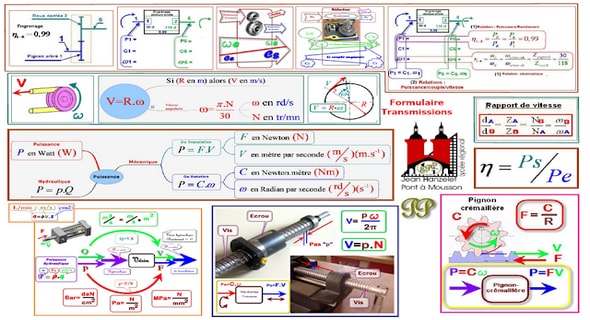

Codage par transformation Les méthodes de compression par transformation n’agissent pas directement sur l’image numérique dans sa représentation canonique, mais dans le domaine de la transformée. Cette transformation pouvant être linéaire ou non. Il est bien connu qu’une transformation permet de mettre en évidence certaines propriétés de l’image que la représentation originale ou canonique ne laisse pas apparaître. En partant d’un ensemble de valeurs numériques corrélées d’une image, le but est d’obtenir un autre ensemble de valeurs le moins corrélées possible dans l’espace transformée. En général, les schémas de codage par transformation subdivisent l’image de taille N × N en sous images de taille plus petites avant de faire subir à ces sous images une transformation. Nous privilégions les transformations unitaires et qui conservent l’énergie. La transformation consiste en la décomposition de l’image dans une base adéquate de fonctions tels que les coefficients de la transformation soient indépendants et qu’un nombre minimum de ces coefficients contienne une proportion importante de l’énergie de l’image. Ainsi, on pourra mettre à zéro certains d’entre eux sans nuire de manière significative ni à la quantité d’énergie, ni à l’aspect visuel de l’image reconstruite.

Une transformation adéquate pour la compression d’image devrait permettre la décorrélation des coefficients transformés, la conservation d’énergie ou sa condensation dans un nombre minimum de coefficients et enfin posséder un algorithme rapide. Les transformations linéaires sont les plus utilisées car ayant des expressions analytiques simples et s’implémentant assez vite. Pour satisfaire la contrainte de décorrélation, on utilise les bases orthogonales et les transformations utilisées en compression sont orthogonales. Autrement dit, ce sont des opérations séparables, c’est-à-dire que l’opération en deux dimensions est équivalente à deux opérations successives à une dimension, l’une horizontalement et l’autre verticalement. [15] Il existe de très nombreuses transformations orthogonales parmi elles, la transformée de Karhunen-loeve, la transformée en sinus, cosinus…

Transformations spectrales ou sinusoïdales

La transformation de Fourier et celles qui s’en déduisent, telles la transformation en sinus, la transformation en cosinus, sont très utilisées en analyse et en filtrage du signal. Ces transformations possèdent des algorithmes rapides comme la FFT (Fast Fourier Ttransform) et ses variantes. La variable de l’espace transformé étant la fréquence, une telle décomposition permet de mieux observer la répartition fréquentielle de l’image. Etant donné que ce sont les premiers harmoniques qui contiennent la quasi-totalité de l’énergie, il est donc possible de mettre à zéro une proportion importante des coefficients et de coder l’image à moindre coût. Malgré la rapidité de la transformation de Fourier, elle décompose l’image en une partie réelle et une partie imaginaire pouvant se convertir en module et argument ce qui n’est pas facile à manipuler ou à interpréter. Les traitements de ces données peuvent s’avérer lourds, d’où la préférence accordée à la transformation en cosinus qui bénéficie de toutes les caractéristiques de la FFT. La transformée en cosinus discrète DCT (discret Cosine Transform) a été choisie comme standard par JPEG (Joint Photographic Experts Group) pour le codage d’images fixes et a fait l’objet de beaucoup d’études et d’applications de la compression dans tous les domaines de l’imagerie, y compris le médical. Contrairement à la transformation KLT, la matrice de transformation DCT est complètement indépendante de l’image.

Transformée en ondelettes discrète DWT : La transformée en ondelette continue est très redondante. Il suffit en pratique de quelques coefficients pour couvrir entièrement le plan temps échelle. Les paramètres a et b sont fondamentalement continus. Leur discrétisation ne s’effectue pas selon un critère bien défini. Quant à la transformée en ondelettes discrète le concept est différent. En effet, numériquement nous devons savoir comment discrétiser cette transformée de telle manière à conserver les propriétés intéressantes. Nous donnons donc que les paramètres de dilatation a et de translation b puissent être discrétisés sans perte d’information. Nous pouvons donc formuler le problème de l’existence d’une famille ,ba nm dénombrable, formant une base de 2 L et permettant une reconstruction exacte du signal en question. Cette famille redondante d’ondelettes discrètes, a été introduite dans le cadre des frames ou structures obliques par Ingrid Daubechies. La redondance d’informations contenues dans cette transformée peut être généralement intéressante dans le cadre de l’analyse des signaux. En effet, elle est intéressante dans la mesure où les conditions que doivent vérifier les ondelettes ne sont pas trop contraignantes [75]. La reconstruction numérique du signal est stable. D’autre part, avec l’introduction des bases orthonormées d’ondelettes [76], la théorie des ondelettes a pris un tournant décisif dans le sens où cette notion de base orthonormée constitue un outil clef en traitement du signal ; elle a des contraintes de rapidité nécessitant le minimum de données possible.

Introduction générale |