Bruits de fond

La première étape de l’analyse est de déterminer les bruits de fond possibles du canal W → eν : ce sont les processus dont la signature expérimentale peut être identique au processus étudié et dont la production (résultant dans cette signature) est non négligeable par rapport à celle du signal. La signature des événements W → eν est la présence combinée d’un électron de haute impulsion transverse et d’une énergie transverse manquante élevée (E/T). Les bruits de fond possibles sont décrits qualitativement dans la suite. Les valeurs de section efficace indiquées proviennent de la référence [25] et les valeurs de rapport de branchement proviennent de la référence [11]. • W → eν (σ = 20510 pb) • W → τν (σ = 20510 pb) avec τ → eνeντ (B.R.(τ → eνeντ ) = 0.1785) : un électron est produit dans l’état final et les trois neutrinos contribuent à E/T. • Z → ee (σ = 2015 pb) : un des deux électrons n’est pas identifié (produit en dehors de l’acceptance ou ne satisfait pas les conditions d’identification). E/T est mal reconstruite. • Z → ττ (σ = 2015 pb) : un des deux taus se désintègre semi-leptoniquement en électron-neutrino (B.R.(τ → eνeντ ) = 0.1785). • tt¯ (σ = 833 pb) Le quark top se désintègre à 100% en W b : un des deux W produits se désintègre semi-leptoniquement en électron-neutrino (B.R.(W → eν) = 0.1080). • Production inclusive de jets : ce sont des événements dans lesquels un jet est identifié comme un électron. Ce sont principalement des jets contenant un électron non isolé issu de la désintégration d’un hadron chargé. Le processus majoritaire est la production d’une paire de jets. Les événements photonjet contribuent également. La section efficace est de l’ordre de plusieurs millibarns. Ce bruit de fond sera appelé QCD dans la suite.Les sections efficaces de production combinées avec les rapports de branchement rendent négligeable la contribution des canaux Z → ττ et tt¯ par rapport aux autres bruits de fonds : seuls les canaux W → τν, Z → ee et QCD seront considérés dans la suite.

Production de données simulées

La chaîne de traitement des données

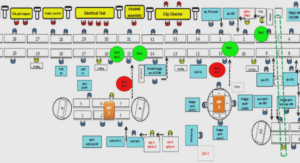

L’environnement logiciel d’ATLAS est appelé Athena. Il dérive du projet Gaudi, initialement développé pour l’expérience LHCb. Il est basé sur le langage de programmation orienté objet C++. Les jobs (séquences d’algorithmes) sont contrôlés par des scripts Python. Un principe essentiel d’Athena est la séparation entre les données et les algorithmes d’une part, et entre les données temporaires (dans la mémoire) et les données permanentes (dans les fichiers de données) d’autre part. Toutes les étapes de traitement des données dans ATLAS sont effectuées dans Athena. La Figure 4.1 schématise les différentes étapes pour des données réelles ou simulées. FIG. 4.1 – Traitement des données réelles et simulées dans ATLAS [63] Dans le cas de données réelles, les données en sortie du détecteur sont traitées par des algorithmes de reconstruction pour être ensuite stockées dans un format de données directement exploitable pour l’analyse (ESD pour Event Summary Data ou AOD Analysis Object Data). Les objets physiques de même nature (p. ex. les traces du détecteur interne) sont regroupés dans des containers. Dans le cas de données simulées, la première étape est la génération de particules avant passage dans le détecteur, par un générateur Monte-Carlo pour un processus défini. Les particules produites sont ensuite propagées dans le détecteur ATLAS, en utilisant une simulation du détecteur ATLAS par Geant4 [64] : c’est un outil permettant de simuler l’interaction des particules avec la matière. La dernière étape est la reconstruction : dans cette étape, le traitement des données simulées est identique au cas des données réelles. Ainsi le format final des données simulées est identique à celui des données réelles ; la seule différence est la présence de l’information sur les particules produites au niveau générateur (appelée “la vérité Monte-Carlo » dans la suite). Une simulation rapide du détecteur (ATLFAST), permettant de gagner un facteur ∼ 5 en temps de calcul, a également été développée : elle est particulièrement adaptée aux analyses dans lesquelles on veut étudier diverses valeurs d’un paramètre d’entrée (p. ex. la masse du boson de Higgs).

La grille de calcul

La quantité de données, produites par les expériences du LHC, à traiter et à stocker a rendu nécessaire la mise en place d’une grille de calcul permettant de mutualiser les ressources de calcul et l’espace disque entre les différents centres de calcul des laboratoires participant aux expériences. Ce projet est appelé WLCG, pour Worldwide LHC Grid Computing [65]. La structure reliant les centres de calcul appartenant à la grille est hiérarchique : un Tier-0 (le CERN), ∼ 10 Tiers-1 et ∼ 80 Tiers-2. Chaque catégorie de centre possède des missions différentes (p. ex. de reconstruction, de simulation Monte-Carlo ou d’analyse).

Echantillons de données utilisés

Afin d’effectuer l’analyse, un nombre d’événements suffisant doit être simulé pour chaque processus (signal et bruits de fond). Le générateur PYTHIA [66] interfacé avec les PDFs CTEQ6L [46] a été utilisé pour tous les processus. D’autres générateurs ont été utilisés pour déterminer l’incertitude théorique sur l’acceptance (voir Chap. 8). Pour limiter le temps de simulation, des filtres sont appliqués au niveau générateur : pour un processus donné, un filtre a pour but d’enrichir artificiellement l’échantillon en événements “intéressants », en appliquant des coupures de présélection. Les propriétés des différents échantillons de données simulées sont résumées dans la Table 4.1. Les filtres appliqués sont les suivants : • W → eν : p e T > 10 GeV, | η e |< 2.7 ; • W → τν : un électron ou un muon tel que p l T > 5 GeV et | η l |< 2.8 ; • Z → ee : p e T > 10 GeV, | η e |< 2.7, √ sˆ> 60 GeV ; • QCD : deux conditions sont imposées i) l’énergie transverse du processus dur doit être supérieure à 15 GeV ii) la somme de l’énergie transverse de toutes les particules stables dans la région | η e |< 2.7 (en dehors des muons et des neutrinos) doit être supérieure à 17 GeV dans une tour de taille ∆η ×∆Φ = 0.12×0.12. Le but de la seconde coupure est de reproduire au niveau générateur une sélection similaire à celle appliquée au L1 trigger pour identifier les objets électromagnétiques. La simulation complète du détecteur a été utilisée. La géométrie du détecteur (ATLAS-CSC-01-02-00) est une géométrie altérée par rapport à la nominale : de la matière a été ajoutée (en particulier dans le cryostat et dans les cracks), de manière non symétrique en Φ. L’ajout peut représenter jusqu’à 10% de X0. L’hypothèse de travail effectuée pour l’analyse est l’accumulation de 50 pb −1 de données à une luminosité de 1031 cm2 s −1 . Le menu trigger utilisé est adapté à cette luminosité [25]. Les événements sont simulés sans empilement : les effets d’empilement peuvent être négligés à 1031 cm2 s −1 . Dans la suite, tous les résultats seront normalisés à 50 pb−1 . Il est à noter que par rapport à cette luminosité intégrée de référence, le nombre d’événements QCD simulés est très insuffisant (facteur ∼2500). De plus, l’incertitude théorique sur la section efficace de production de ces événements est un facteur ∼ 3 : cette incertitude est dûe principalement aux contributions non-perturbatives et à la PDF du gluon à bas x.

Outils d’analyse

La version d’Athena utilisée est 12.0.6. Le format de données utilisé est les AODs. L’accès aux AODs sur la grille est effectué via l’outil d’analyse distribuée GANGA [67]. L’analyse finale est effectuée dans ROOT [68].