Application sur un signal audio

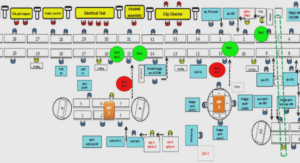

Architecture du système de classification

L’architecture du système mis en place est résumée dans la figure 6.1. Nous avons traité, dans les chapitres 3 et 4, de la question de l’apprentissage des SVM ainsi que de la sélection du noyau optimisant les performances par rapport à un ensemble d’apprentissage. Nous aborderons dans ce chapitre la constitution de l’ensemble d’apprentissage, par l’extraction de descripteurs audio calculés sur le signal audio du corpus d’apprentissage après un découpage en trames. De par la nature discriminative des SVM, nous avons vu dans le chapitre 5 qu’il est nécessaire de combiner plusieurs discriminateurs dans une situation impliquant plus de deux classes. Le processus hiérarchique de combinaison des classifieurs est synthétisé dans une taxonomie multiclasses, que l’on retrouve en haut à gauche de la figure 6.1. Cette taxonomie implique un ensemble de classifieurs, chacun étant destiné à discriminer une paire de classes donnée. Sur chacune de ces paires on appliquera donc, de manière indépendante, les traitements contenus dans l’encadré jaune de la figure. Ainsi, nous verrons dans le chapitre 7 qu’à la phase d’extraction générale des descripteurs succède une sélection des descripteurs les plus pertinents, qui est bien sûr propre à la paire de classes considérée. Un modèle SVM est par la suite appris sur les descripteurs sélectionnés. L’application du système sur le corpus audio d’évaluation (ou de test) suivra la même séparation en processus distincts propres à chaque paire. Ainsi on n’extraira cette fois-ci que les descripteurs sélectionnés, puis on classifiera les exemples inconnus au moyen du modèle SVM appris. Ensuite en suivant la méthode présentée dans la section 5.1.5.4, on estime les probabilités a posteriori qui nous permettent d’appliquer l’un des procédés de post-traitement dynamiques qui seront présentés dans les chapitres 8 et 9. 6.2 Analyse du signal en trames La tâche de classification porte sur un signal audio numérique fini de L échantillons. On supposera par la suite que celui-ci est échantillonné à fs = 16 kHz. Le signal est représenté par un vecteur x de L échantillons : x = [x1, . . . , xL] T . La valeur de chaque échantillon indépendamment des autres n’apporte aucune information concernant les propriétés du signal à un instant donné. On doit donc considérer un ensemble de N échantillons successifs appelé trame. On admettra qu’un signal audio est stationnaire sur une durée inférieure à 40 ms. Afin d’optimiser le calcul de la FFT (Transformation de Fourier Rapide), on choisira donc la puissance de 2 la plus élevée satisfaisant cette contrainte, soit N = 2blog2 (fs×0.04)c = 512 ce qui correspond à des trames de 32 ms. On utilise généralement un pas d’avancement de R échantillons entre les trames, qui est inférieur à la taille de la fenêtre, afin d’accroître la précision temporelle de la classification ; on parle alors de trames chevauchantes. On choisit ici R = N 2 = 256. Le signal sera donc caractérisé par un ensemble de valeurs calculées sur ces trames temporelles. Nous verrons qu’une partie implique le spectre fréquentiel défini par l’analyse de Fourier. On calcule donc les 256 composantes d’amplitude ak et de phase φk associées à chaque bin fréquentiel d’indice k, après pondération de la trame par une fenêtre de Hamming. La classification sur des exemples caractérisant des trames temporelles constitue le paradigme de base de l’apprentissage statistique. Cette approche est généralement appelée sac de trames (bag of frames). 6.3 Intégration temporelle Nécessaire pour caractériser les propriétés instantanées du signal, le découpage en trames courtes reste cependant lacunaire puisque nombre de phénomènes acoustiques n’ont de sens que sur une portée temporelle plus longue ; par exemple, en musique et en parole, le trémolo et le vibrato sont des grandeurs impliquant des modulations d’amplitude ou de fréquence sur une durée de l’ordre d’une seconde. On peut d’ailleurs montrer que la durée nécessaire à un humain pour la reconnaissance de genre musical est de l’ordre de 0.5 à 3 secondes [184]. On trouvera dans [243] une étude comparative de plusieurs horizons temporels pour la classification de genres musicaux. La prise en compte d’une échelle temporelle plus étendue se fait généralement au travers de deux moyens [155] : soit par l’inclusion de descripteurs dit « long-terme », directement calculés sur des trames longues de l’ordre d’une seconde, également nommées fenêtres de texture par Tzanetakis et Cook [229] et d’autre auteurs [41][164], soit par l’intégration statistique des valeurs des descripteurs court-terme sur les trames longues. Nous présentons ci-dessous ces deux possibilités que nous exploitons conjointement.

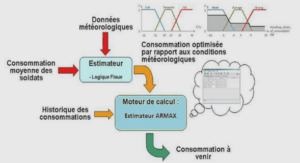

Intégration statistique

Le découpage en trames courtes est nécessaire pour évaluer les propriétés instantanées définies par certains descripteurs. Cependant, la précision induite, de l’ordre de la dizaine de millisecondes, 87 CHAPITRE 6. APPLICATION SUR UN SIGNAL AUDIO est largement supérieure aux besoins pratiques. Nous verrons par la suite que la campagne d’évaluation ESTER tolère une erreur de 0.25 s sur les frontières de segments de classification. Plusieurs études [184][7] établissent d’ailleurs que la durée nécessaire à un être humain pour classifier un extrait audio est de cet ordre de grandeur. De plus, d’un point de vue pratique, la classification sur trames courtes est extrêmement coûteuse en ressources et implique un nombre très élevé d’exemples (de l’ordre de 200000 par heure de signal). Étant donné que l’on se limite à quelques dizaines de milliers d’exemples pour l’apprentissage des SVM 1 , on en déduit que le corpus d’apprentissage serait caractérisé de manière très parcellaire sur une base de plusieurs dizaines d’heures. En pratique on choisit donc non pas de considérer les descripteurs eux-mêmes, mais certaines grandeurs statistiques calculées sur un nombre de trames suffisamment significatif. On exploite ici la synchronisation entre trames courtes et longues en calculant ces mesures statistiques sur les trames courtes couvertes par chaque trame longue. De plus, une comparaison de plusieurs échelles temporelles d’intégration statistique montre [182] que les meilleurs résultats sont obtenus pour 1 s, ce qui correspond à la longueur de nos trames longues. À chaque trame longue est donc associé un vecteur de descripteurs composé de statistiques de descripteurs court-terme et de descripteurs long-terme sans traitement statistique. Ainsi, si x(n) est la suite des valeurs d’un descripteur court-terme, où n est l’index de trame, on calcule les descripteurs long-terme X(m), indexés par l’indice de trame longue m (on suppose que les indices débutent à 0) : X(m) = f (x(mRmul), x(mRmul + 1), . . . , x(mRmul + Nmul − 1)). f représente ici le traitement statistique appliqué ; on parle également d’intégration de descripteurs, dans un sens plus large. Nous n’exploitons dans cette étude que les grandeurs les plus couramment exploitées [140][30][229] : la moyenne et l’écart type. Les bornes minimales et maximales sont également exploitées par certains auteurs [48] mais celles-ci sont trop sensibles à d’éventuelles valeurs marginales excentrées. Nous avons d’ailleurs montré dans une étude précédente [191] que leur inclusion dans le processus de classification parole/musique n’améliore pas les performances. D’autres intégrations ont été explorées dans la littérature. En particulier, Meng a proposé [154] l’exploitation des coefficients d’un modèle auto-régressif appris sur les descripteurs d’une trame longue et fournit par ailleurs une étude comparative impliquant divers procédés d’intégration [155]. Toutefois, les coefficients d’un modèle AR sont connus pour être instables et leur évolution est discontinue par rapport aux variations du signal. On trouvera également dans [116] une étude assez exhaustive des différents procédés d’intégration sur une tâche de reconnaissance automatique des instruments de musique. Les résultats présentés ne montrent cependant pas d’avantage clair et systématique à utiliser des méthodes d’intégration plus complexes et confirment ainsi notre choix de ne pas explorer plus en profondeur ce sujet.

Discussion

Les descripteurs présentés ont avant tout été choisis pour respecter deux contraintes essentielles liées à notre cadre particulier. En premier lieu le système mis en place est conçu pour fonctionner en temps réel ; il ne doit pas impliquer de descripteurs coûteux. Ont donc été rejetés de nombreux descripteurs basés sur une analyse spectrale plus poussée par un modèle psychoacoustique de l’audition [194][157], impliquant une forte charge en temps de calcul ; ou d’autres qui permettent de mieux appréhender le matériau musical éventuel. Ainsi on trouve dans la littérature certaines formes de « transcriptions ébauchées » à travers la recherche de trajectoires de pics spectraux [121]. Ces approches ont par ailleurs généralement l’inconvénient de se baser sur des algorithmes de type Viterbi, impliquant les trames futures dans la prise de décision. Cette contrainte temporelle est la seconde restriction que nous nous imposons. Une réponse en temps réel implique une décision régulière et instantanée, ou au moins avec retard constant, qui exclue donc l’usage de descripteurs temporellement alignés sur des événements particuliers, comme les attaques. On trouve par exemple dans la littérature plusieurs propositions impliquant une estimation du tempo ou de la structure rythmique [111][41], que nous avons exclues de notre cadre expérimental, puisqu’elles font intervenir une modalité temporelle beaucoup plus large (de 91 CHAPITRE 6. APPLICATION SUR UN SIGNAL AUDIO l’ordre de plusieurs secondes). Certains auteurs, comme Lachambre et al. [129], se basent également sur une décomposition temporelle du signal en segments « homogènes » de tailles variables servant chacun de support au calcul d’une valeur. Beaucoup de ces propositions émanent de domaines annexes, plus directement liés à la musique, comme la reconnaissance de genres ou d’ambiances musicales. Nous supposons ici, sans toutefois l’étayer par un constat psychoacoustique, que les classes impliquées (parole, musique, chant) sont identifiables par un être humain de manière quasi instantanée et surtout hors de tout contexte. Les classes considérées sont plus clairement définies et peu ambigües 2 , contrairement à d’autres domaines, comme la reconnaissance de genre musical, qui fait intervenir des notions sémantiques et cognitives. La plupart des descripteurs réunis ici sont d’usage très courant dans la littérature. On notera en outre que les traitements statistiques décrits dans la section 6.3 font apparaître certaines propriétés qui peuvent sembler absentes de notre liste. Par exemple le taux de trames à basse énergie ou le taux de trames silencieuses, que l’on trouve assez fréquemment [207][138][109] dans la littérature, est équivalent à la moyenne de l’énergie des trames court-terme. De plus, certains descripteurs, difficilement interprétables tels quels, comme les moments temporels, prennent leur sens si l’on considère leur moyenne ou leur variance. Ainsi la variance de la largeur temporelle constitue une alternative à l’estimation du taux de trames à basse énergie. En définitive on remarquera que de nombreux descripteurs, parmi ceux présentés, sont fortement redondants dans leur définition. On peut en effet grouper ceux-ci en 4 modalités principales : • Centre spectral : estimation du centre de gravité du spectre. Par exemple le centroïde spectral, le ZCR, le ZCR long-terme, et l’acuité perceptive. • Répartition spectrale : description de l’allure ou de la répartition spectrale. Par exemple la largeur, l’asymétrie, la platitude, le rapport, la pente, et la décroissance spectraux, la fréquence de coupure, la platitude d’amplitude spectrale, le facteur de crête spectrale, ou encore l’étalement perceptif. • Énergies de sous-bandes : de nombreux descripteurs fournissent une estimation de l’énergie de sous-bandes spectrales, généralement grâce à l’usage de banc de filtres, ou à travers l’estimation d’enveloppes spectrales. On peut ainsi citer les descripteurs OBSI et OBSIR, les coefficients LPC, MFCC, à Q constant, ainsi que la loudness spécifique relative. • Estimation de pitch : enfin, une série de descripteurs fournissent une estimation de la fréquence fondamentale dominante, comme le F0 estimé par YIN, et les coefficients d’autocorrélation. Les autres descripteurs expriment des caractéristiques plus particulières, comme la mesure d’apériodicité estimée par YIN, les mesures de trémolo et de rugosité par modulation d’amplitude, le flux spectral, décrivant les variations du spectre, ou encore les moments statistiques temporels. Bien que ces descripteurs soient pertinents pour la discrimination parole/musique, on remarque que la littérature s’attarde très peu sur le problème des classes mixtes. En effet, l’observation comparatée de spectres de parole et de musique met en évidence de nombreuses différences assez claires que beaucoup d’auteurs ont tenté de traduire par des mesures quantifiées. Néanmoins, la plupart de ces observations perdent leur sens lorsque l’on superpose les signaux des deux classes. Or nous verrons par la suite, dans la partie IV sur l’évaluation, que la majeure partie des erreurs du système provient précisément de confusions sur cette situation (la parole accompagnée de musique). On peut bien sûr être tenté de faire appel à des techniques de séparation de sources mais cellesci sont généralement beaucoup plus complexes et coûteuses que les méthodes impliquées dans la classification audio. De plus, de nombreux algorithmes de séparation de sources font généralement appel à des techniques de classification afin d’identifier les régions pertinentes à séparer, ce qui inverse totalement la méthodologie.