La Tâche « Résumé et mise à jour » dans TAC 2008 et TAC 2009

Description de la Tâche

La tâche « Update » de TAC 2008 est inspirée d’un scenario dans lequel un utilisateur pose une même question à un système d’extraction d’information/résumé automatique à deux instants différents. La première fois, le système renvoie à l’utilisateur des articles de presse pertinents que l’utilisateur lit dans son ensemble. Plus tard, l’utilisateur revient au système afin de prendre connaissances des nouvelles informations concernant sa question. De nouveaux articles sont parus et le système doit générer un résumé de « mise à jour » de ces articles sachant que l’utilisateur a déjà lu le résumé lié à sa première demande.

La tâche « Résumé et mise à jour »(Update Task) est restée inchangée en 2009, afin que le NIST puisse évaluer les avancées réalisées en un an par les différents participants. Dans la continuité de la tâche de mise à jour de la campagne d’évaluation DUC 2007 2, elle consiste à réaliser deux types de résumés :

– Initial : un résumé initial de 100 mots d’un jeu de 10 dépêches qui traitent d’un sujet particulier ;

– Mise à jour : un résumé de 100 mots d’un nouveau jeu de 10 dépêches qui traitent du même sujet. Ce résumé doit être généré en tenant compte du fait que le lecteur a déjà pris connaissance des informations contenues dans les 10 dépêches du jeu de documents utilisé pour le résumé « initial ». L’objectif de ce second résumé est d’informer le lecteur des nouvelles informations à propos du sujet traité.

Description du corpus

Les dépêches de presse à résumer sont issues du corpus AQUAINT-2 (Dang et Owc-zarzak, 2008b). Ce corpus est un recueil de dépêches et comprend environ 907.000 do-cuments constituant 2.5Go de texte, soit environ 40 millions de mots. Ces dépêches couvrent la période d’octobre 2004 à mars 2006 et proviennent de sources variées : AFP (en anglais), CNA (Taiwan), Xinhua News Agency, LA Times-Washington Post, NY Times et Associated Press.

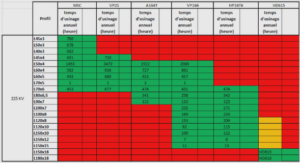

Les évaluateurs de NIST ont créé 48 sujets et sélectionné 20 documents issus d’AQUAINT- pour chacun d’eux. Les documents extraits ont été ordonnés chronologiquement et di-visés en deux jeux de 10 documents chacun, de telle manière que les documents d’un des jeux soient tous postérieurs à ceux de l’autre jeu, et constituent les sources du résumé de « mise à jour ». Le tableau 5.1 montre les titre, origine et date des documents qui constituent un sujet issu de TAC 2008.

Les dépêches issues des jeux de documents à résumer sont de longueur variable. Dans TAC 2008, le nombre de mots par dépêche varie entre 46 pour la plus petite et 3049 pour la plus grande. Elles font en moyenne 550 mots. Les données de TAC 2009 sont sensiblement identiques : la dépêche la plus petite fait 52 mots, la plus grande 4325 et la moyenne est de 580 mots par dépêche.

Adaptation de CBSEAS pour la tâche de résumé et mise à Jour

Les corpus de TAC 2008 et 2009 sont constitués de dépêches de taille moyenne. Ces dépêches ne sont pas majoritairement des dépêches courtes, qui relatent un événement en quelques phrases, sans le développer. Les dépêches de TAC replacent généralement l’événement dont elles traitent dans son contexte, en relatant notamment les événements majeurs qui ont conduit à la situation décrite. Ainsi, sur plusieurs dépêches, les mêmes informations essentielles reviennent à plusieurs reprises. Notre approche de résumé au-tomatique, CBSEAS, se fonde sur le regroupement des phrases en classes sémantiques. Elle paraît tout indiquée ici, au vu du nombre de redondances identifiables dans les jeux de documents à résumer. Cependant, l’aspect particulier de la mise à jour ainsi que le traitement de dépêches de presse uniquement impliquent des adaptations afin de rendre notre système efficace pour cette tâche. Nous décrivons ci-dessous les adaptations que nous avons effectuées pour notre participation à la tâche « résumé et mise à jour » de TAC 2008 et TAC 2009.

Filtrage des documents

Les dépêches de presse comportent des parties de texte indésirables dans un résumé automatique. Elles nécessitent donc un pré-traitement afin d’éliminer toute partie que l’on ne veut pas voir figurer dans le résumé généré par CBSEAS. Après avoir analysé le corpus d’apprentissage fourni par NIST, nous avons trouvé deux catégories de textes problématiques. Premièrement, certaines dépêches présentent également un récapitula-tif des dépêches déjà publiées et en cours de publication sur un sujet précis, avec leur titre, leur auteur, et leur date de publication. Les descriptions de ces dépêches ont de fortes probabilités d’être intégrées dans le résumé car les requêtes utilisateur reprennent souvent les mêmes entités que celles contenues dans les titres des dépêches. Ensuite, certaines dépêches comportent des notes de pied de page. Celles-ci ne sont malheureu-sement pas annotées dans les documents de TAC, et constituent un réel problème pour un système de résumé automatique.

Ces notes figurent en bas d’un tiers des dépêches. Elles sont constituées en très grande majorité par des renvois à des sources d’information sur internet débutant généralement par les expressions : « On the Web » et « On the Net ». La figure 5.1 présente des exemples de ce type d’éléments. Ils correspondent à des motifs réguliers et facilement identifiables automatiquement et se révèlent particulièrement gênants pour notre système. Ils doivent être éliminés en amont de la génération du résumé. En effet, ces motifs répétitifs seraient regroupés par CBSEAS dans une seule et même classe, et l’un d’eux serait extrait dans le résumé car central dans sa classe et bien noté en similarité avec la requête. En effet, ces motifs contiennent généralement des éléments du titre de la dépêche. Au vu de la méthode de génération des jeux de documents et des requêtes, ils contiennent également par extension des éléments de la requête. Pour éviter ce biais, nous avons établi des filtres permettant d’éliminer ce type d’expressions.

Analyses linguistiques fines

Notre système repose en grande partie sur le calcul de similarité entre les phrases. Améliorer ce calcul de similarité permet d’obtenir un regroupement en classes séman-tiques ; ceci est la clé pour gérer plus finement la diversité et la centralité locale telle qu’elle est définie en §3.2.5. Il existe trois solutions à cela : améliorer la méthode de cal-cul de similarité en utilisant des outils statistiques plus performants, prendre en compte des critères linguistiques plus fins, ou encore travailler sur la sémantique des phrases afin de reconnaître les reformulations, comme l’ont fait (Barzilay et McKeown, 2005) pour l’anglais. Cependant, cette dernière solution est difficilement adaptable à des langues dif-férentes. Nous avons choisi la deuxième option, qui nous permet d’explorer les avancées récentes du TAL afin d’améliorer notre calcul de similarité entre phrases et présentons ici les différentes solutions que nous avons mises en œuvre à cet effet.

Analyse en entités nommées

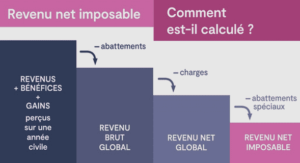

Les entités nommées « correspondent traditionnellement à l’ensemble des noms propres présents dans un texte, qu’il s’agisse de noms de personnes, de lieux ou d’organisations, ensemble auquel sont souvent ajoutées d’autres expressions comme les dates, les unités monétaires, les pourcentages et autres »(Ehrmann et Jacquet, 2006). Les syntagmes qui composent ces objets sont généralement composés de plusieurs mots. Parce qu’ils réfèrent majoritairement à une entité nommée, nous avons choisi d’inclure les groupes nominaux définis (e.g. « le Président de la République française », « l’Université Paris 13 ») dans notre définition des entités nommées . Prendre en compte de tels syntagmes comme une unité sémantique dans nos calculs de similarité entre phrases ou de similarité à la requête permet d’améliorer ces calculs. En effet, les entités nommées comportent souvent des titres communs. Deux entités nommées différentes qui partagent le même titre et apparaissant dans deux phrases distinctes augmentent la similarité entre celles-ci. Ce phénomène est très répandu. En effet, en analysant les dépêches de TAC 2008, nous avons trouvé que, dans un même jeu de 20 documents (nous présentons ici les analyses du jeu de documents D0805 donné en annexe A.2.1), le titre « Président » peut annoncer dix entités nommées différentes (cf fig.5.2).

De plus, une entité nommée composée de deux unités lexicales compterait deux fois dans le calcul de la similarité entre deux phrases dans lesquelles elle apparaît. Il est donc nécessaire d’analyser les documents en entités nommées afin de regrouper ces unités lexicales au sein d’un même élément. Le poids d’une entité nommée dans les calculs sera alors indépendant du nombre d’unités lexicales qui la composent. Les calculs de similarité ainsi que nos regroupements en classes sémantiques seront de fait plus précis. Pour ce faire, nous avons utilisé la méthode décrite en §4.1.2.

Résolution d’anaphore et de co-référence

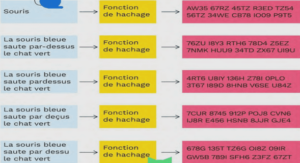

L’une des règles de la rédaction de textes est de minimiser la redondance lexicale en ne répétant pas un même mot deux fois, mais en utilisant des synonymes. Cette règle s’applique également aux entités nommées. La règle est alors d’utiliser un syntagme nominal différent ou un syntagme pronominal pour référer à une entité nommée déjà citée (cf fig. 5.3).

Les dépêches de presse courtes font exception à la règle, car elles sont rédigées de manière à ce que leur compréhension soit immédiate. Les co-références et anaphores, qui demandent un effort cognitif de la part du lecteur, sont donc évitées au maximum. Cependant, les corpus de TAC 2008 sont composés majoritairement de dépêches de taille moyenne. Il y a donc des risques de rencontrer des expressions non auto-référentielles. Or l’amélioration du calcul de similarités entre phrases passe par la résolution de la référence de telles expressions. De même, un résumé doit se suffire à lui-même ; il ne faut donc pas intégrer à un résumé des phrases dans lesquelles des expressions pronominales n’ont pas été remplacées par leur référent.

Nous avons donc utilisé un outil de résolution d’anaphore et de co-référence (cf §4.1), le système ANNIE intégré à GATE (Cunningham et al. , 2002), que nous avons appli-qué aux entités nommées uniquement, afin d’améliorer les calculs de similarité. Nous avons également utilisé ce système pour remplacer dans les résumés les expressions pro-nominales par leur référent, et remplacé les entités nommées longues par des entités équivalentes plus petites afin de réduire la taille des résumés. La méthode utilisée est décrite plus en détails en §4.1.2.