Structuration thématique des corpus de textes

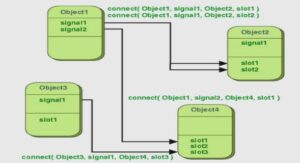

Nous abordons le problème de la classification des textes avec la méthode LDA, allocation latente de Dirichlet. Cette méthode due à [Blei 2003] est décrite par un mélange de distributions multinomiales qui correspondent à la distribution des mots dans les thèmes et la distribution des thèmes dans les documents. LDA est un modèle génératif : chaque distribution est reliée à une autre par un lien de parenté, l’ensemble est ainsi décrit dans un réseau bayésien. Dans ce réseau, chaque distribution est représentée par une variable aléatoire qui peut être latente ou observée.

Les variables latentes sont calculées par une approximation fondée sur les variables observées. Ce modèle génératif nous permet d’éviter la manipulation de matrices creuses de grandes dimensions sur laquelle le temps d’exécution des algorithmes de classification serait prohibitif. La première étape du travail consiste à calculer les thèmes qui sont présents dans la collection de textes. Un thème est représenté par une variable latente dans LDA.

Nous avons donc implémenté l’échantillonnage de Gibbs qui est un algorithme d’approximation. Notre implémentation permet de calculer la distribution des mots dans les thèmes et la distribution des thèmes dans les documents. La seconde étape consiste à rapprocher les documents selon les thèmes qu’ils contiennent afin de les classifier. Pour ce faire, nous avons besoin d’obtenir une représentation flexible et opérationnelle de la proximité, ce qui nous a ramenés à introduire la prétopologie.

Nous faisons dans ce chapitre des rappels nécessaires et ciblés pour notre cadre de travail. En effet, un espace prétopologique pour les documents est construit en utilisant une collection de relations binaires où le calcul des « fermés » permet de structurer cet espace selon les thèmes qu’ils partagent. Nous nous plaçons dans le cadre de la classification des documents. Les parties présentées correspondent à une introduction conceptuelle et méthodologique des travaux de classification de textes que nous allons aborder dans les chapitres 4 et 5.

L’intérêt de ces travaux consiste à : (i) organiser des documents donnés pour faciliter la recherche d’informations, (ii) générer automatiquement des résumés (iii) catégoriser les documents dans une structure définie, par exemple une archive web ou une hiérarchie de catégories partant de la plus générale vers la plus particulière. Afin de procéder à la classification, les textes sont représentés numériquement par les occurrences des mots qu’ils contiennent.

La dimension de cette représentation est importante; cependant, elle est creuse car un document ne peut contenir qu’un nombre réduit de mots qui sont tirés du lexique de toute la collection, nombre qui par exemple peut être de l’ordre de 107. Cette problématique est mise en exergue 28 Chapitre 3. Structuration thématique des corpus de textes dans le cas des textes provenant des échanges sur les réseaux sociaux.

Par exemple, dans le cas de Twitter les documents ne dépassent pas 140 caractères. Nous utilisons dans nos travaux une méthode probabiliste pour décomposer la représentation initiale de la collection de documents en un ensemble de variables latentes. Ces variables latentes peuvent être considérées comme des portraits-robots de la représentation initiale, ils nous permettent de répondre au problème de la di mensionnalité déjà évoqué.

En pratique, ces portraits-robots ou variables latentes correspondent aux thèmes des différents textes. Ils nous permettent de construire un espace sémantique où les documents peuvent être rapprochés par leur proximité thématique à condition de définir une distance appropriée et un voisinage. Nous utilisons pour cela la prétoplogie un affaiblissement de la topologie. La prétopolo gie est un outil de modélisation du concept de proximité dans les espaces discrets [Belmandt 2011]. Dans notre cas c’est l’espace sémantique composé d’un ensemble de documents.

Ce chapitre est organisé comme suit. Dans la première section, nous positionnons la problématique de la classification de documents par rapport à l’état de l’art. Dans la seconde section, nous détaillons la méthode utilisée pour la réduction de la matrice en composantes latentes (i.e. décrit par interdépendance avec d’autres variables). Enfin, dans la troisième section, nous présentons notre méthodologie pour modéliser la notion de voisinage.

e problème de la classification des textes La catégorisation ou classification automatique des textes est l’investigation par ordinateur des propriétés linguistiques des caractères ASCII qui forment le contenu textuel d’un document numérique. Dans le cadre de l’apprentissage automatique, nous nous référons à la littérature du traitement statistique du langage « naturel » (Natural Langage Processing, NLP) [Manning 2008].

Le processus de classification d’une collection de textes consiste à étiqueter chaque texte avec une ou plusieurs classes (catégories) prédéfinies. Dans ce pro cessus, un algorithme est d’abord conçu, puis il est entraîné avec un ensemble de caractéristiques spécifiques, par exemple les occurrences de mots ou encore les dis tributions de thèmes dans un document. Une fois entraîné, l’algorithme est utilisé pour étiqueter de nouveaux textes.

Ces derniers sont différents des textes utilisés lors de l’entraînement. L’algorithme est évalué sur le nombre d’erreurs de classification obtenu lors de la phase d’apprentissage et lors de la phase de test (voir section 2.2). Lors de l’entraînement de l’algorithme de classification, la phase d’extraction des caractéristiques utilisées pour l’apprentissage est cruciale. Les caractéristiques extraites à partir des textes sont typiquement issues d’un espace vectoriel de grande dimension. Cet espace est construit avec une modélisation vectorielle des mots à l’aide de la sémantique distributionnelle [Harris 1954].