Paramètres initiaux de la synthèse coordonnée.

Le processus de synthèse coordonnée requiert quelques informations complémentaires à celles issues des étapes précédentes de la conception. Le concepteur est invité à renseigner ces para-mètres avant tout lancement d’une procédure de synthèse coordonnée. La figure 5.1 représente la fenêtre de menu du processus de synthèse coordonnée grâce à laquelle le concepteur fixe ces paramètres.

La partie supérieure de la fenêtre concerne la position du point central de montage. Un rappel du placement des dtlm y est fait en utilisant la représentation schématique utilisée dans les menus précédents. Le point central de montage représente le point haut de l’arbre tel que nous l’avons défini en §4.5.1.2. Il fixe l’étagement des diamètres de tronçons d’arbre (figuré par des lignes de contour triangulé symbolisant le profil théorique de l’arbre) et, ce faisant, reflète les règles de montage qui ont été exprimées en amont dans la démarche de conception (cf. chapitre 1). En numérotant les quatre dtlm de la gauche vers la droite, nous constatons que le concepteur a placé le point central de montage entre le dtlm 1 et le dtlm 2. Ceci correspond à un cas de montage mixte où le dtlm 1 verra un montage de ses composants sur l’arbre par le côté gauche et, pour les autres dtlm, un montage de leurs composants sur l’arbre par le côté droit.

La partie médiane de la fenêtre concerne le choix de la méthode de coordination. Le concep-teur peut opter pour trois méthodes de recherche d’une solution optimale globale. En réalité, seuls les algorithmes « Collaborative » et « Relaxation », que nous détaillons ci-après, sont des méthodes de synthèse coordonnée. La première option, qui permet d’effectuer la recherche ex-haustive des combinaisons de dtlm, n’est proposée que dans l’unique objectif de servir d’outil de validation des deux autres méthodes.

Enfin, les derniers boutons lancent la procédure de synthèse et ferment la fenêtre de dialogue. Nous détaillons dans la section suivante les particularités liées aux systèmes décomposés et à leur résolution.

Les systèmes décomposés et leur optimisation.

Pour bien comprendre quelles méthodes de coordination peuvent être adaptées à notre tâche de synthèse coordonnée, nous détaillons ci-après les différents types de décomposition communé-ment utilisés. Nous détaillons ensuite quelques méthodes de résolution de systèmes décomposés et commentons leur éventuelle adéquation avec notre problématique.

Les différents types de décomposition.

Les méthodes de décomposition sont un outil précieux dans le traitement des problèmes d’op-timisation complexes ou de grandes dimensions. Elles permettent de découper le problème initial en sous-problèmes d’optimisation comportant chacun une fonction objectif et des contraintes as-sociées. Deux grandes familles cohabitent : les décompositions hiérarchiques et les décompositions non-hiérarchiques. Nous analysons ces deux familles dans les sections suivantes, en nous inté-ressant particulièrement à leurs caractéristiques propres. Nous ne détaillons pas les méthodes de décomposition ([MGM98] et [Mar99]), puisque notre organisation opérationnelle s’appuie, de facto, sur une décomposition par liaisons mécaniques (les dtlm). Nous cherchons simplement à trouver la meilleure méthode de résolution de notre problème.

Décompositions hiérarchiques.

La décomposition hiérarchique fait apparaître une structure par niveaux. Elle est née de la complexité grandissante des politiques organisationnelles des industries. Elle est représentative d’une politique organisationnelle qui autorise, à de multiples agents concepteurs d’un même niveau hiérarchique, le travail en totale indépendance les uns vis à vis des autres. Les cahiers des charges et résultats ne sont transmis qu’au supérieur immédiat. Il n’existe aucun couplage entre les sous-problèmes d’un même niveau. Ce genre d’architecture peut présenter autant de niveaux que nécessaire. La limite à ce découpage est fonction de la complexité et de la taille du problème global. Le problème est décomposé en sous-problèmes comprenant des variables globales et des variables locales. Chaque ensemble de sous-problèmes est supervisé par un problème de niveau supérieur qui doit gérer les liaisons entre eux. Au sommet de la hiérarchie se trouve le problème maître. Cette structure est à rapprocher des structures humaines présentant des autorités de supervision. Toute la difficulté de gestion du problème d’optimisation globale est reportée sur les problèmes de niveaux hiérarchiques supérieurs. Afin de limiter la quantité d’éléments échangés entre le problème maître et les sous-problèmes, on a souvent recours à des modèles simplifiés et à des indicateurs. L’expertise technique spécifique reste donc confinée dans les sous-problèmes, tandis que les problèmes maîtres les dirigent en fonction des résultats obtenus.

Décompositions non-hiérarchiques.

A l’instar de la décomposition hiérarchique, la décomposition non-hiérarchique relève d’un éclatement en sous-problèmes. Ceux-ci peuvent être couplés par des paramètres de liaison qui sont des informations établies au sein d’un sous–problème mais utilisées aussi comme données par d’autres sous–problèmes. Ces paramètres ne figurent pas nécessairement au rang des variables locales du sous–problème (cf. figure 5.3). La différence notable se situe au niveau des interactions entre sous-problèmes. Il n’existe pas de notion de problème maître et de problèmes esclaves. Tout sous-problème peut posséder des couplages avec tout ou partie des autres sous-problèmes. La gestion de ce genre de problème est délocalisée. Le type de liens ainsi que le choix de l’algorithme de résolution sont très influents sur la qualité du résultat. Tous les sous-problèmes ont le même niveau d’importance.

La difficulté principale inhérente à une décomposition non-hiérarchique réside dans la mise en œuvre d’une méthode de coordination entre les sous-problèmes permettant d’aboutir (ou de s’approcher) au résultat optimal.

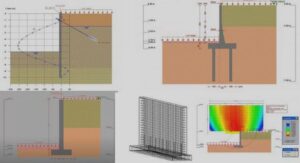

Le problème de synthèse de mécanisme par dtlm est du type non-hiérarchique. On peut assimiler le dimensionnement des dtlm, via les modules de calcul, à des sous–problèmes couplés entre eux par des contraintes (contraintes d’interférence et de montage telles que décrites en §2.2.2). Ces contraintes mettent en jeu des paramètres tels que bgi, bdi, dagi . . . qui ne sont pas des variables globales. La figure 5.4 illustre certaines de ces contraintes à partir de la représentation des tronçons d’arbre. On y distingue les paramètres de liaison. Parmi les méthodes de résolution existantes pour les problèmes non-hiérarchiques, nous nous sommes intéressés à la mdo 1 qui nous est apparue comme la mieux adaptée à la structure modulaire de notre problème.

L’optimisation pluridisciplinaire (mdo).

De nombreux travaux ont porté sur les approches ainsi que sur les méthodes adaptées à la gestion des problèmes de conception, notamment du point de vue des mécanismes de coordination ([WCDH00] et [CWDH00]). Les décompositions présentées ci-avant ont en commun le besoin, parfois impérieux, de viser des objectifs différents, voire souvent antagonistes. La résolution de ces problèmes, présentant une hétérogénéité de la nature des problèmes et objectifs locaux, a favorisé l’émergence des approches en optimisation multidisciplinaire ou mdo Nous présentons les points caractéristiques de ces démarches et nous évaluons l’adéquation potentielle de cette méthode à notre problème.

L’optimisation pluridisciplinaire a vu le jour dans le domaine de la construction aéronautique [Ano91]. Traditionnellement, ce type de construction regroupe des métiers aussi variés que la pro-pulsion, la structure, les commandes ou encore l’aérodynamique. Les recherches les plus récentes ont montré que le couplage entre ces domaines, possédant chacun leurs spécificités théoriques et techniques, pouvait s’avérer très fort. L’optimisation pluridisciplinaire doit être considérée comme un environnement de travail combinant la puissance calculatoire de l’informatique à l’expertise humaine. Ses objectifs sont les suivants :

– condenser les phases majeures de vie du produit que sont la conception, la fabrication et la maintenance pour obtenir un gain de temps, de coûts et de qualité de développement ;

– intégrer les spécificités des différentes disciplines impliquées dans la conception d’un produit (c’est à dire donner une plus grande autonomie aux équipes de conception pour le choix des outils, des méthodes, etc.) ;

– mêler plus intimement les phases de décision et d’action qui bien souvent apparaissent purement séquentielles (travail en parallèle) ;

– retarder au maximum le choix définitif des valeurs des variables de conception (i.e. garder un maximum de liberté dans le processus de conception).

De nombreux aspects ont été pris en compte dans le développement de la démarche, comme les aspects calculatoires (directement liées aux outils et architectures informatiques), les aspects humains (modélisation des processus et structures de décision) et l’aspect optimisation. Bien en-tendu, cette discipline s’inscrit dans la démarche d’ingénierie concourante initiée depuis quelques années. Elle participe activement à son développement en reprenant un certain nombre de ses caractéristiques principales [Ano91].

La conception des systèmes complexes, objet de l’optimisation pluridisciplinaire, fait inévi-tablement appel à des décompositions de tâches. Ceci requiert un processus de coordination intervenant au niveau du système et des sous-systèmes afin de gérer les couplages inévitables. Plusieurs méthodes formelles ont été proposées dans le cadre de la mdo [KS01]. Beaucoup ont en commun une décomposition de la tâche de conception en sous-tâches indépendantes et la pré-sence d’une tâche de coordination, aboutissant alors à un système hiérarchique à deux niveaux. Notons cependant que ce type d’approche peut également s’appliquer à des problèmes com-portant des variables discrètes [BG98]. Nous donnons ci-après quelques caractéristiques souvent associées aux structures mdo :

– une interconnexion aisée et rapide entre les outils d’analyse ;

– une structure robuste d’échange de données ;

– un accès à des méthodes d’études paramétriques ;

– une large bibliothèque d’outils d’optimisation et, plus important encore, une expertise quand au choix de ces méthodes ;

– la disponibilité de nombreuses techniques d’approximation (polynomiales, réseaux neuro-naux ou autres …) ;

– la prise en compte de la nature probabiliste et incertaine d’une part des données de concep-tion ;

– une architecture informatique permettant le traitement parallèle ;

– une visualisation des données de conception à tout instant du processus, etc.

La plupart des méthodes utilisées en mdo font appel au calcul de gradients pour évaluer la sensibilité des différents processus d’optimisation. La détermination de ces gradients est coûteuse en temps de calcul [BS96] et leur nombre croît proportionnellement au nombre de variables et de disciplines (ou sous-problèmes). Certains ont tenté de mettre en œuvre de nouveaux algorithmes basés sur la limitation des domaines d’investigation de chaque sous-problèmes. Ceci a été rendu possible en découplant les sous-problèmes et en analysant la faisabilité et la concordance des résultats postcalculatoire. L’algorithme redistribue alors de nouvelles valeurs aux sous-problèmes modifiant ainsi leur point de départ et leur domaine d’investigation [TF02]. Cette méthode est fortement similaire à une démarche séquentielle et n’évite pas les itérations.