Mécanismes de production de la parole

Le processus de production de la parole est un mécanisme très complexe qui repose sur une interaction entre les systèmes neurologique et physiologique. La parole commence par une activité neurologique. Après que soient survenues l’idée et la volonté de parler, le cerveau dirige les opérations relatives à la mise en action des organes phonatoires. Le fonctionnement de ces organes est bien, quant à lui, de nature physiologique.

Une grande quantité d’organes et de muscles entrent en jeu dans la production des sons des langues naturelles. Le fonctionnement de l’appareil phonatoire humain repose sur l’interaction entre trois entités : les poumons, le larynx, et le conduit vocal. structure cartilagineuse qui a notamment comme fonction de réguler le débit d’air via le mouvement des cordes vocales. Le conduit vocal s’étend des cordes vocales jusqu’aux lèvres dans sa partie buccale et jusqu’aux narines dans sa partie nasale.

La parole apparaît physiquement comme une variation de la pression de l’air causée et émise par le système articulatoire. L’air des poumons est comprimé par l’action du diaphragme. Cet air sous pression arrive ensuite au niveau des cordes vocales. Si les cordes sont écartées, l’air passe librement et permet la production de bruit. Si elles sont fermées, la pression peut les mettre en vibration et l’on obtient un son quasi-périodique dont la fréquence fondamentale correspond généralement à la hauteur de la voix perçue. L’air mis ou non en vibration poursuit son chemin à travers le conduit vocal et se propage ensuite dans l’atmosphère. La forme de ce conduit, déterminée par la position des articulateurs tels que la langue, la mâchoire, les lèvres ou le voile du palais, détermine le timbre des différents sons de la parole. Le conduit vocal est ainsi considéré comme un filtre pour les différentes sources de production de parole telles que les vibrations des cordes vocales ou les turbulences engendrées par le passage de l’air à travers les constrictions du conduit vocal.

Variabilité

Variabilité intra-locuteur : La variabilité intra-locuteur identifie les différences dans le signal produit par une même personne. Cette variation peut résulter de l’état physique ou moral du locuteur. Une maladie des voies respiratoires peut ainsi dégrader la qualité du signal de parole de manière à ce que celui-ci devienne totalement incompréhensible, même pour un être humain. L’humeur ou l’émotion du locuteur peut également influencer son rythme d’élocution, son intonation ou sa phraséologie. Il existe un autre type de variabilité intra-locuteur lié à la phase de production de parole ou de préparation à la production de parole. Cette variation est due aux phénomènes de coarticulation. Il est possible de voir la phase de production de la parole comme un compromis entre une minimisation de l’énergie consommée pour produire des sons et une maximisation des scores d’atteinte des cibles que sont les phonèmes tels qu’ils sont théoriquement définis par la phonétique.

Variabilité inter-locuteur : La variabilité inter-locuteur est un phénomène majeur en reconnaissance de la parole. La cause principale des différences inter-locuteurs est de nature physiologique. La parole est principalement produite grâce aux cordes vocales qui génèrent un son à une fréquence de base, le fondamental. Cette fréquence de base sera différente d’un individu à l’autre et plus généralement d’un genre à l’autre, une voix d’homme étant plus grave qu’une voix de femme, la fréquence du fondamental étant plus faible. Ce son est ensuite transformé par l’intermédiaire du conduit vocal, délimité à ses extrémités par le larynx et les lèvres. Cette transformation, par convolution, permet de générer des sons différents qui sont regroupés selon les classes que nous avons énoncées précédemment. Or le conduit vocal est de forme et de longueur variables selon les individus et, plus généralement, selon le genre et l’âge. Ainsi, le conduit vocal féminin adulte est, en moyenne, d’une longueur inférieure de 15% à celui d’un conduit vocal masculin adulte. Le conduit vocal d’un enfant est bien sûr inférieur en longueur à celui d’un adulte. Les convolutions possibles seront donc différentes et, le fondamental n’étant pas constant, un même phonème pourra avoir

des réalisations acoustiques très différentes. La variabilité inter-locuteur trouve également son origine dans les différences de prononciation qui existent au sein d’une même langue et qui constituent les accents régionaux.

Variabilité due à l’environnement : La variabilité liée à l’environnement peut, parfois, être considérée comme une variabilité intra-locuteur mais les distorsions provoquées dans le signal de parole sont communes à toute personne soumise à des conditions particulières. La variabilité due à l’environnement peut également provoquer une dégradation du signal de parole sans que le locuteur ait modifié son mode d’élocution.

Les moyens de transport peuvent entraîner des déformations du signal, d’origine psychologique. Le bruit ambiant peut ainsi provoquer une déformation du signal de parole en obligeant le locuteur à accentuer son effort vocal. Enfin, le stress et l’angoisse que certaines personnes finissent par éprouver lors de longs voyages peuvent également être mis au rang des contraintes environnementales susceptibles de modifier le mode d’élocution.

Représentation graphique temps/fréquence (Spectrogramme)

Le spectrogramme est un outil de visualisation utilisant la technique de la transformée de Fourier et donc du calcul de spectres. Il a commencé à être largement utilisé en 1947, à l’apparition du sonagraphe , et est devenu l’outil incontournable des études en phonétique pendant de nombreuses années. Il est largement utilisé du fait de sa simplicité de mise en œuvre et du grand nombre d’études qui ont déjà été réalisées. Le spectrogramme permet de mettre en évidence les différentes composantes fréquentielles du signal à un instant donné, une transformée de Fourier rapide étant régulièrement calculée à des intervalles de temps rapprochés. L’axe des abscisses du signal temporel représente le temps alors que l’axe des ordonnées représente l’amplitude du signal. L’axe des abscisses du spectrogramme représente également le temps, l’axe des ordonnées représentant la fréquence qui est, ici, comprise entre 0 et 5512 Hz. Les nuances de grisé du spectrogramme représentent l’énergie du signal pour une fréquence et à un instant donné. L’énergie minimale des spectrogrammes présentés est de 30 décibels (correspondant au gris le plus clair), l’énergie maximale étant, elle, de 100 décibels (correspondant au noir).

L’alignement temporel

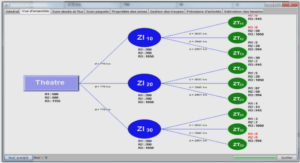

L’alignement temporel, plus connu sous l’acronyme de DTW, Dynamic Time Warping, est une méthode fondée sur un principe de comparaison d’un signal à analyser avec un ensemble de signaux stockés dans une base de référence. Le signal à analyser est comparé avec chacune des références et est classé en fonction de sa proximité avec une des références stockées. Le DTW est en fait une application au domaine de la reconnaissance de la parole de la méthode plus générale de la programmation dynamique. Elle peut ainsi être vue comme un problème de cheminement dans un graphe.

Ce type de méthode pose deux problèmes : la taille de la base de référence, qui doit être importante, et la fonction de calcul des distances, qui doit être choisie avec soin. La taille de la base contenant les signaux de référence est directement liée aux capacités, variables, de reconnaissance du système d’alignement temporel. Chacun des signaux de référence est en effet stocké dans son état brut, sans compression d’aucune sorte. Ce stockage permet de disposer d’un vocabulaire dont la taille correspond au nombre de mots du vocabulaire multiplié par le nombre de locuteurs et le nombre des éventuelles répétitions des mots. Cette base de référence permet d’effectuer une mise en correspondance entre le signal stocké, d’une part, et sa retranscription symbolique d’autre part.

La taille de la base de référence est importante et implique une charge de travail non négligeable puisque la classification de chaque forme à analyser impose de la comparer à chaque forme de la base de référence. Donc, si la constitution de la base de référence est assez rapide et si le processus d’apprentissage est inexistant dans la méthode de l’alignement temporel, la phase d’utilisation nécessite une puissance de calcul non négligeable pour chaque référence atomique de signal à analyser.

Table des matières

Introduction générale

Chapitre I : Caractéristiques du signal parole

Introduction

1.1 Mécanismes de production de la parole

1.2 Mécanismes d’audition de la parole

1.3 Propriétés psycho-acoustiques du système auditif

1.3.1 Échelle d’intensité

1.3.2 Échelle de hauteur

1.4 Complexité du signal parole

1.5 Continuité et coarticulation

1.6 Redondance du signal parole

1.7 Variabilité

1.7.1 Variabilité intra-locuteur

1.7.2 Variabilité inter-locuteur

1.7.3 Variabilité due à l’environnement

1.8 Description acoustique

1.9 L’Alphabet Arabe

1.10 Les classes phonétiques arabes

1.11 Classification Phonétiques

1.11.1 Les Voyelles

1.11.2 Les Occlusives

1.11.3 Les Fricatives

1.11.4 Les Sonnantes

1.11.5 Les Semi-voyelles

1.11.6 Les Liquides

1.11.7 Les Nasales

1.11.8 Les Diphtongues

1.11.9 Les Affriquées

1.11.10 Les Emphatiques

1.12 L’alphabet arabe n’a pas de voyelles

1.12.1 Voyelles simples

1.12.2 Suk-n

Chapitre II : Paramètrisation acoustique du signal parole

2.1 Introduction

2.2 Représentations non paramétriques

2.2.1 Analyse temporelle

2.2.2 Analyse spectrale

2.2.3 Représentation graphique temps/fréquence (Spectrogramme)

2.3 Représentations paramétriques

2.3.1 Chaîne de prés-traitement

2.3.2 L’analyse LPC

2.3.3 LPCC (Linear Prediction Cepstral Coefficients)

2.3.4 Les coefficients PLP (Perceptual Linear Predictive)

2.3.5 Rasta PLP

2.3.6 Analyse cepstrale

2.3.7 L’analyse MFCC

2.3.8 Produit spectral et la fonction de temps de groupe

2.3.8.1 Définition de la fonction de temps de groupe

2.3.8.2 Produit spectral

2.3.8.3 Paramètres acoustiques cepstrals

2.3.8.4 Les coefficients cepstrals de la fonction de temps de groupe (MGDCC)

2.3.8.5 Les coefficients cepstrals de la fonction de temps de groupe modifiée (MFGDCC)

2.3.8.6 Les coefficients cepstrals du produit spectral (MFPSCC)

2.4 Les coefficients différentiels

2.5 Evaluation des paramètres acoustiques étudiés par le système de RAP de référence

2.5.1 Evaluation des performances du système ASR en présence du bruit blanc

2.5.2 Evaluation des performances du système ASR en présence du bruit rose

2.5.3 Evaluation des performances du système ASR en présence du bruit industriel

2.5.4 Evaluation des performances du système ASR en présence du bruit du cockpit F16

2.5.5 Discussion des résultats

2.6 Conclusion

Chapitre III : Systèmes de reconnaissance automatique de la parole

3.1 Introduction

3.2 L’alignement temporel

3.2.1 Distance globale

3.3 Les Modèles de Markov cachés

3.3.1 Définitions

3.3.2 Les trois problèmes de base en HMMs

3.3.2.1 Evaluation de la vraisemblance

3.3.2.2 Le décodage

3.3.2.3 L’apprentissage

3.3.3 Résolution des trois problèmes

3.3.3.1 Problème 1: Estimation des probabilités

a) Algorithme de forward

b) Algorithme de backward

3.3.3.2 Probleme2: le décodage

3.3.3.2.1 Algorithme de Viterbi

3.3.3.3 Problème d’estimation des paramètres et entraînement des modèles

3.3.3.3.1 Entraînement Baum-Welch

3.3.4 Cas des modèles continus

3.4 Plate-forme logicielle HTK

3.4.1 Utilisation d’HTK

3.5 Autres méthodes de reconnaissance

3.5.1 Les réseaux de neurones: le perceptron multi-couches (PMC)

3.5.2 Le Perceptron Multi-Couches (PMC)

3.5.3 Les Machines à Vecteurs Support (SVM)

3.5.4 Méthodes « hybrides »

3.5.4.1 HMM et réseaux de neurones

3.5.4.1 HMM et SVM

Chapitre IV : Application des ondelettes au signal de la parole

4.1 Présentation des ondelettes

4.1.1 Introduction

4.1.2 Définitions

4.1.2.1 Les ondelettes

4.1.2.2 La transformée en ondelettes

4.1.3 La transformée en ondelettes discrète utilisée pour le débruitage de la parole

4.1.4 Algorithme rapide pour la transformée en ondelettes

4.2 Types d’ondelettes utilisées

4.2.1 Les ondelettes de Daubechies

4.2.2 Les Symlets

4.2.3 Les Coiflet

4.3 Types d’énergies calculées sur les coefficients d’ondelettes

4.3.1 L’énergie instantanée

4.3.2 L’énergie de Teager

4.3.3 L’énergie hiérarchique

Chapitre V : Nouveau paramètre acoustique pour la reconnaissance robuste

5.1 Introduction

5.2 Description de l’algorithme de paramétrisation

5.2.1 Segmentation en fenêtre

5.2.2 Décomposition du signal parole par paquet d’ondelettes

5.2.3 Débruitage par les algorithmes de seuillage

5.2.3.1 Algorithme de seuillage dur

5.2.3.2 Algorithme de seuillage doux

5.2.3.3 Algorithme de seuillage doux modifié

5.2.4 Sélection du seuil

5.2.4.1 Seuil obtenu par la méthode universelle

5.2.4.2 Seuil obtenu par la méthode pénalisé

5.2.5 Comparaison entre les différents types de seuillage

5.2.6 Reconstitution du signal parole

5.2.7 Définition des coefficients de Mel cepstral du produit spectrale

5.2.8 Coefficients différentiels

5.2.9 Comparaison graphique entre les différents types de paramètres acoustiques

5.3 Développement du système de reconnaissance

5.3.1 Description de la base de données

5.3.2 Le corpus de bruits NOISEX-92

5.3.3 Description du système de reconnaissance de référence à base des HMMc

5.4 Expérimentation et résultats

5.4.1 Evaluation des performances du ASR en présence du bruit blanc

5.4.2 Discussion des résultats

5.4.3 Evaluation des performances du ASR en présence du bruit rose

5.4.4 Discussion des résultats

5.4.5 Evaluation des performances du ASR en présence du bruit industriel

5.4.6 Discussion des résultats

5.4.7 Evaluation des performances du ASR en présence du bruit de cockpit de l’avion F16

5.4.8 Discussion des résultats

Conclusion générale

Perspective

Références bibliographiques