Caractérisation des écarts modèle observations pour une simulation sans assimilation

Les modèles d’océan, libres (i.e sans assimilation de données) et forcés par des états atmosphériques réalistes sont utilisés pour comprendre la dynamique océanique et les processus conduisant à la circulation moyenne et à sa variabilité. Les simulations numériques et les observations océaniques sont complémentaires. Leur utilisation conjointe est très utile pour les investigations de la variabilité océanique observée ainsi que pour les études de reproductibilité de la variabilité des indices climatiques (Juza [2011]). Enfin, les simulations, telles que la simulation globale utilisée dans cette thèse, peuvent être utilisées pour guider les déploiements des futurs réseaux d’observations. Dans ce chapitre, nous allons souligner l’intérêt de l’utilisation des données Argo pour valider une simulation numérique. L’anal- yse présentée permet de caractériser les erreurs modèles afin d’estimer dans quelle mesure la simulation numérique diffère de la réalité observée par Argo. Cette étude passe par un ensemble d’étapes de description et de traitements statistiques décrits dans la section 3.1, puis par la présentation du modèle dans la section 3.2 d’une part et celle des observations dans la section 3.3 d’autre part. Enfin l’analyse des différentes statistiques les plus significatives entre la simulation et le jeu d’obser- vation est faite en section 3.4.

Méthodes statistiques

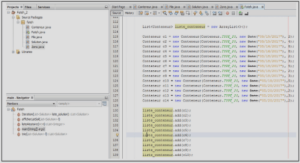

Colocalisation 4D du modèle et des observations Pour comparer les don- nées hydrographiques Argo et la simulation numérique réaliste utilisée dans cette thèse, il est nécessaire de calculer la valeur du modèle au point d’observation. Les sorties modèles utilisées sont des champs de température et de salinité T/S(x,y,z,t) journaliers. Ainsi les champs de température et de salinité T/S(x,y,z,t), simulés sont colocalisés dans l’espace des observations. Cette interpolation est faite de façon quadri-linéaire, à partir des points les plus proches de l’espace spatio-temporel (x, y, z, t) du modèle vers l’espace des profils observés. Le but étant de constituer une base de profils hydrographiques simulés colocalisée, parsemée dans le temps et l’espace de manière identique aux observations. Ce travail repose sur un code écrit en fortran 90, déjà existant au sein de Mercator Océan (métriques développées par Charly Regnier). Enfin nous utilisons dans cette thèse des données in-situ cli- matologiques issues du World Ocean Atlas 2009 couvrant la période (1955-2006), documentées dans Locarnini et al. [2010] et Antonov et al. [2010] et notées Levi- tus par la suite. L’étape de colocalisation a aussi été réalisée sur les champs cli- matologiques en température et salinité en prévision de leur utilisation dans les chapitres .

Traitement statistique en temps et en espace

Les profils Argo peuvent s’échelonner de la surface jusqu’en profondeur tous les mètres, voire tous les 5 mètres. La stucture verticale des masses d’eaux est décrite via une échelle non homogène le long de la colonne d’eau. Aussi chaque point vertical est rangé en fonction du niveau standard de la climatologie Levitus auquel il appartient (c’est-à-dire par couche homogène suffisamment fine en surface et à plus grande épaisseur en profondeur). La résolution verticale des boîtes choisie correspond aux 26 premiers niveaux standards de la climatologie Levitus, définis de 0 à 2000 mètres (la profondeur de plongée maximale des flotteurs Argo) :tion des observations en température et salinité (figures 3.1.a et 3.2.a) permet de garder un regard critique sur les estimations statistiques en fonction des régions observées et de s’assurer de leur robustesse. Le nombre d’observations par boîtes en surface sur la période 2006-2009 est en moyenne supérieure à 500 dans l’océan Pacifique et compris entre 100 et 250 dans l’océan Atlantique. Notons que les an- nées antérieures à 2009 révèlent une forte chute du nombre de profils disposant de données comprises entre 1500 et 2000 mètres (Cabanes et al. [2013]).

Les figures 3.1.b et 3.2.b représentent la couverture spatiale en températureet salinité entre 1000 et 2000 mètres. Dans les autres bassins océaniques le nom- bre d’observations disponibles dans les couches en profondeur est compris entre 150 et 250, voire supérieure à 500 pour les hautes latitudes. Par conséquent la densité d’observations de la surface à 2000 mètres à cette résolution spatiale et cumulée sur la période 2006 − 2009 pourra donner lieu à des résultats statistiques robustes. Puis l’analyse des écarts [modèle-observations] en température et salinité passe par le choix des indicateurs statistiques les plus représentatifs. On utilisera les écarts moyens [modèle-observations] en moyenne annuelle et saisonnière sur la période 2006-2009 (figures 3.8 à 3.14 et celles comprises dans l’annexe A). Enfin on s’affranchit de la dimension horizontale pour observer les séries temporelles des écarts moyens [modèle-observations] sur la période 2006-2009 (figures 3.6 et 3.7).

Kallberg [2011] montre un biais systématique dans les prévisions à court termede certaines variables du modèle généré dans ERA/interim. Il compare notam- ment les prévisions du flux de précipitation provenant de la réanalyse ERA/interim avec les données issues du GPCPV2.1 (Global Precipitations Climatology Project, Huffman et al. [2009]). De manière générale la réanalyse ERA/interim révèle des précipitations plus élevées que celles estimées à partir des données GPCPV2.1 sur l’ensemble des océans tropicaux (Dee et al. [2011]). Un déséquilibre est aussi présent dans le flux radiatif net de chaleur à la surface, biais issus principalement de la représentation des nuages, notamment sur les zones “d’upwelling” côtières. Une méthode de correction a donc été appliquée lors de l’utilisation des flux radi- atifs descendants de chaleur et de précipitations issus de la réanalyse ERA/interim afin de forcer le modèle. Cette méthode de correction utilise les données satellites GPCPV2.1 et Gewex SRB (Surface Radiation Budget, Stackhouse et al. [2011]) pour corriger uniquement la composante grande échelle du forçage sans impacter la variabilité synoptique (cyclone) et la variabilité interannuelle du signal. Cette méthode a permis de corriger partiellement le biais d’eau douce positif présent sur les 20 ans de la simulation T 335. En effet la figure 3.3 représente les conséquences de la méthode de correction sur la salinité de surface. On peut observer que la salinité de surface (courbe orange) est supérieure à celle estimée par une expéri- ence sans correction des précipitations (courbe bleue). Cependant la salinité de surface obtenue après correction est aussi supérieure à celle estimée .