Les premières briques qui ont été posées pour la création de la fouille de données d’aujourd’hui remontent aux années 50 quand les travaux des mathématiciens, des logiciens et des informaticiens ont été combinés pour créer l’apprentissage automatique [31] et l’intelligence artificielle (IA) [47]. La volonté de rendre les machines intelligentes et capables de prendre des décisions à la place de l’expert a permis l’émergence de ce dernier domaine.

Le développement de l’IA et du domaine des statistiques ont permis la conception de nouveaux algorithmes tellement intéressants qu’ils sont utilisés de nos jours dans la fouille de données, comme l’analyse de régression [48], les réseaux de neurones [49] et les modèles linéaires de classification [50], etc. Le terme fouille de données « Data Mining » est apparu dans cette même période, les années 60, pour désigner la pratique de fouiller les données pour trouver des motifs qui n’avaient aucune signification statistique [39]. Le domaine de la récupération d’informations « information retrieval » [51] a fait sa contribution lui aussi dans cette même période par les techniques de segmentation et de mesure de similarité [52].

L’année 1971 est une année très importante dans l’histoire de la fouille de données. Durant cette année, Gerard Salton a publié ses travaux innovateurs sur le système « SMART Information Retrieval » et a présenté une nouvelle approche de recherche d’information qui a utilisé un modèle basé sur l’algèbre d’espace vectoriel. Ce modèle se révélera être un ingrédient clé dans la boîte à outils de la fouille de données [40].

Après cette année, plusieurs autres algorithmes très importants ont vu le jour comme les algorithmes génétiques, le k-means [32] pour la segmentation et les algorithmes des arbres de décisions, etc. Aux années 90 et pour la première fois, le terme entrepôt de données « Data Warehouse » [53] a été utilisé pour décrire une grande base de données composée d’un schéma unique, créé à partir de la consolidation des données opérationnelles et transactionnelles d’une ou plusieurs bases de données. C’est durant cette même période que la fouille de données a connu son grand lancement en cessant d’être juste une technologie intéressante et en devenant une partie intégrante des pratiques standards du monde des affaires [40]. En effet, les entreprises ont commencé à utiliser la fouille de données pour les aider à gérer toutes les phases du cycle de vie des clients, à augmenter les recettes provenant des clients existants, à conserver les bons clients et même à la recherche de nouveaux clients. Plusieurs facteurs ont participé à ce que les entreprises adoptent la fouille de données, la chute des coûts relatifs au stockage des données sur les disques informatiques, l’augmentation de la puissance du traitement des informations et surtout, les avantages de l’exploration des données sont devenus plus apparents.

De nos jours, la FD est utilisée dans des domaines très variés, comme la télécommunication, la sécurité, le marketing, la finance, le marché boursier et le commerce électronique, la santé, etc. Même les gouvernements n’hésitent plus à l’utiliser dans leurs projets. En 2004, dans le rapport des activités fédérales sur la fouille de données, le bureau de comptabilité générale des États-Unis [54] a signalé qu’il y a 199 opérations de fouille de données en cours ou prévu dans les divers organismes fédéraux, et cette liste n’inclue pas les activités secrètes de la fouille de données comme MATRIX ou le système d’écoute de la NSA.

Définition de la fouille de données

La définition la plus complète de la fouille de données, à notre avis, est celle présentée par Benoît [55] qui stipule que : la fouille de données est un processus, à plusieurs étapes, d’extraction de connaissances préalablement imprévues à partir de grandes bases de données, et d’application des résultats pour la prise de décision. En d’autres termes, les outils de la fouille de données détectent des motifs à partir des données et déduisent des associations et des règles. Les connaissances extraites peuvent ensuite être appliquées à la prédiction ou à la création de modèles de classification en identifiant les relations au sein des enregistrements de données ou entre des bases de données. Ces motifs et règles peuvent alors guider à la prise de décision et à la prévision des effets de ces décisions. Concrètement, la fouille de données est comme tout autre programme informatique. Elle prend des entrées, normalement de grandes tailles, les analyse et les traite pour en extraire, non pas des données déjà existantes, mais des connaissances. Enfin, elle formule ces connaissances sous un format compréhensible et les présente comme sortie à l’utilisateur.

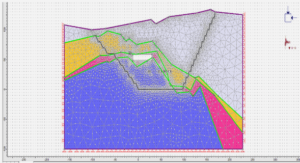

Les différentes techniques de la fouille de données permettent de travailler sur tous les types de données existants. Si les fichiers plats, qui contiennent du texte ou des données binaires avec une structure bien déterminée, sont les entrées les plus courantes [56], d’autres entrées sont de plus en plus exploitées par ces techniques comme les bases de données avec des attributs de différents formats : texte, entier, réel, etc. ou les bases de données qui comportent des attributs spéciaux en plus de ceux cités : les bases de données multimédias avec des attributs de type sons, images ou vidéos, les bases de données spatiales avec des attributs de type cartes géographiques, des positions régionales ou globales ou toute autre donnée géographique et les bases de données temporelles spécifiant pour chaque enregistrement le temps de sa sauvegarde dans la base de données (temps de transaction) et le temps où il s’est déroulé dans le monde réel (temps valide).

Chapitre 1 – Introduction |